随着AI模型的普及应用与高速发展,主要的云厂商与AI大厂提供了对应的服务支持,使得业务的应用可以轻松对接AI算法,使其在实际项目中落地。

我个人也是极度推崇在项目中应用AI算法更轻松更数智化的兑现功能。

虽然AI门槛很高,但随着时间的推移与AI模型的发展,我相信对于普通的程序猿来说,还是可以入手且实际开发应用AI算法模型。

阅读《基于 Flink ML 搭建的智能运维算法服务及应用》一文后,对其中日志聚类算法有了些思考。

概述

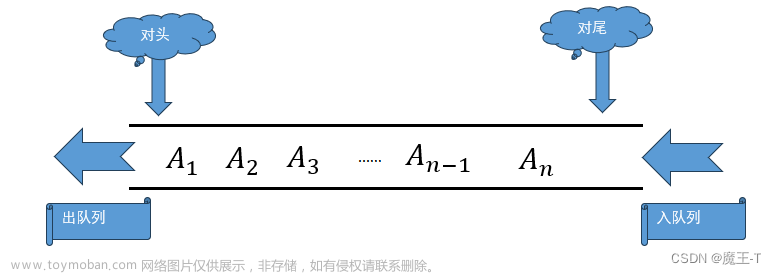

日志聚类,简而言之是对海量日志的分析;其分析处理链路可以分为如下流程:日志采集 -> 预处理 -> 分词和特征表示 -> 聚类和标注;也可以概述为数据收集及预处理、文本向量化、文本相似度计算、文本分类四部分。

算法模型分析

针对如上的链路流程做一个拆分叙述。

日志采集

常用的日志采集方案是写完数据库多写一遍ElasticSearch;目前我个人推荐的方案是基于Flink CDC组件来采集。

预处理

一般来说,预处理阶段是在业务中常用的一个阶段,根据业务的不同做不同的处理,比如精简文本删除不必要的语气词、标点符号、替换占位符等等。日志一般都是非结构化的文本类型数据,由于开发人员的开发习惯与团队开发规范的约束,每个人记录的日志模板可能是不一样的,因此,需要对日志文本做一次常见的预处理—————删除不必要的语气词等。

分词和特征表述

分词

其实对于分词,我一开始想到的就是ElasticSearch中很重要的一个组件模块——————分析器。分析器由字符过滤器、分词器、词语(token)过滤器组成。在我看来,预处理流程与分词流程其实可以归纳为分析器的处理。

对于分词,当前主要有两种算法,一种是基于已有的词典库,一种是基于统计的机器学习。

基于词典的分词算法分为以下几种:正向最大匹配法、逆向最大匹配法和双向匹配分词法等。基于词典的分词算法是应用最广泛、分词速度最快的。基于统计的机器学习算法法是HMM、CRF、SVM、深度学习等算法,比如stanford、Hanlp分词工具是基于CRF算法。

常见的分词器都是使用机器学习算法和词典相结合,一方面能够提高分词准确率,另一方面能够改善领域适应性。

特征表述

将分词后的词作为特征列表,基于此列表,对日志做向量化的构建。通过TF-IDF算法对关键词做统计分析,得到词向量后,再做一次相似度比较,最终就可以得到向量。

其实我理解这里就是在做文本相似度匹配的处理。一般都是处理文本向量化。

聚类

最后通过聚类算法:层次聚类算法、K-means算法等来得到我们的聚类结果,也就是各个日志模板所对应的日志类别。

总结

在上份工作中,其实就遇到了类似的问题,当时我们有大量的日志数据,且需要基于这些日志数据做分析推送对应的解决策略以及解答给客户或是一线。但由于当时所有的开发人员都做的是业务开发,对机器学习及应用压根就不清楚(严格来说,都没有考虑过从这方面入手),所以导致当时的运维量和客户的反馈不太好;当时我花了不少时间分析过如何解决,受限于当时的认知与能力,画过一个简单的流程图,但很难落地,而且没有足够的理论与算法的支持,相比较现在的解决方案,那真是没眼看。目前来看,日志聚类的应用完全是可以落地到当时的业务上的。

参考

基于 Flink ML 搭建的智能运维算法服务及应用

对智能化运维中日志聚类分析的一些思考

SREWorks v1.5 版本发布 | 基于实时作业平台的日志聚类开源文章来源:https://www.toymoban.com/news/detail-595244.html

揭秘阿里云Flink智能诊断利器——Fllink Job Advisor文章来源地址https://www.toymoban.com/news/detail-595244.html

到了这里,关于聊聊日志聚类算法及其应用场景的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!