完整报错:

RuntimeError: CUDA out of memory. Tried to allocate 160.00 MiB (GPU 0; 10.76 GiB total capacity; 9.58 GiB already allocated; 135.31 MiB free; 9.61 GiB reserved in total by PyTorch)

问题分析:

内存分配不足:需要160MB,,但GPU只剩下135.31MB。

解决办法:

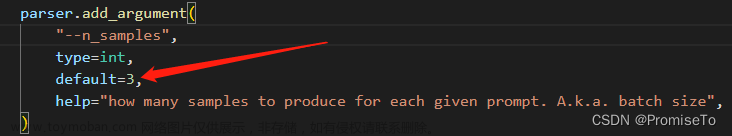

1.减小batch_size。注意batchsize的调整要配合学习率的调整,一般是正比关系,BS增大两倍,LR增大两倍或者根号二倍。减小也是相应更改。

2.运行torch.cuda.empty_cache()函数。加在训练开始前即可。

3.释放GPU内存,kill掉没用的进程。

4.更改使用的显卡。这里大多指在服务器上运行,没有制定显卡,都默认使用第一张,或者多人使用,产生的不足。

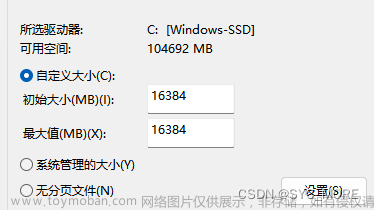

5.降低num_workers,num_workers参数是加载数据的线程数目,有可能电脑(服务器)的线程数不满足所配置的参数。如果电脑是8线程,参数调为8就不合适,可相应降低。但num_worker越小,训练越慢,可权衡后调整。文章来源:https://www.toymoban.com/news/detail-598044.html

综合调小了num_workers和 batch_size后,报错消失,代码正常运行。以上五种方法都试一下,大部分报错可解决。文章来源地址https://www.toymoban.com/news/detail-598044.html

到了这里,关于解决:RuntimeError: CUDA out of memory. Tried to allocate 160.00 MiB (GPU 0; 10.76 GiB total capacity..的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!