过拟合

过拟合(Overfitting)是机器学习和深度学习中常见的问题,指模型在训练数据上表现得非常好,但在新数据上表现较差,即模型过度拟合了训练数据的特征,导致泛化能力不足。

解决过拟合的方式包括以下几种:

-

数据集扩充:增加更多的训练样本,使得模型能够学习更多不同的数据模式,从而减少过拟合。

-

简化模型:减少模型的复杂度,避免模型过度拟合训练数据。可以通过减少网络层数、减少神经元数量、降低多项式回归的次数等方式简化模型。

-

正则化(Regularization):通过在损失函数中添加正则化项,惩罚复杂模型的权重,防止权重过大而导致过拟合。常见的正则化方法包括L1正则化和L2正则化。

-

交叉验证(Cross-validation):将数据集分为训练集和验证集,用验证集来评估模型的性能,避免在训练过程中过度拟合训练数据。

-

提前停止(Early Stopping):在模型训练过程中,监控验证集的性能,当验证集性能不再提升时,停止训练,防止过度拟合。

-

集成学习(Ensemble Learning):通过将多个不同的模型组合起来,形成一个更强大的模型,可以减少过拟合的风险。常见的集成学习方法包括随机森林和梯度提升树。

-

特征选择:选择最重要的特征,去除对模型性能影响较小的特征,从而减少过拟合的可能。

-

Dropout:在神经网络中引入Dropout层,随机丢弃一部分神经元,防止模型过度依赖特定的神经元,增加模型的泛化能力。

选择合适的解决方式取决于具体的问题和数据集。通常,通过综合应用上述方法,可以有效地减少过拟合问题,提高模型的泛化能力。

欠拟合

欠拟合(Underfitting)是机器学习和深度学习中另一个常见的问题,指模型在训练数据上表现不佳,也无法在新数据上取得很好的预测结果,即模型未能充分拟合训练数据的特征,导致在训练集和测试集上都表现较差。

解决欠拟合的方式包括以下几种:

-

增加模型复杂度:如果模型欠拟合,可能是因为模型的复杂度不够,无法捕捉数据的复杂模式。可以尝试增加模型的层数、增加神经元数量或使用更复杂的模型结构。

-

数据增强:增加更多的训练样本,或通过数据增强技术,对现有训练样本进行扩充,使得模型能够更好地学习数据的特征。

-

特征工程:对数据进行特征工程,选择更有代表性的特征,或者使用领域知识来增强模型的特征表达能力。

-

正则化:虽然正则化主要用于解决过拟合问题,但在某些情况下,适当的正则化也可以帮助减少欠拟合。可以尝试使用较小的正则化项,以减少模型的过度简化。

-

减少特征数量:如果特征过多而导致欠拟合,可以考虑减少特征数量,保留最重要的特征。

-

增加训练迭代次数:在训练模型时,增加迭代次数,使得模型更充分地学习数据的特征。

-

集成学习:通过集成多个不同的模型,形成一个更强大的模型,可以提高模型的泛化能力,从而减少欠拟合问题。

-

调整超参数:适当调整模型的超参数,如学习率、批次大小等,可能有助于解决欠拟合问题。

选择合适的解决方式需要根据具体问题和数据集来进行调整。解决欠拟合问题通常需要反复尝试不同的方法,以找到适合当前情况的最佳解决方案。

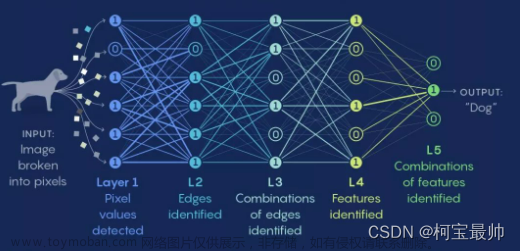

Dropout

Dropout是一种用于训练深度神经网络的正则化技术,它可以有效地减轻过拟合问题。在训练和测试过程中,Dropout的行为是不同的。

在训练过程中,Dropout会随机地将网络中的一些神经元的输出置为零(即丢弃),并且在每个训练样本上都会随机选择不同的神经元进行丢弃。这样做的效果是,在每次训练迭代中,模型都会看到不同的网络结构,从而增加了网络的鲁棒性,并减少了对某些特定神经元的依赖性。在训练过程中,Dropout可以看作是对多个不同的子网络进行集成学习,这有助于防止过拟合。

而在测试过程中,Dropout不会起作用,即所有的神经元都会被保留。这是因为在测试时,我们希望得到确定性的预测结果,并且不希望随机丢弃神经元,否则会导致结果不稳定。文章来源:https://www.toymoban.com/news/detail-601907.html

因此,Dropout在训练过程中起到了正则化的作用,帮助减轻过拟合问题;而在测试过程中,Dropout不起作用,保留所有神经元,以获得稳定的预测结果。这种训练和测试时Dropout行为的差异是Dropout在深度神经网络中有效工作的关键。文章来源地址https://www.toymoban.com/news/detail-601907.html

到了这里,关于神经网络小记-过拟合与欠拟合的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!