Windows:10 JDK:1.8 Apache Hadoop:2.7.0

Apache Hive:2.1.1 Apache Hive src:1.2.2 MySQL:5.7

1、下载

Hadoop搭建

Apache Hive 2.1.1:https://archive.apache.org/dist/hive/hive-2.1.1/apache-hive-2.1.1-bin.tar.gz

Apache Hive 1.2.2 src:https://archive.apache.org/dist/hive/hive-1.2.2/apache-hive-1.2.2-src.tar.gz

MySQL驱动下载:MySQL :: Begin Your Download或使用我下载好的(百度网盘 提取码:1024)

这里是以我安装版本,搭建操作都是一样的。

2、Hadoop和Hive版本

注意:Hive中对应的Hive版本最好不要比你安装的Hadoop版本高。

可以在解压后的Hive src中的pom.xml文件中查看:

文章来源地址https://www.toymoban.com/news/detail-602412.html

3、Mysql驱动配置

将下载好的MySQL驱动解压,将mysql-connector-java-5.1.46目录下的mysql-connector-java-5.1.46-bin.jar复制到apache-hive-2.1.1-bin\lib目录下。

4、配置变量

HIVE_HOME:

PATH:

注意:以自己存放路径为准,E:\hadoop\..只是我自己的存放位置,下面相关路径操作同理。

5、修改配置文件名

找到apache-hive-2.1.1-bin\conf目录下的4个文件,重命名:

hive-default.xml.template -----> hive-site.xml

hive-env.sh.template -----> hive-env.sh

hive-exec-log4j.properties.template -----> hive-exec-log4j2.properties

hive-log4j2.properties.template -----> hive-log4j2.properties

6、创建目录

\apache-hive-2.1.1-bin\my_hive

\apache-hive-2.1.1-bin\my_hive\operation_logs_dir

\apache-hive-2.1.1-bin\my_hive\querylog_dir

\apache-hive-2.1.1-bin\my_hive\resources_dir

\apache-hive-2.1.1-bin\my_hive\scratch_dir

7、修改配置

修改hive-env.sh

修改hive-site.xml

四个新建文件路径配置:

连接数据库相关配置:

账号是否为root,密码是否为123456,端口是否为3306,如果不一样,就需要更改。

注意:useSSL=false要放最后,不然后面启动hive metastore服务会报错

8、在Hadoop上创建HDFS目录

hdfs dfs -mkdir -p /tmp

hdfs dfs -mkdir -p /user/hive/warehouse

hdfs dfs -chmod 777 /tmp

hdfs dfs -chmod 777 /user/hive/warehouse

9、创建数据库

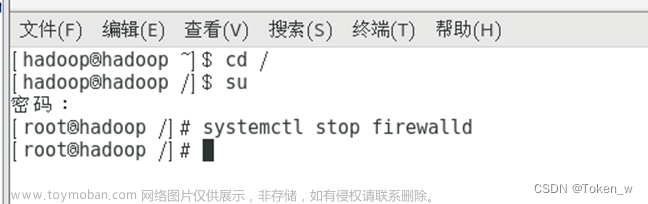

10、启动Hadoop

到Hadoop的sbin目录下右键管理员身份运行start-all.cmd,或命令运行:start-all.cmd

11、启动hive metastore服务

以管理员身份打开cmd,目录切换到\apache-hive-2.1.1-bin\bin,输入命令:hive --service schematool -dbType mysql -initSchema。

使用命令hive --service metastore的启动方式不适合Windows

如果在mysql中hive表中出现下图中许多表的情况,则说明开启成功。

只需要在第一次启动,之后再使用Hive就不需要再启动,可跳过这个阶段。

12、启动hive

以管理员身份打开cmd,目录切换到\apache-hive-2.1.1-bin\bin,输入命令:hive.cmd

尝试建一个表:create table stu(id int, name string),如果创建成功可以在管理界面看见:

文章来源:https://www.toymoban.com/news/detail-602412.html

文章来源:https://www.toymoban.com/news/detail-602412.html

到了这里,关于Hadoop——Hive运行环境搭建的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!