随着 GPU 技术的不断进步,许多机器学习和深度学习任务都需要 GPU 来进行高效计算。但是,设置和管理基于 GPU 的环境可能非常具有挑战性,尤其是在处理多个软件依赖项和版本时。Docker 容器通过使您能够将应用程序和依赖项打包到一个可以在任何机器上运行的单个可移植容器中来解决此问题,而不管底层硬件和软件配置如何。

在这篇博文中,我们将指导您完成设置支持 CUDA 的 Docker 容器的过程,这将使您能够轻松运行基于 GPU 的应用程序。

安装 Docker

首先,你需要在你的机器上安装 Docker。安装过程因操作系统而异。您可以在官方Docker 网站上找到详细说明。

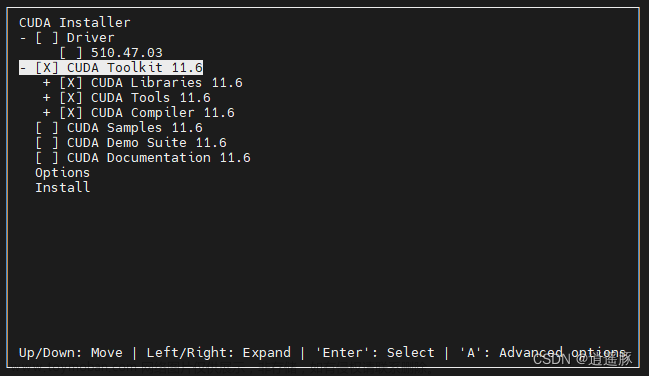

安装 NVIDIA cuda

这里我们假设您已经在您的机器上安装了 Nvidia Cuda。如果没有,您可以按照此处的指南进行操作。

测试

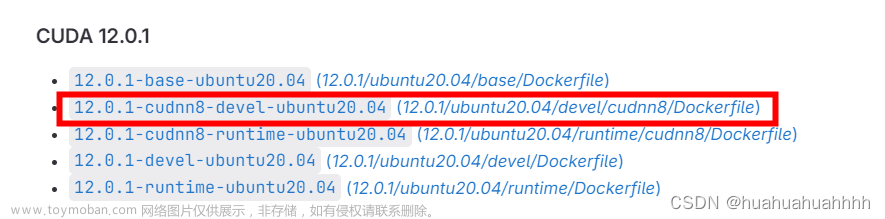

如果一切安装正确,这里的代码应该如下图所示。[不要恐慌; 解释一下发生了什么]

docker run -it --gpus all nvidia/cuda:11.4.0-base-ubuntu20.04 nvidia-smi

文章来源:https://www.toymoban.com/news/detail-603039.html

文章来源:https://www.toymoban.com/news/detail-603039.html

现在我们知道我们的机器已经准备好在 docker 容器上使用 Cuda。现在让我们解释一下我们上面做了什么:文章来源地址https://www.toymoban.com/news/detail-603039.html

到了这里,关于Docker 中的 Cuda:变得简单的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!