本篇文章是博主在人工智能等领域学习时,用于个人学习、研究或者欣赏使用,并基于博主对人工智能等领域的一些理解而记录的学习摘录和笔记,若有不当和侵权之处,指出后将会立即改正,还望谅解。文章分类在学习摘录和笔记专栏:

学习摘录和笔记(23)---《当深度强化学习(DRL)遇见图神经网络(GNN)》

当深度强化学习(DRL)遇见图神经网络(GNN)

原文/论文出处:

- 题目:《当深度强化学习遇见图神经网络》

- 时间:2019-10-21

- 来源:专知

1 图神经网络(GNN)

将图神经网络(GNN)与深度强化学习(DRL)相结合。新的DRL+GNN体系结构能够在任意网络拓扑图上学习、操作和生成。

图神经网络(Graph Neural Networks,GNN)是一种新型的神经网络,用于对图结构信息进行操作。它们的基本形式是将一些初始状态与图中的不同元素相关联,然后结合这些元素在图中的相互关系。迭代算法更新状态元素并使用最终状态产生输出.

2 深度强化学习(DRL)

深度强化学习(Deep Reinforcement Learning, DRL)的最新进展在决策问题上显示出了重要的改进。网络社区已经开始研究DRL如何为相关的优化问题(如路由routing)提供新的解决方案。然而,大多数最先进的基于DRL的网络技术无法生成(generalize),这意味着它们只能在训练期间看到的网络拓扑图上运行,而不能在新的拓扑图上运行。这一重要限制背后的原因是,现有的DRL网络解决方案使用标准的神经网络(例如全连接),无法学习图形结构的信息。

DRL算法的目标是学习一种策略,使优化问题的累积报酬最大化。

该学习过程由一组动作A和一组状态S组成。给定一个状态s∈S,Agent将执行一个a∈A的动作,该动作产生一个新的状态s∈S的转换,并提供一个奖励r,这个优化问题可以被建模为一个马尔可夫决策过程(MDP)。然而,对于MDP的解决方案,需要评估状态-动作对的所有可能组合。

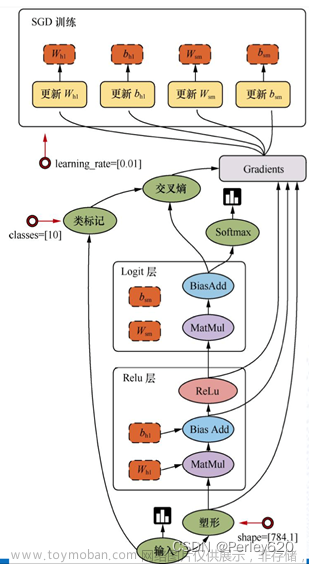

3 DRL训练伪代码

提出了DRL+GNN智能体,智能体实现了DQN算法,其中Q值函数是用GNN建模的。伪代码如下:

//Algorithm 1 DRL Agent Training algorithm

for it in Iterations do

for episode in Training_eps do

s, d,src,dst <– env.reset_env()

reward – 0

while TRUE do

a, s' <– agt.act(s, d, src, dst)

r, done, d', src', dst' <– env.step(s')

agt.rmb(s,d,src,dst, a,r,s',d',src',dst')

reward <– reward + r

If done == TRUE : break

If len(agt.mem) > batch_size : agt.replay()

d <- d',s <- s', dst <- dst'

for episode in Evaluation_eps do

s, d, src,dst <– env.reset_env()

reward – 0

while TRUE do

a, s' <– agt.act(s, d, src, dst)

r, done,d',src', dst' – env.step(s')

reward – reward + r

If done then break4 结论与展望

提出了一种基于GNNs的DRL体系结构,能够推广到不可见的网络拓扑。使用GNNs对网络环境建模,允许DRL智能体在不同网络中操作,而不是只在用于训练的网络中。

缺乏泛化是阻碍在生产网络中部署现有的基于DRL的解决方案的主要障碍。因此,所提出的体系结构是开发新一代基于DRL的网络产品的第一步。文章来源:https://www.toymoban.com/news/detail-607668.html

文章若有不当和不正确之处,还望理解与指出。由于部分文字、图片等来源于互联网,无法核实真实出处,如涉及相关争议,请联系博主删除。如有错误、疑问和侵权,欢迎评论留言联系作者,或者关注VX公众号:Rain21321,联系作者。文章来源地址https://www.toymoban.com/news/detail-607668.html

到了这里,关于当深度强化学习(DRL)遇见图神经网络(GNN)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!