Title: Training-free Object Counting with Prompts

Abstract: This paper tackles the problem of object counting in images. Existing approaches rely on extensive training data with point annotations for each object, making data collection labor-intensive and time-consuming. To overcome this, we propose a training-free object counter that treats the counting task as a segmentation problem. Our approach leverages the Segment Anything Model (SAM), known for its high-quality masks and zero-shot segmentation capability. However , the vanilla mask generation method of SAM lacks class-specific information in the masks, resulting in inferior counting accuracy. To overcome this limitation, we introduce a prior-guided mask generation method that incorporates three types of priors into the segmentation process, enhancing efficiency and accuracy. Additionally, we tackle the issue of counting objects specified through free-form text by proposing a two-stage approach that combines reference object selection and prior-guided mask generation. Extensive experiments on standard datasets demonstrate the competitive performance of our training-free counter compared to learning-based approaches. This paper presents a promising solution for counting objects in various scenarios without the need for extensive data collection and model training. Code is available at

https://github.com/shizenglin/training-free-object-counter.

Keywords: NONE

题目:带有提示的无训练目标计数

摘要:本文解决了图像中物体计数的问题。现有的方法依赖于为每个对象添加点注释的大量训练数据,这使得数据收集耗费大量人力和时间。为了克服这一点,我们提出了一种无训练的对象计数器,将计数任务视为分割问题。我们的方法利用了Segment Anything Model(SAM),SAM以其高质量的掩膜和零样本分割功能而闻名。然而,SAM的vanilla mask(意为比较原始的网络)生成方法在掩膜中缺乏类特定信息,导致计数精度较差。为了克服这一限制,我们引入了一种先验引导掩膜生成方法,该方法将三种类型的先验结合到分割过程中,提高了效率和准确性。此外,我们通过提出一种两阶段方法来解决通过自由格式文本指定的对象计数问题,该方法结合了参考对象选择和先前引导的掩膜生成。在标准数据集上进行的大量实验表明,与基于学习的方法相比,我们的无训练计数器具有竞争力。本文提出了一种很有前途的解决方案,用于在各种场景中对对象进行计数,而无需大量的数据收集和模型训练。代码开源:

GitHub - shizenglin/training-free-object-counter.

关键词:无

1.引言

物体计数是指估计图像中存在的特定物体的数量。传统上,已经开发了特定类别的对象计数方法来计数属于预定义类别的对象,例如人类、动物或汽车。一些方法在对其训练类别中的对象进行计数时表现出优异的性能。然而,在测试过程中,他们在计算超出预定义类别的对象时面临限制。另一方面,类不可知的对象计数方法,提供了一个更灵活的解决方案,允许在几个支持示例的帮助下对任意类别的对象进行计数。本文旨在提供一种无训练的类不可知计数方法,从而增强对象计数在各种场景中的通用性和适用性。

在类不可知计数中,主要方法包括通过相似度图生成密度图,该相似度图比较样本和查询图像之间的视觉特征。相似性映射的优点是它独立于特定的对象类,允许在计数过程中进行动态调整。研究工作的重点是提高相似性地图的质量,以提高计数的准确性。一旦获得了高质量的相似性图,目标是学习将其映射到相应密度图的模型。计数是通过对密度值求和得出的。然而,这些方法通常需要为每个对象提供大量带有点注释的训练数据,这使得数据收集耗费大量人力和时间。因此,跨多个视觉类别缩放基于密度的计数方法变得具有挑战性。

为了解决前面提到的挑战,本文旨在开发一种无训练目标计数器,该计数器能够通过点、框或文本等输入提示来计数指定对象,如图1所示。为了实现这一点,计数任务被公式化为分割问题。具体地,使用分割模型来识别和分离由输入提示指定的单个对象,从而产生对应于不同目标对象的一组二进制分割图。然后通过对这些映射的数量进行计数来获得估计的对象计数。对于分段模型,考虑分段任意模型(SAM)是因为它能够生成高质量的掩码,并使用点或框等输入提示在不同场景中执行零样本分段。然而,SAM的vanilla mask生成方法本身并不能产生令人满意的结果,因为它在掩膜中缺乏类特定信息。为了缓解这个问题,引入了一种先验引导掩膜生成方法,将三种类型的先验结合到SAM的分割过程中。这些先验作为改进掩膜生成过程和提高计数精度的额外指南。此外,我们还解决了对通过自由格式文本指定的对象进行计数的挑战。为了解决这一问题,我们提出了一种两阶段方法,该方法结合了参考对象选择和先验引导掩膜生成。这种方法能够准确地计算通过文本提示指定的对象。

总之,我们在本文中做出了三个贡献:(i)我们将类不可知计数任务作为一个基于提示的分割问题来处理。通过这样做,我们消除了广泛的数据收集和模型训练的必要性,从而使公众更容易获得计数。ii)我们提出了一种新的先验引导掩膜生成方法,该方法通过结合三种类型的先验来提高SAM中分割过程的效率和准确性。(iii)我们提出了一种新的两阶段方法来计算通过文本指定的对象,将参考对象选择与先验引导掩膜生成方法相结合。通过在标准数据集上进行广泛的实验,我们验证了与基于学习的方法相比,我们的无训练计数器的竞争性能。

2. 相关工作

2.1 基于学习的目标计数

类特定对象计数(Class-specific object counting)侧重于计算属于预定义类别的对象,如人类、动物或汽车。主要的方法是采用基于回归的方法来生成密度图。该方法最初由Lempitsky等人提出,一直是后续研究的基础。基于密度的计数需要对训练图像中的每个可计数对象进行点注释。这些点与高斯核进行卷积,以创建用于训练的密度图。然后训练模型来预测每个输入图像的密度图,并且通过对预测的密度图中的像素值求和来获得对象计数。虽然类特定计数器在训练的类别上表现良好,但在测试期间,它们在计算预定义类别之外的对象时缺乏灵活性。

类不可知对象计数(Class-agnostic object counting)旨在仅使用少数支持示例来计数任意类别的对象。类不可知对象计数旨在仅使用少数支持示例来计数任意类别的对象。虽然密度图预测仍然很普遍,但类不可知的方法学习从相似性图到密度图的映射。关键是相似性映射独立于特定的对象类,从而实现了对任意类计数的动态自适应。研究的重点是提高相似性图的质量,并解决测试时间适应和对人类注释样本的需求等问题。

基于密度的计数(Density-based counting)方法通常需要为每个对象提供大量带有点注释的训练数据,以建立可靠的模型。然而,在数千个训练图像中为数百万个对象获取这样的注释是费时费力的。然而,在数千个训练图像中为数百万个对象获取这样的注释是费时费力的。这对跨不同视觉类别缩放计数方法提出了挑战。为了应对这一挑战,本文提出了一种无训练的对象计数器。它可以使用点、框或文本等输入提示对指定对象进行计数,而无需进行训练。通过消除对大量训练数据和点级注释的需求,我们提出的方法为在不同场景中计数对象开辟了可能性,而无需数据收集和模型训练的负担。

2.2 基于提示的目标计数

像ChatGPT这样的大型语言模型的出现改变了自然语言处理领域,并扩展到了计算机视觉。这些“基础模型”在零样本和少快照场景中表现出令人印象深刻的通用性,超过了其特定的训练数据。在计算机视觉中,CLIP是一个著名的基础模型,它利用对比学习来训练文本和图像编码器,使其能够通过文本提示处理新颖的视觉概念和数据分布。CLIP演示了跨不同视觉领域的出色零样本传输功能。另一个基础模型,任何分割模型(segment anything model,SAM),是为图像分割而设计的。SAM利用点和框之类的提示生成高质量的对象掩膜,在各种分段基准上取得显著性能,并显示跨不同数据集的零样本传输能力。

这些基础模型彻底改变了计算机视觉领域,为强大的泛化和处理新任务和数据分布的能力提供了令人兴奋的可能性,而无需对这些特定实例进行明确的训练。在CLIP和SAM功能的基础上,我们在本工作中提出了一种无需训练的对象计数器,拓展了对象计数领域中零样本学习和泛化能力的边界。

3. 相关工作

本文考虑了类不可知计数的问题,其中对象的类别是由输入提示(如点、边界框或文本)指定的。为了解决这个问题,我们提出了一种新的方法,消除了训练的必要性。我们的方法利用分割基础模型作为基础,实现准确高效的计数。我们的方法的全面概述如图3所示。

3.1 通过分割计数

我们将计数任务表述为一个分割问题。具体来说,我们使用分割模型来识别输入提示指定的单个对象,并将其从图像中分离出来,从而生成一组对应于不同目标对象的二值分割图。估计的对象数计算为这些贴图的数量。

分割模型f在确定物体计数的准确性方面起着至关重要的作用。在本文中,我们利用SAM[Segment anything]作为分割的基础模型。SAM已被证明可以生成高质量的掩码,并使用点或框等输入提示在不同场景中执行零样本分割。SAM包括三个基本组件:图像编码器 、提示编码器和掩码解码器。在分割过程中,SAM首先利用 提取输入图像的特征,而 对提供的提示进行编码。编码后的图像和提示随后被输入 , 产生最终的掩码输出。

为了将SAM纳入我们的计数任务,我们首先介绍一种普通方法,如图3a所示。

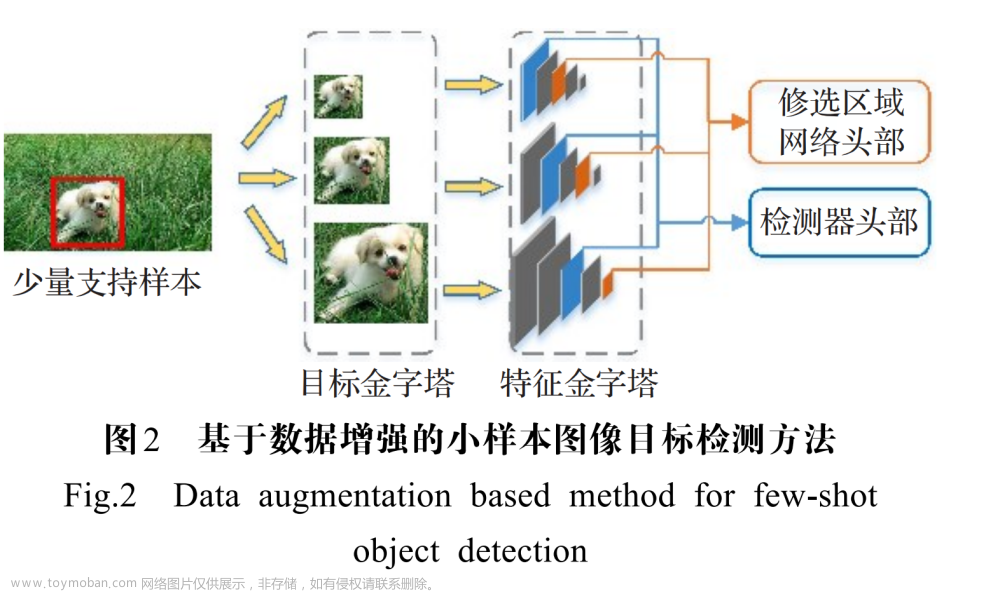

图3(a) Vanilla mask的初始步骤包括使用输入提示生成相似性图。这个相似性图生成过程如图2所示。接下来,我们继续为图像中存在的所有对象生成掩膜。为了实现这一点,我们使用点网格作为提示来分割整个场景。将这些点分为多个批次进行顺序处理。为了计算掩膜指示的每个对象的相似性得分,我们对掩码区域内的相似性值进行平均。如果掩膜的相应分数超过预定义的阈值,例如0.5,我们认为掩膜指示目标对象。最后,我们通过统计所有已识别的目标对象来确定总计数。

图2 使用点或框提示生成相似图。为了处理输入图像和提示,我们使用SAM,这使我们能够提取图像特征 并获得参考对象掩码。通过将图像特征与参考对象掩码相乘,我们获得参考对象特征 。使用余弦相似度来计算图像特征和参考特征 之间的相似度。⊙和•分别表示阿达玛乘积和欧几里得点乘积。

特别地,给定图像和输入提示 ,我们首先生成由输入提示指示的参考对象的二进制分段掩码,表示为。同时,我们可以获得图像特征,并通过参考掩模和图像特征之间的逐元相乘来计算参考对象的特征,表示为 ,其中⊙表示阿达玛乘积。利用余弦相似性度量来计算图像特征 和参考特征 之间的相似性映射Sim。随后,我们通过使用点网格(每侧32个点)作为提示来分割整个场景,从而为图像中存在的所有对象生成掩膜。得到 。通过对掩蔽的相似性值取平均值来计算由每个掩码指示的每个对象的相似性得分,表示为 。如果分数 超过预定义的阈值ε ,我们认为指示目标对象。最后,我们通过统计所有已识别的目标对象来确定总计数。尽管vanilla method在各种场景中都有令人印象深刻的性能,但我们发现了阻碍其整体效率和准确性的两个局限性。首先,涉及使用相似性图从图像中的所有对象中确定目标对象的后处理步骤没有期望的那么有效。这个过程需要分割所有对象,这在计算上可能是昂贵和耗时的。其次,确定合适的相似性得分阈值ε 是一个重大挑战。相似性图并非完美无瑕,这使得选择最佳阈值变得困难。高阈值可能导致错过目标对象,导致对对象计数的低估,而低阈值可能对非目标对象计数,导致对计数的高估。为了解决这些限制,我们提出了一种新的方法,称为先验引导的自动掩模生成。这种方法利用先验知识来提高物体计数的效率和准确性。

3.2 先验引导的掩膜生成

为了为图像中的所有目标对象生成遮罩,最好为每个目标对象提供特定提示。然而,在实践中,我们通常只有几个目标对象的提示。为了克服这一限制,我们使用覆盖整个图像的t×t 点的规则网格作为生成掩膜的提示。然而,这种方法可能会分割非目标对象,从而导致不准确的结果。为了应对这一挑战,我们在分割过程中加入了三种类型的先验。这些先验有助于区分网格内的正点和负点,确保只有所需的目标对象才能准确分割。我们的方法如图3b所示。

图3(b) 我们先进的先验引导方法通过结合三种类型的先验来增强SAM中的掩码生成过程。首先,我们使用输入提示生成相似性图,类似于香草方法。相似度图用于为点提示生成标签,区分正点和负点。其次,我们维护一个完整的分段图,该图包括截至当前批次的所有分段区域。在处理当前批次时,我们检查批次中的任何点是否已经存在于分段区域中。如果是,我们将从当前批次中删除这些点,以避免重复处理。第三,我们利用参考对象特征FR 作为语义先验,这有助于SAM更好地识别和分割图像中的目标对象。通过利用这些先验,我们的方法允许我们只关注目标对象,并在分割过程中有效地忽略不相关的实体。结果,估计的对象计数被计算为输出分段映射的数量。

作为语义先验,这有助于SAM更好地识别和分割图像中的目标对象。通过利用这些先验,我们的方法允许我们只关注目标对象,并在分割过程中有效地忽略不相关的实体。结果,估计的对象计数被计算为输出分段映射的数量。

相似性优先(Similarity prior)。为了合并相似性先验,我们使用余弦相似性来计算参考对象特征和图像特征之间的余弦相似性指标。从而产生相似性图,如图2所示。然后,我们应用Otsu二值化方法来创建二值相似性图,作为标签图。在标签映射中,网格中与值1相对应的点被视为正点,而其余的点则被视为负点。通过利用这个标签图,SAM可以有效地集中于分割正点周围的连续区域,而忽略负点。相似性先验的这种结合通过利用来自相似性图的信息来增强分割过程,从而导致图像内目标对象的更精确的识别和分离。

先验分割(Segment prior)。当同时处理网格中的所有点时,为了解决SAM的计算内存约束,将点分为多个批次进行顺序处理。通过这种方式,我们可以利用第一批生成的片段作为先验来指导后续批次的分割。由于来自网格的多个点可以用作对象的提示,这些点可能导致SAM的冗余处理,导致为同一对象生成多个掩膜。这种冗余既低效又不准确。为了解决这个问题,我们维护了一个完整的分段图,其中包含截至当前批次的所有分段区域。在处理当前批次时,如果批次中的任何点已经存在于分段区域中,我们将从当前批次中删除这些点。此外,如果更新的批次中没有正点,则SAM不会处理该批次。通过利用整个分割图,SAM可以基于已经分割的区域来细化和调整其分割预测。这种方法通过避免冗余计算和确保不同批次的一致性,提高了分割过程的效率和准确性。

语义先验(Semantic prior)。除了相似性先验和分段先验有助于选择积极和独特的点作为分割目标对象的提示之外,我们认识到,单独的点提示可能无法提供足够的信息来准确地分割这些对象。为了解决这一限制,我们建议将参考对象特征 合并为语义先验,使掩码解码器 能够更好地识别和分割图像中的目标对象。通过对参考对象特征进行积分,修改后的掩模生成处理变为,而不是 ,其中P表示点提示。值得注意的是,参考对象特征FR 是从训练有素的图像编码器fie 中提取的,并且不需要任何微调。通过结合参考对象特征 并如上所述修改掩模生成过程,掩模解码器现在可以更专注于参考对象特征。通过包含的附加上下文信息极大地帮助掩模解码器准确地区分和分割图像内的目标对象。

通过利用这些先验,我们可以只关注目标对象,而无需分割不相关的实体,与普通方法相比,提高了效率和准确性。

3.3 文本指定掩码生成

除了前面的方法外,我们还解决了计算通过自由格式文本指定的对象的挑战,其中感兴趣的对象是使用文本信息而不是显式点或边界框来描述的。为了解决这个问题,我们提出了一种两阶段的方法,该方法结合了参考对象选择和先验引导掩模生成。参考对象选择。在第一阶段,我们利用CLIP Surgery[7],即CLIP[13]的增强版,在像素级别计算图像和文本表示之间的相似性。CLIP Surgery的改进架构和特征提取使得能够更准确地计算图像-文本相似度。然而,从CLIP Surgery获得的初始相似性图可能不是高质量的,使得其不适合直接用于掩模生成。因此,我们利用初始相似性映射来选择参考对象。

参考对象选择(Reference object selection)。在第一阶段,我们利用CLIP Surgery[7],一种CLIP[13]的增强型,以在像素级别上计算图像和文本表示之间的相似性。CLIP Surgery的改进架构和特征提取使得能够更准确地计算图像-文本相似度。然而,从CLIP Surgery获得的初始相似性图可能不是高质量的,使得其不适合直接用于掩模生成。因此,我们利用初始相似性映射来选择参考对象。

为了便于准确识别目标对象,我们在初始相似性图上使用Otsu的二值化方法,生成二值相似性图。这个二进制映射作为选择最有可能包含目标对象的区域的指南。从二进制相似性图中,我们提取最大的连通分量,该分量表示包含目标对象的主要区域。为了确保精确定位,我们将最大连通分量的轮廓进一步划分为多个子轮廓。对于每个子轮廓,我们创建一个相应的边界框。这种策略有助于我们避免在边界框中包含不相关的对象,并只关注目标对象。为了处理生成的边界框之间的潜在重叠,我们应用了非最大抑制(NMS)。NMS使我们能够选择最合适且不重叠的边界框,确保我们只保留目标对象的最准确表示。

先前引导的掩模生成。在我们方法的第二阶段,我们使用从第一阶段获得的边界框作为SAM的提示。SAM生成对应于在前一阶段中识别的参考对象的掩模。一旦我们获得了参考对象的掩码,我们就可以使用余弦相似性度量来计算参考特征和图像特征之间的相似性图,如图4所示。该相似性图捕捉参考对象和图像区域之间的相似性。为了为所有目标对象生成准确的掩码,我们采用了我们的先验引导掩码生成方法,如第3.2节所述,该方法利用了相似度图中的信息。

图4。Similarity map generation with a text prompt。我们的方法首先使用CLIP Surgery计算粗略的相似性图。基于粗糙相似度图,我们执行一系列步骤来选择参考对象。首先,我们应用二值化技术将相似度图转换为二值表示。接下来,我们识别二进制映射中最大的连接组件,因为该区域更有可能包含文本指定的目标对象。为了进一步细化参考对象,我们在已识别的连接区域的子区域周围创建边界框。最后,我们利用生成的边界框作为SAM的提示。SAM处理这些提示并计算高质量的相似性图,如图2所示。

4. 实验

4.1 实验设置

数据集。我们在两个常用的计数数据集上评估了我们的方法,即FSC147[15]和CARPK[4]。FSC147数据集包括来自147个不同对象类别的6135幅图像。我们使用测试集进行评估,该测试集包括来自29个对象类别的1190张图像,因为我们的方法不需要训练。在CARPK数据集中,有1448张图像,其中约有90000辆汽车是从无人机视图中捕捉到的。测试集由459张图像组成。

评估指标。我们验证了n 幅测试图像的计数估计值 y 及其人工标注 y 的平均绝对误差 (MAE),均方根误差(RMSE)、归一化相对误差(NAE)和平方相对误差(SRE)指标。特别地,, , , 。

实施细节(Implementation details)。对于我们的实验,我们使用SAM中的“vit_b”图像编码器。为了合并框提示,我们使用数据集提供的带注释的参考对象框,并提取它们的中心点作为点提示。对于文本提示,我们使用模板对于文本提示,我们使用模板“the photo of many”,后跟数据集中的对象类名。在我们的vanilla counting method(第3.1节)中,将相似性得分阈值设置为0.5会产生最佳性能。将相似性得分阈值ε设置为0.5产生最佳性能。对于我们之前的引导掩模生成方法(第3.2节),我们使用t×t 点的规则网格作为SAM的提示。原始SAM论文中t 的默认值为32,但我们观察到,在计算小物体时,t 越大越有效。因此,我们建议将t 动态设置为 ,其中Osize 表示参考对象的最小尺寸,|| 表示精确划分。

4.2 点框提示计数

基准方法(Baseline methods)。在这个实验中,我们使用点和框提示来评估我们的计数方法。为了评估其有效性,我们将其与其他四种基于学习的类无关计数方法进行了比较,这些方法采用了多种方法来学习高质量的相似性图。比较的方法包括GMN[9]、FamNet+[15]、CFOCNet+[24]和BMNet+[17]。需要注意的是,这些基于学习的方法专门设计为只接受方框作为提示。除了上述比较之外,我们还报告了通过SAM自动生成地图获得的计数结果,表示为SAM。这使我们能够评估SAM在计数对象时的默认行为的性能,而无需任何进一步处理。

结果(Results),如表1所示,由于SAM生成的掩码中缺乏类信息,使用SAM的直接计数产生的性能最差。这导致在计数过程中包含大量非目标对象。然而,通过利用相似图来选择目标对象,我们的香草方法显著提高了性能。

表1。我们的点框提示方法对FSC-147的效果。与基于学习的方法相比,我们的方法表现出了竞争力。粗体突出显示无训练方法中的最佳计数结果,而下划线表示基于学习的方法中的最优计数结果。以下各表均采用这一惯例。

例如,在带有方框提示的 FSC-147 数据集上,MAE 从 42.48 降至 26.29。此外,我们的方法还加入了三个先验,以加强分割过程中目标和非目标对象的区分,从而进一步将 MAE 从 26.29 降至 19.95。与四种基于学习的方法相比,我们的方法优于其中三种方法。尽管使用了数千个训练数据和复杂的模型设计和训练程序,但最好的基于学习的方法BMNet+[17]在FSC-147数据集上仅实现了5.33的MAE减少和0.04的NAE减少,在CARPK数据集上实现了5.21的MAE减少。当使用点提示时,我们的方法仍然保留了它们的优势。这些结果证明了我们的无训练方法的前景。

图5a通过成功和失败的结果展示了我们方法的有效性。我们的方法始终实现精确计数,即使在具有稀疏小对象或密集大对象(第一行)的具有挑战性的场景中也是如此。然而,在个别对象太小而无法区分或对象与背景混合(最后一行)的极端场景中,我们的方法遇到了困难。这些场景在计算任务方面带来了持续的挑战。

图5。通过框提示(第1行和第2行)和文本提示(第3行和第4行)得出成功和失败的结果。当物体单独可见时,我们的方法可以准确地计算它们。在个别对象难以区分或对象与背景混合的极端场景中,需要进一步改进。

4.3 文本提示计数

基准方法(Baseline methods)。在这个实验中,我们使用文本提示来评估我们的计数方法。为了评估其有效性,我们将其与Xu等人[Zero-shot object counting]提出的基于学习的方法进行了比较,后者也利用文本来指定目标对象。我们再次报告单独从SAM获得的计数结果以进行比较。

结果(Results),结果如表2所示。与单独使用SAM的直接计数相比,我们的香草方法通过利用Clip Surgery获得的相似性图来选择目标对象,显著提高了性能。例如,在FSC-147数据集上,MAE从42.48下降到32.86。为了进一步提高通过Clip Surgery获得的相似性图的质量,我们介绍了我们的参考对象选择算法。将其与我们之前的引导掩模生成方法相结合,可以产生出色的计数结果,将MAE从32.86降低到24.79。值得注意的是,Xu等人[Zero-shot object counting]提出的基于学习的方法仅略微优于我们的方法,在MAE中相差2.7,在NAE中相差0.03。

图5b通过成功和失败的结果说明了我们的方法的有效性。我们的方法阐释了目标对象的精确计数,即使在存在复杂背景的情况下也是如此(第一行)。然而,通过分割每个相似的分量,它可能会遇到重复计数。例如,在第二行中,我们的方法可能会将一副太阳镜的每个镜片视为一个单独的物体,而不是将其视为整个物体。此外,计算密度极高的物体对我们的方法提出了挑战。

4.4 消融研究和分析

先验引导的掩模生成(Prior-guided mask generation)。我们的增强掩模生成方法在先验信息的指导下,将三种类型的先验集成到SAM的分割过程中,从而提高了计数性能。本研究旨在评估每个先验的重要性。表3显示了我们在FSC-147数据集上的实验结果。很明显,与仅依靠SAM进行直接计数相比,每个先验在提高计数性能方面发挥着至关重要的作用。此外,将三个先验中的任意两个进行组合会导致进一步的增强。当所有三个先验相结合时,可以获得最有利的计数结果。

参考对象选择(Reference object selection),我们的目的是评估我们的参考对象选择算法在增强文本指定计数方面的重要性。我们将我们的算法与基线方法进行了比较,该方法没有利用该算法来提高通过Clip Surgery获得的相似性图的质量。基本上,基线方法直接使用从Clip Surgery获得的相似性图来进行先前引导的掩模生成。如表4所示,结果清楚地表明了我们的方法所实现的计数性能的改进。

速度分析(Speed analysis)。最后,我们分析了我们的方法的速度。所有测试都是在配备Nvidia RTX A5000 GPU的机器上进行的。在GPU模式下,我们的方法实现了每张图像2.1秒的处理时间。这个速度超过了我们vanilla method的4.7秒和SAM的3.4秒。文章来源:https://www.toymoban.com/news/detail-607797.html

5. 结论

本文通过引入一种利用分割基础模型SAM的无训练计数器来解决图像中的对象计数问题。我们提出了一种新的先验引导掩模生成方法,通过结合三种类型的先验(包括相似性先验、分段先验和语义先验)来增强SAM中的分割过程。通过广泛的消融研究,我们证明了每种先验及其组合对提高计数效率和准确性的显著影响。此外,我们通过提出一种两阶段方法来解决通过自由格式文本指定的对象计数问题。这种方法结合了参考对象选择和先前引导的掩模生成。我们已经证明,参考对象选择在细化相似性图、实现基于文本描述的精确对象计数方面起着至关重要的作用。在标准数据集上进行的大量实验表明,与基于学习的方法相比,我们的无训练对象计数器具有竞争力。我们相信,我们的发现将激励进一步研究开发无训练物体计数器。文章来源地址https://www.toymoban.com/news/detail-607797.html

到了这里,关于论文阅读--带有提示的无训练目标计数的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[论文阅读]RTMDet——实时目标检测](https://imgs.yssmx.com/Uploads/2024/02/717505-1.png)