查询GPU时无进程运行,但是显存却被占用了

1、具体表现

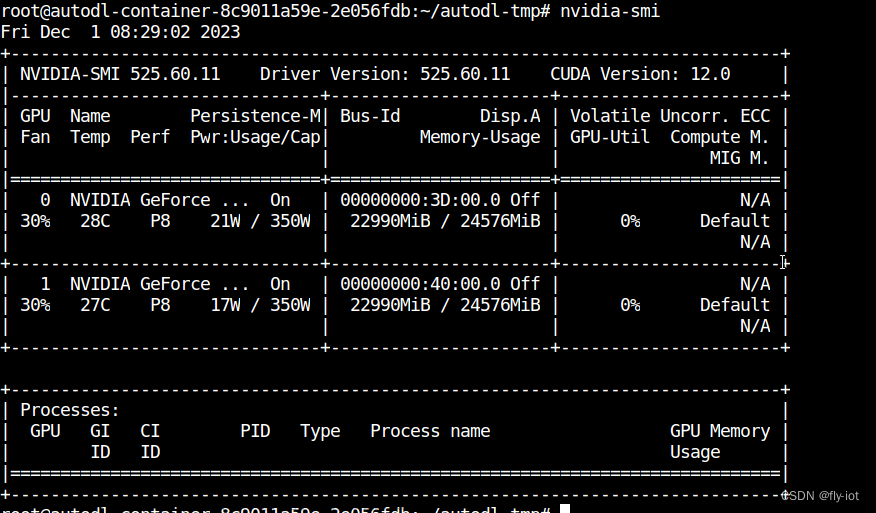

nvidia-smi或者gpustat无进程在GPU上运行,但GPU显存却被占用了

2、造成原因

应该是存在僵尸进程,已经运行完毕或者卡死,但是内存没有释放,处于挂起状态

3、解决方案

3.1 方案一

重启电脑

3.2 方案二

如果电脑不能重启,那就通过命令行:

fuser -v /dev/nvidia*

或者有管理员权限的时候

sudo fuser -v /dev/nvidia*

可以看到对应的设备,是有进程的。

最后就用kill命令行杀掉相应的PID号。

这样就完事了文章来源:https://www.toymoban.com/news/detail-607934.html

文章来源地址https://www.toymoban.com/news/detail-607934.html

文章来源地址https://www.toymoban.com/news/detail-607934.html

到了这里,关于查询GPU时无进程运行,但是显存却被占用了的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[NLP]LLM 训练时GPU显存耗用量估计](https://imgs.yssmx.com/Uploads/2024/02/651417-1.png)