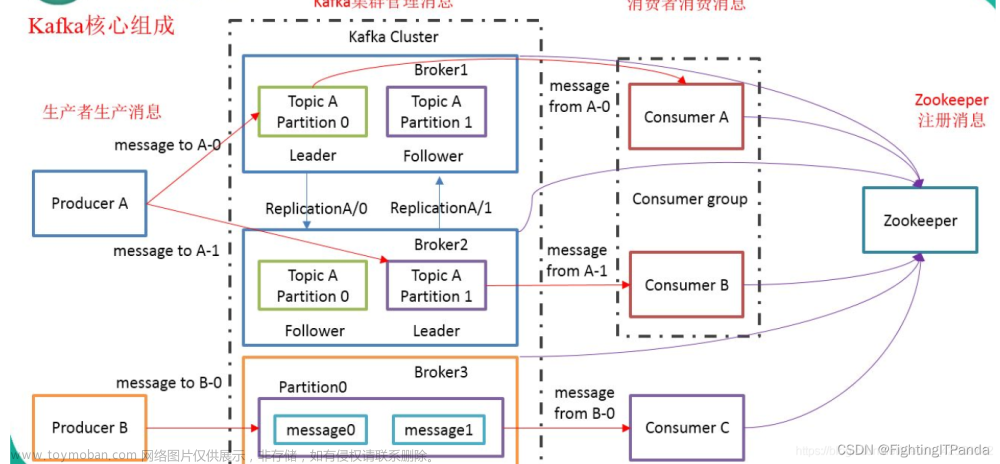

Broker

Kakfa 为什么牛? 为什么这么火?有什么优势呢?

工欲善其事,必先利其器 - 核心概念(术语解释)

Kafka是怎么保证消息可靠性的呢

面试必问,什么是 HW 和 LEO?何时更新HW和LEO呢?

举个栗子一步一步说HW、LEO如何写入

生产者

生产者参数详解 ,什么是生产者确认机制? 什么是ISR? 什么是 OSR?

生产者发送消息流程解析

消费者

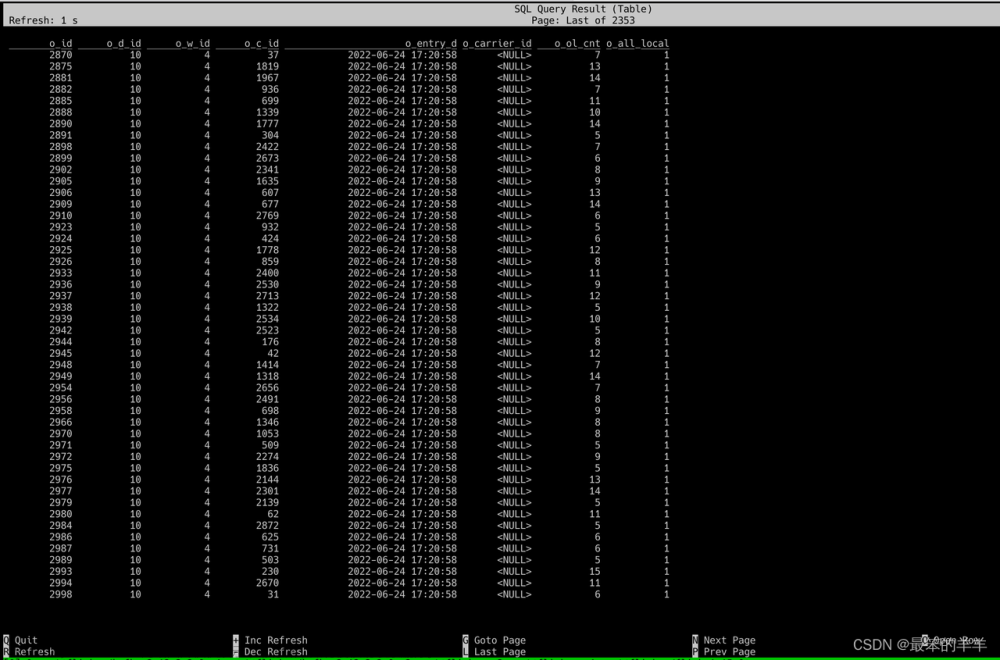

Kafka怎么做到保障消息不会重复消费的? 消费者组是什么?

Kafka 遭大家诟病了?因为啥?啥是再平衡?

Kafka持久化刷盘为啥吞吐量还那么牛?磁盘存储 -零拷贝

文章来源地址https://www.toymoban.com/news/detail-609327.html

文章来源:https://www.toymoban.com/news/detail-609327.html

到了这里,关于Kafka 入门到起飞系列的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!