一、深度学习概念

1、定义

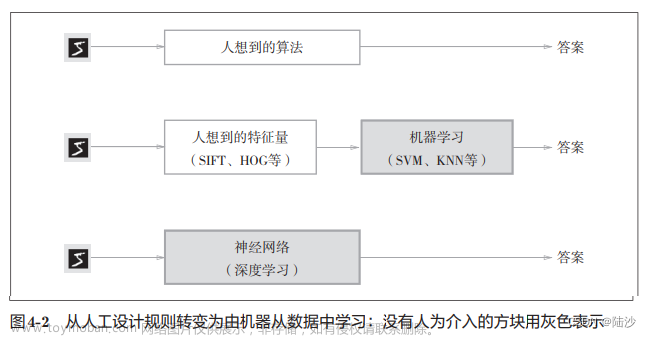

通过训练多层网络结构对位置数据进行分类或回归,深度学习解决特征工程问题。

2、深度学习应用

- 图像处理

- 语言识别

- 自然语言处理

在移动端不太好,计算量太大了,速度可能会慢

eg.医学应用、自动上色

3、例子

使用k最近邻进行判断时,背景主导是最大的问题,因为我们关注的是主体(主要成分)

二、神经网络基础

1、线性函数

例如输入一个小猫图片,通过

f

(

x

,

W

)

f(x,W)

f(x,W)得到每个类别的得分:

f

(

x

,

W

)

f(x,W)

f(x,W)中每个像素点的权重参数不同:

10

10

10:10种分类

b

b

b:偏置项(微调操作)

w

w

w:权重参数

2、损失函数

正则化惩罚项:减轻某个及其突出特征的重要性

损失函数=数据损失+正则化惩罚项

3、Softmax分类器

我们关注属于正确类别概率值,越接近于1,损失越小,因此用对数函数求损失值。

e

x

ex

exp:

e

x

e^{x}

ex次方,用于放大映射

n

o

r

m

a

l

i

z

e

normalize

normalize:归一化

L

i

L_i

Li:实际损失值文章来源:https://www.toymoban.com/news/detail-612131.html

文章来源地址https://www.toymoban.com/news/detail-612131.html

文章来源地址https://www.toymoban.com/news/detail-612131.html

到了这里,关于深度学习入门(一):神经网络基础的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!