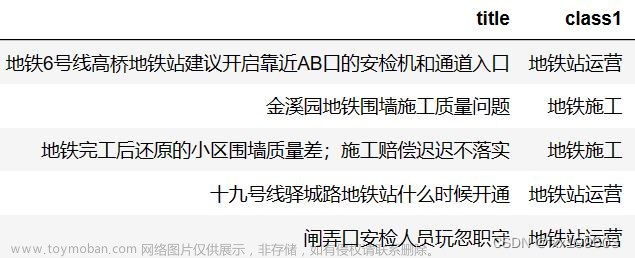

大家好,我是微学AI,今天给大家介绍一下自然语言处理实战项目14-基于文本向量和欧氏距离相似度的文本匹配,用于找到与查询语句最相似的文本。NLP中的文本匹配是指通过计算文本之间的相似度来找到与查询语句最相似的文本。其中一种常用的方法是基于文本向量和欧氏距离相似度。将待匹配的文本和查询语句都转换为向量表示。可以使用词袋模型、tf-idf等方法将文本转换为向量。词袋模型将文本表示为每个词汇在文本中的出现次数,tf-idf则考虑了词汇在整个语料库中的重要性。 计算文本向量之间的欧氏距离。欧氏距离是一种常用的衡量向量相似度的方法,它表示两个向量之间的几何距离。 选择与查询语句具有最小欧氏距离的文本作为匹配结果。距离越小,表示两个文本越相似。

项目背景

基于文本向量和欧氏距离相似度进行文本匹配。通过将文本表示为向量,可以计算两个文本之间的欧氏距离相似度来衡量它们的语义相似程度。这种相似度匹配方法可以应用于各种文本相关的任务,如信息检索、句子匹配、推荐系统等。

该项目解决了文本匹配中的一个痛点,即如何找到与查询语句最相似的文本。在大规模的文本数据中,快速准确地找到与用户输入查询语句相关的文本对于提供高效的信息检索和推荐非常重要。传统的基于关键词匹配的方法往往无法处理语义相似度,而基于文本向量和欧氏距离相似度的方法可以更好地捕捉文本之间的语义关系,提高匹配的准确性。

通过该项目,可以实现快速地搜索和匹配与查询语句最相关的文本,从而提供更准确的搜索结果和个性化推荐,大大提高用户体验。同时,该方法还可以应用于其他领域,如自然语言处理、文本挖掘等,有着广泛的应用前景。

数学原理

基于文本向量和欧式距离相似度的文本相似度匹配是通过计算文本之间的向量表示之间的欧式距离来确定它们的相似程度。下面是相关的数学原理:文章来源:https://www.toymoban.com/news/detail-613687.html

-

文本向量表示&文章来源地址https://www.toymoban.com/news/detail-613687.html

到了这里,关于自然语言处理14-基于文本向量和欧氏距离相似度的文本匹配,用于找到与查询语句最相似的文本的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!