RWKV(读作RwaKuv)借鉴了RNN的移动平均模型(MA),将transformer的 O ( T 2 d ) O(T^2d) O(T2d)复杂度降低到 O ( T d ) O(Td) O(Td),同时保持较好的结果表现。RWKV也是一个开源模型,甚至其介绍主页的html代码都有开源。以下为发现的与RWKV相关的开源项目,其中包括模型结构,任务扩展,微调训练,模型加速,服务化等几个部分。

模型结构

- https://www.bilibili.com/video/BV1b8411Z7Df/?

- http://export.arxiv.org/pdf/2305.13048

- https://github.com/RWKV/RWKV-wiki

- Trying to make the code in RWKV more easily understoodhttps://github.com/cooljoseph1/rwkv-simple

- https://www.zhihu.com/question/602564718

-

【群主】Bo 2023/3/1 16:52:48 RWKV pip package https://pypi.org/project/rwkv/ 做了 pip 包,大家可以直接 inference 了

-

用150行python独立实现RWKV算法和文字生成,以及RWKV pip package https://zhuanlan.zhihu.com/p/610489720

数据集

-

https://huggingface.co/datasets/codeparrot/github-code

-

https://huggingface.co/datasets/allenai/c4

-

https://registry.opendata.aws/

-

https://www.luge.ai/#/

-

https://pile.eleuther.ai/

任务扩展

- This is a project to train classification model using RWKV model from Huggingface transformers library https://github.com/yynil/RWKV-Classification

- 使用 RWKV 预测股票调整后的收盘价https://github.com/tomer9080/Stock-Prediction-Using-RWKV

- 植物花卉数据集[PlantFlower Datasets]基于RWKV大模型RWKV World模型数据集https://github.com/lovebull/PlantFlowerDatasets

- 最佳开源AI作曲模型,基于RWKV,全部开源免费

微调训练包

-

基于GO语言的深度学习框架的rwkv

https://github.com/harrisonvanderbyl/godot-rwkv: The Godot Engine is a free, all-in-one, cross-platform game engine that makes it easy for you to create 2D and 3D games. -

将RWKV World/World-CHN系列模型由原生pth转为HF格式,并进行基于peft库的Lora增量微调+Alpaca全量微调https://github.com/StarRing2022/HF-For-RWKVWorld-LoraAlpaca

cpu 加速,手机加速,amd intel 卡加速,重写 cuda 加速

- The CUDA version of the RWKV language model ( https://github.com/BlinkDL/RWKV-LM ) https://github.com/BlinkDL/RWKV-CUDA

- https://github.com/npk48/rwkv_cuda

- A torchless, c++ rwkv implementation using 8bit quantization, written in cuda/hip/vulkan for maximum compatibility and minimum dependencieshttps://github.com/harrisonvanderbyl/rwkv-cpp-accelerated

- LLaMa/RWKV onnx models, quantization and testcase

- https://github.com/harrisonvanderbyl/rwkv-cpp

- INT4/INT5/INT8 and FP16 inference on CPU for RWKV language model

- https://github.com/ZTMIDGO/RWKV-Android:使用Android cpu 运行 RWKV V4 ONNX

- Run ONNX RWKV-v4 models with GPU acceleration using DirectML [Windows], or just on CPU [Windows AND Linux]; Limited to 430M model at this time because of .onnx 2GB file size limitation

- https://github.com/tensorpro/tpu_rwkv

- https://github.com/ZeldaHuang/rwkv-cpp-server

服务化

- 使用Gradio制作的基于RWKV的角色扮演的webui

- https://github.com/cgisky1980/ai00_rwkv_server

- https://github.com/cgisky1980/ai00_rwkv_server

CG

-

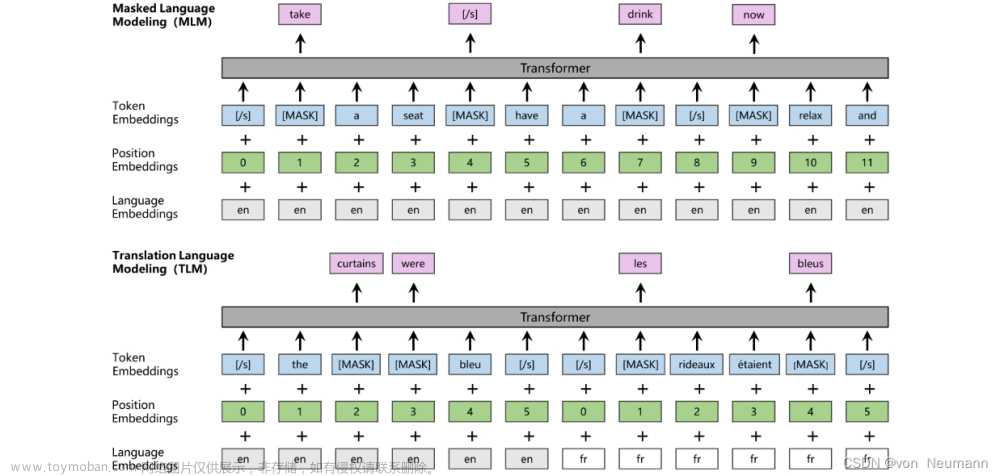

Large-scale Self-supervised Pre-training Across Tasks, Languages, and Modalities

-

https://github.com/amazon-science/mm-cot 试试亚马逊的mm-cot

-

Meta 的大语言模型 LLaMA 最近引起了广泛关注,它的一大优势是参数规模更小但性能强于 OpenAI 的 GPT-3 模型,而且能运行在单张显卡上,让普通消费者的硬件也有可能提供类似 ChatGPT 性能的 AI 聊天机器人。LLaMA 是一组大语言模型的集合,其参数规模从 70 亿到 650 亿,它最新的 LLaMA-13B 模型有 130 亿个参数,不到 GPT-3 模型 1750 亿个参数的十分之一。现在 Nebuly AI 推出了首个基于人类反馈强化学习的 LLaMA AI 聊天机器人开源实现 ChatLLaMA。https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

-

https://view.inews.qq.com/k/20230117A03EVJ00

-

https://arxiv.org/abs/2302.14045

-

链接:https://pan.baidu.com/s/1Jkc60TPzc4ArMN530NlZWg?pwd=c8lj

提取码:c8lj

–来自百度网盘超级会员V2的分享 -

https://www.bilibili.com/video/BV1m8411P7v7/

-

GPT-3 + RL 全流程训练开源整理:https://zhuanlan.zhihu.com/p/608705255?utm_id=0

https://zhuanlan.zhihu.com/p/609003237?utm_id=0 -

Accelerating PyTorch with Intel® Extension for PyTorch*

-

https://github.com/karpathy/llama2.c文章来源:https://www.toymoban.com/news/detail-613943.html

-

https://github.com/facebookresearch/llama文章来源地址https://www.toymoban.com/news/detail-613943.html

到了这里,关于100% RNN language model ChatRWKV 相关开源项目的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!