摘要:本文整理自阿里巴巴开发工程师,Apache Flink Committer 任庆盛,在 9 月 24 日 Apache Flink Meetup 的分享。主要内容包括:

- Flink CDC 技术对比与分析

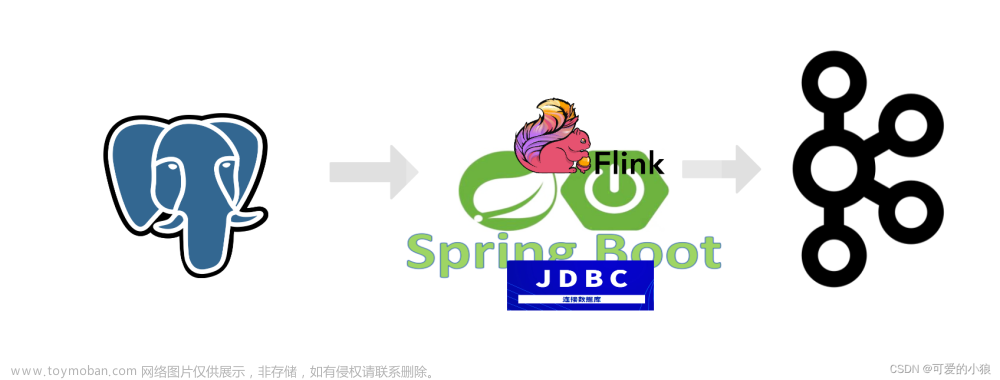

- Flink + Kafka 实时数据集成方案

- Demo:Flink+Kafka 实现 CDC 数据的实时集成和实时分析

一、Flink CDC 技术对比与分析

1.1. 变更数据捕获(CDC)技术

广义概念上,能够捕获数据变更的技术统称为 CDC(Change Data Capture)。通常我们说的 CDC 主要面向数据库的变更,是一种用于捕获数据库中数据变化的技术。

CDC 的主要应用有三个方面:

- 数据同步,通过 CDC 将数据同步到其他存储位置来进行异地灾备或备份。

- 数据分发,通过 CDC 将数据从一个数据源抽取出来后分发给下游各个业务方做数据处理和变换。

- 数据采集,使用 CDC 将源端数据库中的数据读取出来后,经过 ETL 写入数据仓库或数据湖。

按照实现机制,CDC 可以分为两种类型:基于查询和基于日志的 CDC。基于查询的 CDC 通过定时调度离线任务的方式实现,一般为批处理模式,无法保证数据的实时性,数据一致性也会受到影响。基于日志的 CDC 通过实时消费数据库里的日志变化实现,如通过连接器直接读取 MySQL 的 binlog 捕获变更。这种流处理模式可以做到低延迟,因此更好地保障了数据的实时性和一致性。

1.2. Flink CDC 的技术优势

文章来源:https://www.toymoban.com/news/detail-618411.html

文章来源:https://www.toymoban.com/news/detail-618411.html

在上图中,我们比较了几种常见的 CDC 方案。相比于其他方案,Flink CDC 在功能上集成了许多优势:文章来源地址https://www.toymoban.com/news/detail-618411.html

- 在实现

到了这里,关于Flink CDC+Kafka 加速业务实时化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!