最近尝试了使用BERT将告警信息当成一个文本去做分类,从分类的准召率上来看,还是取得了不错的效果(非结构化数据+强标签训练,BERT确实是一把大杀器)。但准召率并不是唯一追求的目标,在安全场景下,不仅仅需要模型告诉我们分类结果,还必须把这么分类的原因给输出出来,否则仍然无法给运营工作进行提效。

因此,对BERT分类的可解释性上,进行了一番研究探索。但是结果并不理想。。。

1、BERT是如何完成分类任务的

首先,我们需要对BERT的分类逻辑,做进一步深挖。

BERT的整体架构如上:底层将文本转化为token并进行编码,中间层通过Attention机制进行信息的提炼,上层做最终输出。(其实和CNN的结构非常类似,不同的是使用Attention替换掉了卷积层,增加了序列信息的处理能力。)

在最终输出环节,首位的[CLS]实际上包含了整段文本的信息编码。因此,当需要用BERT完成一个分类任务时,只需要给予[CLS]的输出,拼接一个全连接层,就可以完成最终的分类。

那么[CLS]是如何获得整段文本的信息编码的呢?这里会涉及到Attention的实现细节,偏复杂,但我们可以仅从信息传递的角度来理解。Attention从设计思路上,是在计算其他token和当前token的相关性,强相关的token会获得更高的Attention权重。但[CLS]更加特殊,它的Attention计算方式通常是将所有token的向量表示进行加权平均,其中权重由Attention决定。这种方式可以看作是对整个输入序列的向量表示进行汇总,得到一个表示整个序列语义信息的向量。

总结来说就是,经过一层BERT网络之后,token携带的是当前位置和其他位置的关联信息,而[CLS]则是将所有token的信息进行汇总。经过多层的迭代,不断加工信息,得到最终的结果。

2、过程中可提取的信息

在了解了BERT分类的原理之后,我们来尝试挖掘一下其中的可解释性。最直观的,可以通过Attention的权重,来大致掌握BERT的信息传递过程。使用bertviz可以实现这个过程:

结合这张图,也可以再理解一下BERT的工作和信息传递机制。

其中每一个单元是一个Attention单元计算过程,称之为head。连线的粗细代表了token之间信息传递权重(也可以理解成相关性)。其中,首个Token即是[CLS]。上面这个图,可以看到几个明显的特征:

- 0-3层中,有比较多的左侧所有token至首位[CLS]的连线,代表着[CLS]在通过多个维度和层级提取全量信息。

- 4-7层中,[CLS]的信息提取开始出现针对性,不再是全局等权重提取。

- 5-6层中,出现了多个token往某一位特定token汇集的现象,而那个token是当前文本分类的关键因素。

- 0-4层中,有比较多的平行线,代表着在提取序列信息,即token之间的前后相关性。

- 7-8层往后,连线已经比较均匀,代表前面的层级已经完成了信息处理,后置的部分不再需要额外计算。

通过分析BERT的信息传递过程,虽然能够大致理解分类的逻辑,但因为经过了多层多头的信息加工,实际逻辑很复杂,无法直接提取出了权重较大的因素。

尝试考虑了一下通过最后的分类层(即[CLS]之后的全连接层)来分析权重,但最后一层的[CLS]也是个多轮加工后的信息,并不直接对应某个token的贡献,看起来也不可行。

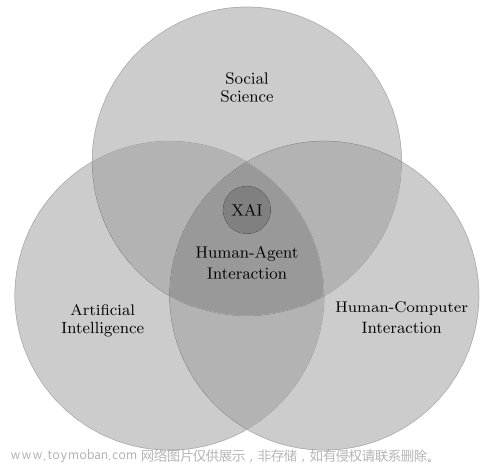

3、黑盒可解释性工具

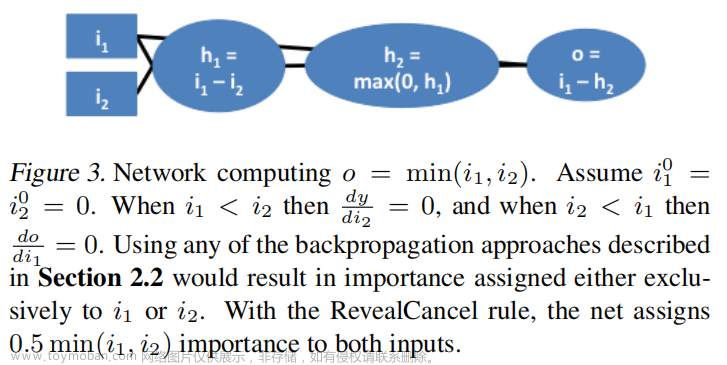

通过对BERT工作原理的剖析,可以看到对一个深度非线形模型去做解释,基本上是不可行的。因此,行业内也尝试了用黑盒的办法去探究算法的分类原理。其中,比较知名的就是Lime和SHAP

Lime

Lime的思想是:深度模型在某个局部仍然是线形的。因此,可以通过在目标样本周围生成相似样本,然后用线形模型去拟合深度模型的效果,从而得到近似的分类逻辑。而线形模型就很好得出特征贡献的权重了。

具体细节网上比较多,就不过多赘述了。Github:GitHub - marcotcr/lime: Lime: Explaining the predictions of any machine learning classifier

做了一次简单尝试,结果并不如预期。

Shap

SHAP的思想是:控制变量法,如果某个特征出现或不出现,可以改变分类结果,那么这个特征一定是比较重要的。因此,可以通过尝试该特征出现或不出现的各种情况,来计算对分类结果的贡献。

官方文档:shap.Explainer — SHAP latest documentation

做了一次简单尝试,结果并不如预期。

ChatGPT

不论是Lime和SHAP,都会涉及到一个复杂的遍历运算过程,得到可解释结果需要花费较长的计算时间。不符合当前场景的原始目标,因此,没有做进一步调教工作。(理论上来说,优化内部特征选取的逻辑,应该能够比较好的贴合人类直觉。)

这个时候,想到了使用ChatGPT来进行解释。尝试构造了如下Prompt

角色:你是一个分析安全告警的专家,下面会给你一段告警,请做出精简的解读。

限制:请严格依照以下指令回答问题:

1.如果问题说明了该告警是误报还是非误报,请按照问题说明的研判结果进行分析。

2.问题中会包含多个关键字段,请挑选去其中最异常的部分,不要超过5个。

3.请对关键词进行必要的解读,不要直接复述出来。已知如下告警是误报,请分析原因,并对其中的关键特征进行解读。

调教一番之后,效果并不理想。思考了一下原因,个人认为是BERT的分类和ChatGPT的分析并不一致。BERT分类依据主要来源于微调的过程,即仍然是基于历史数据进行的分析;而ChatGPT是基于公开样本进行的学习,得不到内部历史信息的支撑。

给到ChatGPT一些内部数据做微调,也许能够获得更好的效果。

结论

总体来说,对深度模型做解释仍然是一个很困难的工作,更别提需要在线上实时得出相应的分析结论了。

传统可解释性方法的场景偏向于零星的分析场景,主要用于帮助算法人员去理解和优化模型,和线上的使用场景存在一定的偏差。文章来源:https://www.toymoban.com/news/detail-618881.html

从目前的试验来看,应当是需要两个模型分别来完成分类和可解释性任务,但必须共享同一份数据和知识。因此,喂给ChatGPT一些数据做微调(但是缺乏标签,需要走无监督的逻辑),大概是可探索的方向。文章来源地址https://www.toymoban.com/news/detail-618881.html

到了这里,关于使用BERT分类的可解释性探索的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!