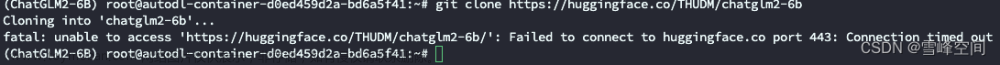

下载chatglm2-6b模型文件

https://huggingface.co/THUDM/chatglm2-6b

*** 国内推荐,国内推荐,国内推荐-1 ***

https://aifasthub.com/models/THUDM

*** 国内推荐-2 ***

https://hf-mirror.com/THUDM/chatglm2-6b

下载chatglm3-6b模型文件

https://huggingface.co/THUDM/chatglm3-6b

*** 国内推荐 ***

https://hf-mirror.com/THUDM/chatglm3-6b

方法一:huggingface页面直接点击下载

一个一个下载,都要下载

方法二:snapshot_download下载文件

可以使用如下代码下载

创建下载环境

conda create --name hfhub python=3.10

conda activate hfhub

安装

pip install huggingface_hub -i https://pypi.tuna.tsinghua.edu.cn/simple

编写代码

down_glm2.py

```

from huggingface_hub import snapshot_download

import sys

repo_id = "THUDM/chatglm2-6b"

local_dir = "/opt/models/chatglm2-6b/"

local_dir_use_symlinks = False

revision = "main"

snapshot_download(repo_id=repo_id,

local_dir=local_dir,

local_dir_use_symlinks=local_dir_use_symlinks,

revision=revision)

```

snapshot_download其他参数

只允许下载部分类型的文件(以JSON为例)

allow_patterns=‘*.json’,

不允许下载部分类型的文件(以JSON为例)

ignore_patterns=[‘*.json’]文章来源:https://www.toymoban.com/news/detail-620728.html

执行下

python down_glm2.py

如果有超时可以多试几次,

或allow_patterns指定具体文件

例如:

snapshot_download(repo_id=repo_id,

local_dir=local_dir,

local_dir_use_symlinks=local_dir_use_symlinks,

allow_patterns='pytorch_model-00001-of-00007.bin',

revision=revision)

方法三:清华云盘

清华云盘

https://cloud.tsinghua.edu.cn/d/674208019e314311ab5c/

方法四:异型岛社区版

https://aliendao.cn/models/THUDM

上面搜索下看是否有需要的模型可以下,模型目前不是太全

系列文章

第一篇-ChatGLM-webui-Windows安装部署-CPU版

第二篇-二手工作站配置

第三篇-Tesla P40+CentOS-7+CUDA 11.7 部署实践

第四篇-Miniconda3-CentOS7-安装

第五篇-ChatGLM2-6B|ChatGLM3-6B模型下载

第六篇-ChatGLM2-6B-CentOS安装部署-GPU版文章来源地址https://www.toymoban.com/news/detail-620728.html

到了这里,关于第五篇-ChatGLM2-6B模型下载的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!