如何解决flink任务的数据倾斜问题

Flink 任务的数据倾斜问题可以通过以下几种方法来解决:

-

使用滑动窗口:滑动窗口可以将窗口划分成多个子窗口,从而使数据更加均衡地分配到不同的计算节点中。同时,滑动窗口还可以使窗口内的数据更加连续,从而减少数据倾斜的情况。

-

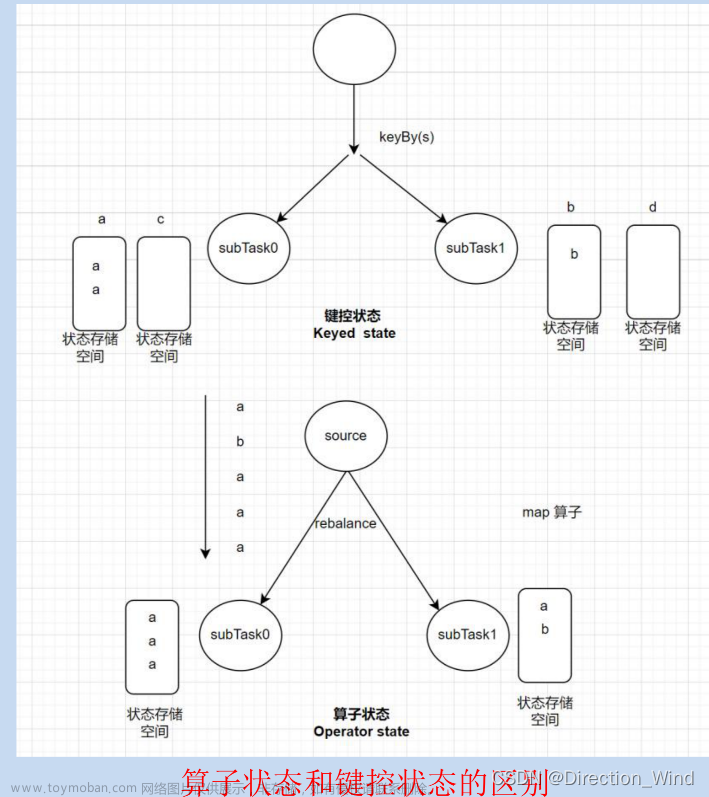

使用分区:如果数据倾斜的原因是某些 key 的数据量过大,可以考虑对数据进行分区,从而将数据分散到不同的计算节点中进行处理。具体地,可以使用 Flink 的 rebalance()、rescale()、shuffle()等算子对数据进行分区。

-

随机键:如果数据倾斜的原因是某些 key 的数据量过大,可以考虑使用随机键的方式将数据打散,从而使数据更加均衡地分配到不同的计算节点中。具体地,可以在 keyBy() 方法中使用随机生成的键来进行分区。

-

增加并行度:如果数据倾斜的原因是某些计算节点的负载过重,可以考虑增加计算节点的并行度,从而将数据更加均衡地分配到不同的计算节点中进行处理。具体地,可以使用 setParallelism() 方法来设置算子的并行度。

-

使用副本数据:副本数据是指将数据复制到多个节点上,从而减少数据倾斜的情况。在 Flink 中,可以使用 broadcast、rebalance 或 shuffle 等算子将数据复制到多个节点上。但是,副本数据也会增加任务的通信开销和资源消耗,需要根据任务的实际情况进行权衡和调整。

-

扩大窗口大小:通过扩大窗口大小可以使窗口内的数据更加均衡地分配到不同的计算节点中,从而减少数据倾斜的情况。但是需要注意,过大的窗口大小可能会影响任务的延迟和内存消耗,需要根据任务的实际情况进行权衡。

需要注意的是,每种方法都有其适用的场景和限制条件,需要根据任务的实际情况和数据的分布情况,选择相应的优化策略来解决数据倾斜问题。同时,还可以通过对代码进行优化、调整数据结构、缓存中间结果等方式来进一步优化任务的性能和可靠性。以下是一个简单的 Java 代码示例,演示如何使用随机键和增加并行度来解决 Flink 任务的数据倾斜问题:

DataStream<Tuple2<String, Integer>> stream = ...;

// 使用随机键将数据打散

DataStream<Tuple2<String, Integer>> keyedStream = stream

.keyBy(new KeySelector<Tuple2<String, Integer>, String>() {

@Override

public String getKey(Tuple2<String, Integer> value) throws Exception {

return UUID.randomUUID().toString();

}

});

// 增加并行度

DataStream<Tuple2<String, Integer>> resultStream = keyedStream

.map(new MapFunction<Tuple2<String, Integer>, Tuple2<String, Integer>>() {

@Override

public Tuple2<String, Integer> map(Tuple2<String, Integer> value) throws Exception {

// 处理数据

return value;

}

})

.setParallelism(10);

在上述代码中,我们首先使用随机键将数据打散,从而使数据更加均衡地分配到不同的计算节点中。然后,我们使用 map() 算子进行数据处理,并使用 setParallelism() 方法将算子的并行度设置为 10,从而增加计算节点的数量,进一步减少数据倾斜的情况。需要注意的是,随机键和增加并行度的方式并不适用于所有的任务场景,需要根据任务的实际情况进行选择和权衡。文章来源:https://www.toymoban.com/news/detail-621658.html

总结

综上,解决flink任务数据倾斜的方法有多种,需要根据实际的问题和情况(包括资源情况)进行选择使用。文章来源地址https://www.toymoban.com/news/detail-621658.html

到了这里,关于如何解决Flink任务的数据倾斜的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!