在计算各省份的GMV时,有可能会发生数据倾斜,解决办法如下:文章来源地址https://www.toymoban.com/news/detail-623747.html

- 分组聚合

- 预聚合思想 map-side(预聚合在map里面)

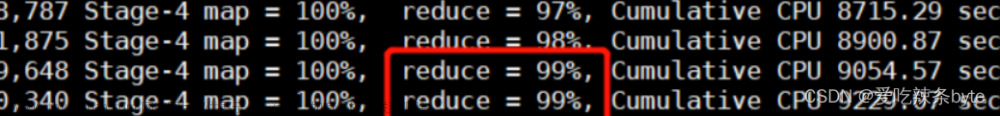

- skew-groupby(多个reduce阶段进行汇总):先对倾斜的key加上随机数,均匀分发到不同的reduce,进行一次聚合,然后去掉随机数,再发到一个reduce进行聚合。

- 表与表的关联

- map-join:大表JOIN小表

- skew-join:如果检测到有key比较多的,那么单独开启一个mapjoin去计算,其他正常的使用common join

- 分桶join:大表JOIN大表

- 如何判断是key发生数据倾斜?

- limit

- table_sample 抽样函数

文章来源:https://www.toymoban.com/news/detail-623747.html

到了这里,关于Hive-数据倾斜的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!