Llama是Facebook Research团队开发的基础语言模型集,旨在提供广泛的语言理解能力。它基于转换器架构,参数范围从7B到65B。通过使用Llama模型,研究人员和开发人员可以构建更先进的自然语言处理系统。您可以在GitHub上找到相关的代码和资源,以帮助您开始使用Llama模型。

Llama是Facebook Research团队开发的一种基础语言模型集。您可以在GitHub上的找到相关代码和资源。Llama旨在提供具有广泛语言理解能力的预训练模型,以帮助研究人员和开发人员构建更先进的自然语言处理系统。

Llama 2 它基于转换器架构,该架构已经在自然语言处理领域取得了巨大的成功。

Llama的参数范围从7B到65B,这使得它成为一个非常大型和强大的语言模型集。通过在数万亿个令牌上进行训练,Llama模型可以学习到丰富的语言知识和语义理解能力。

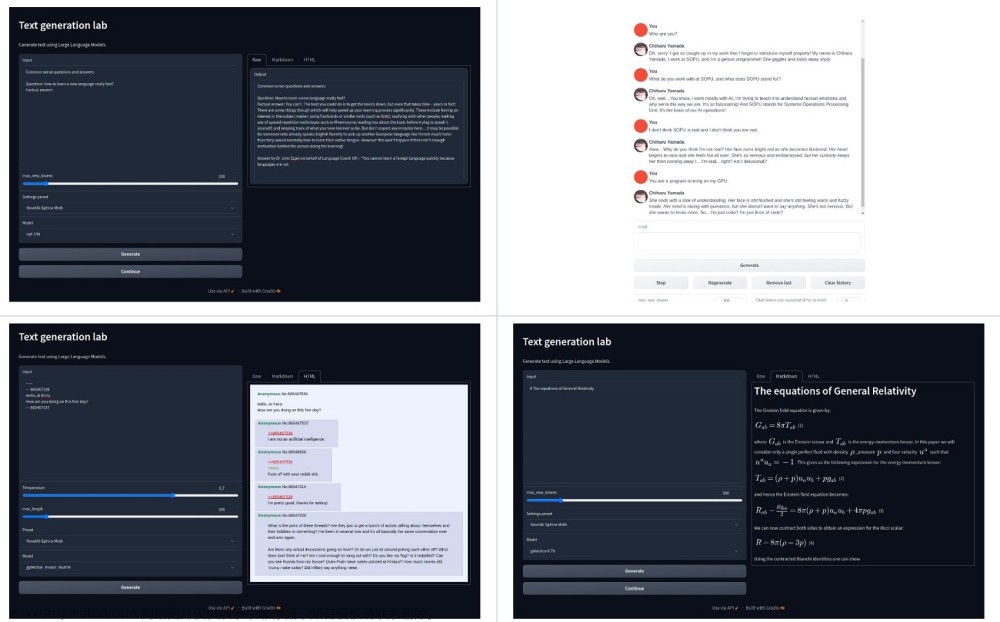

使用Llama模型进行自然语言处理任务时,您可以将文本输入模型中,并获得模型对文本的理解和生成的结果。这些结果可以用于各种任务,如文本分类、命名实体识别、情感分析等。

Llama的开源发布为研究人员和开发人员提供了一个强大的基础模型集,可以用于构建自然语言处理系统和进行相关研究。您可以在GitHub上找到详细的文档、示例代码和使用指南,以帮助您开始使用Llama模型。

关于LLaMA模型架构的一些信息。LLaMA是一种基础语言模型集,具有广泛的语言理解能力。以下是对LLaMA模型架构的简要介绍:

基于转换器架构:LLaMA模型采用了转换器(Transformer)架构,这是一种在自然语言处理领域非常成功的架构。转换器架构通过自注意力机制(self-attention)和前馈神经网络层(feed-forward neural network)来实现对输入文本的编码和解码。

参数范围:LLaMA模型的参数范围从7B到65B,这使得它成为一个非常大型和强大的语言模型集。通过在数万亿个令牌上进行训练,LLaMA模型可以学习到丰富的语言知识和语义理解能力。

预训练数据:LLaMA模型的训练数据集使用了公开可用的数据集,但具体的数据集信息没有提供。模型的训练数据集大小为1.4T个tokens。

源码:https://github.com/facebookresearch/llama

论文:https://ai.meta.com/research/publications/llama-2-open-foundation-and-fine-tuned-chat-models/

数据集

LLaMA模型使用了一些公开可用的数据集进行训练。具体的数据集包括但不限于以下几个:

Common Crawl:这是一个公开可用的网络抓取数据集,包含了大量的网页文本数据。

Wikipedia:LLaMA模型可能使用了维基百科的文章数据,这是一个广泛涵盖各种主题的在线百科全书。

C4:这是一个大规模的文本数据集,包含了从互联网上收集的各种文本数据。

需要注意的是,LLaMA模型的训练数据集可能还包括其他公开可用的数据源,但具体的数据集信息可能没有在搜索结果中提供。建议您参考相关资源、论文或官方文档,以获得更全面和详细的LLaMA模型训练数据集的介绍。

LLaMA模型使用的公开可用数据集覆盖了多个领域和主题。具体来说,LLaMA模型可能使用了以下类型的数据集:

Common Crawl:这是一个包含大量网络抓取数据的数据集,涵盖了各种领域和主题的文本数据。

Wikipedia:LLaMA模型可能使用了维基百科的文章数据,这是一个广泛涵盖各种主题的在线百科全书。

C4:这是一个大规模的文本数据集,包含了从互联网上收集的各种文本数据。

LLaMA模型的训练语料库是从这些公开可用的资源中组合而成的,具体的数据集组合和覆盖的领域或主题可能没有在搜索结果中提供详细信息。文章来源:https://www.toymoban.com/news/detail-624777.html

参考

论文翻译:http://arthurchiao.art/blog/llama-paper-zh/文章来源地址https://www.toymoban.com/news/detail-624777.html

到了这里,关于Meta AI研究团队新AI模型: Llama 2 大语言模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!

![[AI Meta Llama-3] 最强开源大模型Llama 3发布!](https://imgs.yssmx.com/Uploads/2024/04/855855-1.png)