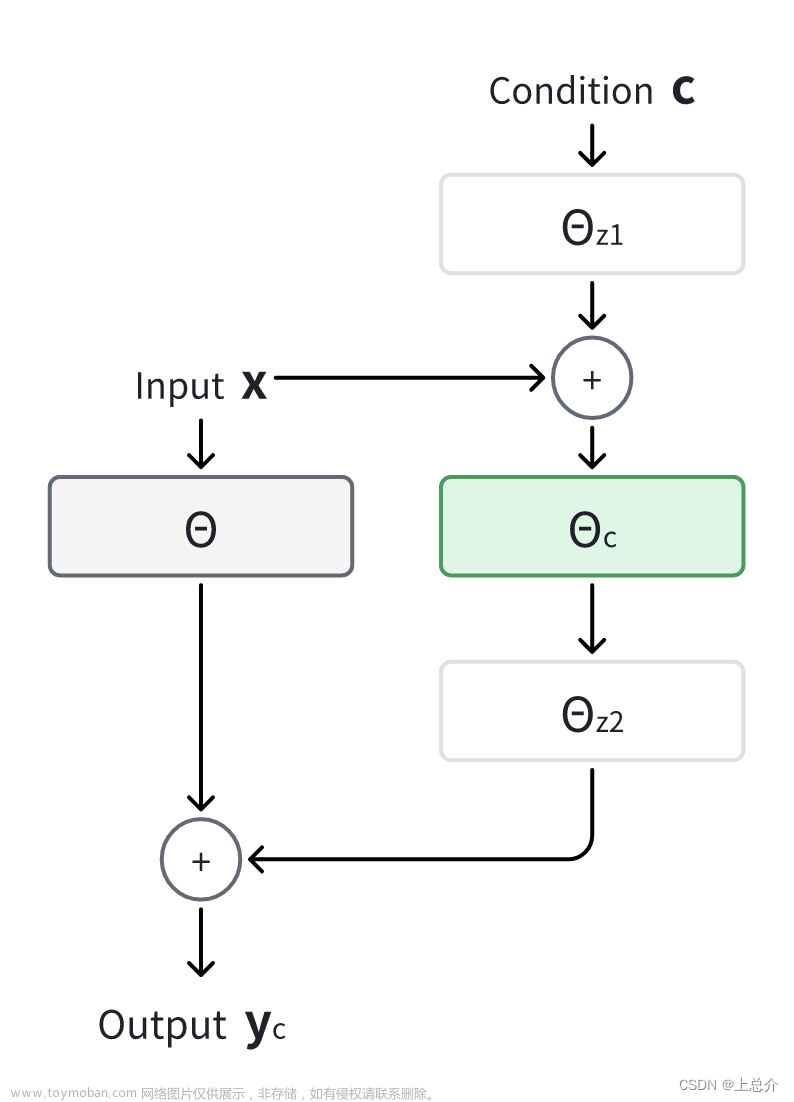

本项目基于SadTalkers实现视频唇形合成的Wav2lip。视频+语言(MP4+WAV)>>视频

1. 搭建环境

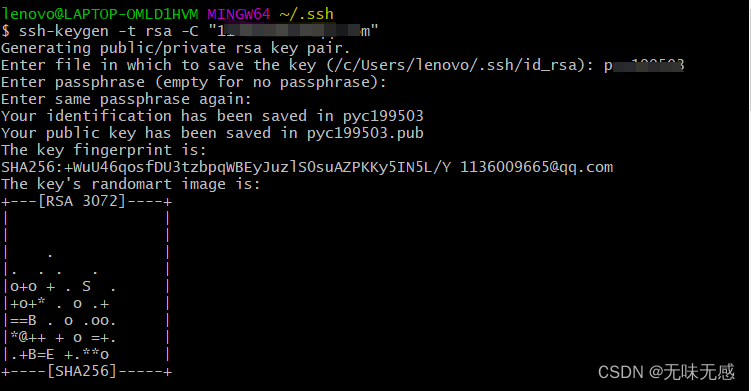

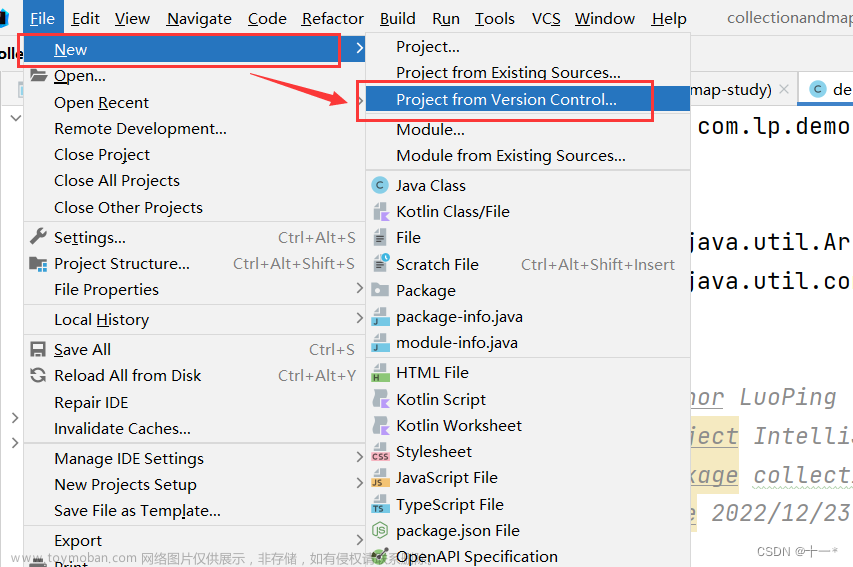

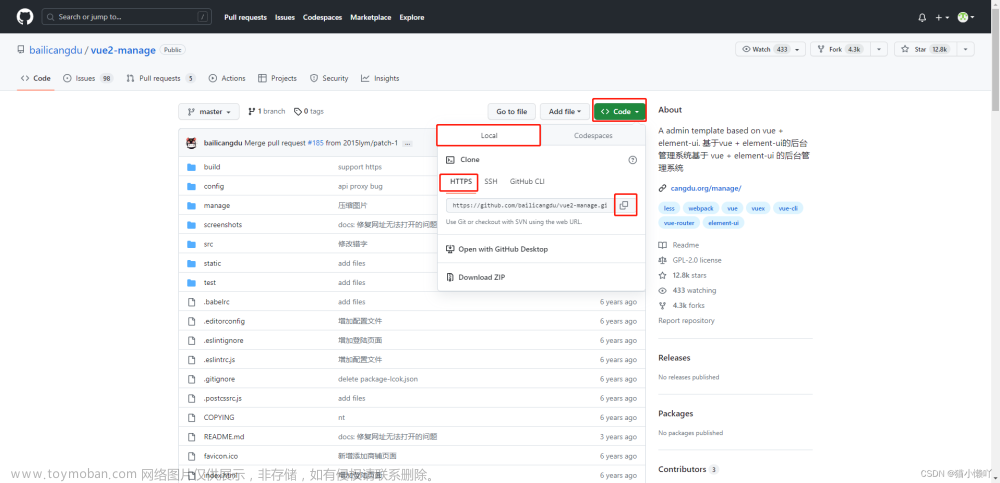

首先使用Anaconda创建一个虚拟环境SadTalker,然后打开cmd使用命令conda activate SadTalker切换环境,在D盘新建一个文件夹SadTalker-Video-Lip-Sync,cmd切换到该文件夹,使用命令git clone https://github.com/Zz-ww/SadTalker-Video-Lip-Sync.git将项目拉取下来,接着使用以下命令下载项目所需的包。

pip install torch==1.12.1+cu113 torchvision==0.13.1+cu113 torchaudio==0.12.1 --extra-index-url https://download.pytorch.org/whl/cu113

conda install ffmpeg

pip install -r requirements.txt

#如需使用DAIN模型进行补帧需安装paddle

# CUDA 11.2

python -m pip install paddlepaddle-gpu==2.3.2.post112 \

-f https://www.paddlepaddle.org.cn/whl/linux/mkl/avx/stable.html

--extra-index-url:这是一个pip命令的选项(或称为长格式选项),用于指定额外的索引源URL。可以通过多次使用该选项来指定多个额外的索引源。

示例命令:pip install package_name --extra-index-url <URL>

-i:这是pip命令的缩写选项(或称为短格式选项),用于指定主要的索引源URL。可以通过多次使用该选项来指定多个主要的索引源。

示例命令:pip install package_name -i <URL>

主要区别在于:

--extra-index-url 用于指定额外的索引源URL,通常是在主要索引源无法满足需求时使用。例如,当你需要从特定的镜像源下载软件包时。-i 用于指定主要的索引源URL,即默认情况下pip会使用的索引源。如果未使用该选项,则会使用默认的官方索引源(https://pypi.org)。

如果下载太慢可以换国内镜像源:

清华大学:https://pypi.tuna.tsinghua.edu.cn/simple

豆瓣:https://pypi.douban.com/simple

2. 模型推理

预训练的模型checkpoints下载路径:

百度网盘:https://pan.baidu.com/s/15-zjk64SGQnRT9qIduTe2A 提取码:klfv

python inference.py --driven_audio <audio.wav> \

--source_video <video.mp4> \

--enhancer <none,lip,face> \ #(默认lip)

--use_DAIN \ #(使用该功能会占用较大显存和消耗较多时间)

--time_step 0.5 #(插帧频率,默认0.5,即25fps—>50fps;0.25,即25fps—>100fps)

需要注意的是要将2D改为TWO_D。

我执行的是代码如下:

python inference.py --driven_audio examples/driven_audio/chinese_poem1.wav \

--source_video examples/driven_video/1.mp4

3. 合成效果

#合成效果展示在./sync_show目录下:

#original.mp4 原始视频

#sync_none.mp4 无任何增强的合成效果

#none_dain_50fps.mp4 只使用DAIN模型将25fps添帧到50fps

#lip_dain_50fps.mp4 对唇形区域进行增强使唇形更清晰+DAIN模型将25fps添帧到50fps

#face_dain_50fps.mp4 对全脸区域进行增强使唇形更清晰+DAIN模型将25fps添帧到50fps#下面是不同方法的生成效果的视频

#our.mp4 本项目SadTalker-Video-Lip-Sync生成的视频

#sadtalker.mp4 sadtalker生成的full视频

#retalking.mp4 retalking生成的视频

#wav2lip.mp4 wav2lip生成的视频文章来源:https://www.toymoban.com/news/detail-629891.html

参考文献

https://github.com/Zz-ww/SadTalker-Video-Lip-Sync文章来源地址https://www.toymoban.com/news/detail-629891.html

到了这里,关于GitHub上的SadTalker-Video-Lip-Sync的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!