今天继续给大家介绍Python 爬虫相关知识,本文主要内容是Python requests库使用详解。

一、Python requests库简介

requests库是一个非常好用的HTTP请求库,常用于写网络请求和爬虫程序。相比于之前的urllib库。,requests操作非常简介。

requests库是Python的一个第三方库,因此要使用该库需要我们手动安装,执行命令:

pip install requests

即可。

二、requests库常用方法

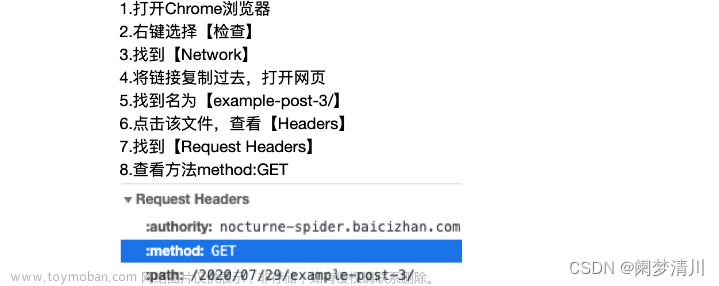

在引入requests库后,我们就可以使用requests库封装好的方法发送HTTP请求。常用的requests库方法如下所示:

response=requests.get(url,params,**kwargs)

response=requests.post(url,params,**kwargs)

在上述方法中,参数含义如下:

url:发起请求的目标URL地址,必须指明使用http协议或者是https协议。

params:发起请求携带的数据,如果是get方法,则以GET的方式携带,如果是post方法,则以POST的方式携带。

kwargs:控制请求访问的参数,使用后可以加入到requests请求的头部,常见的有User-Agent、Cookie等。

除了上述2种常见的方法外,requests库还支持以下5种不是很常见的方法:head、put、patch、delete、options。这些方法使用就不过多介绍了。文章来源:https://www.toymoban.com/news/detail-631040.html

三、response对象使用

调用上述requests方法后,返回的结果是一个response响应对象。我们可以调用该对象的一些属性和方法来获取部分响应数据,response对象常见属性和方法如下所示:

1、response.text

返回响应结果主体部分的字符串格式数据。

2、response.content

返回响应结果主题部分的字节数据,如果响应结果是一张图片,则应该使用这种方式。

3、response.json()

如果响应结果是一个json格式的数据,则可以使用这种方式提取数据。

4、response.status_code

返回响应的状态码。

5、response.reason

返回响应状态信息。

6、response.cookies

返回响应cookie信息。

7、response.encoding

返回响应编码。

8、response.headers

返回响应头信息。

原创不易,转载请说明出处:https://blog.csdn.net/weixin_40228200文章来源地址https://www.toymoban.com/news/detail-631040.html

到了这里,关于Python requests库使用详解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!