本节指导如何利用Lightning进行可视化和监控模型

为何需要跟踪参数

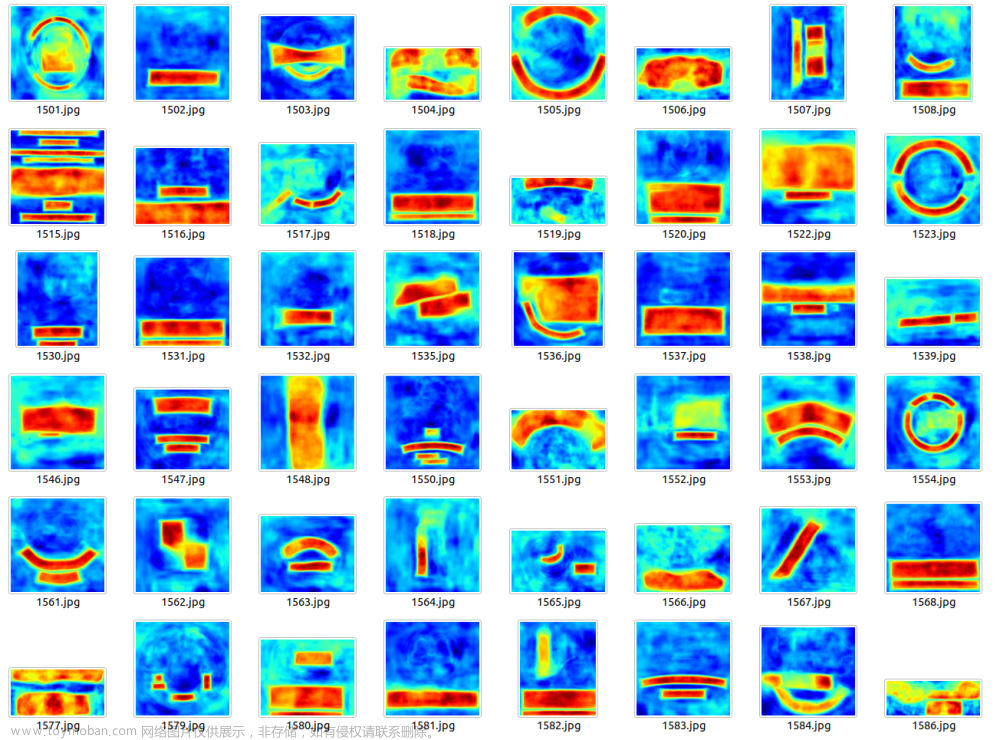

在模型开发中,我们跟踪感兴趣的值,例如validation_loss,以可视化模型的学习过程。模型开发就像驾驶一辆没有窗户的汽车,图表和日志提供了窗口,让我们知道该把车开到哪里。有了Lightning,几乎可以可视化任何你能想到的东西:数值、文本、图像、音频…

跟踪指标

度量可视化是理解模型在整个模型开发过程中如何运行的最基本但最强大的方法。要跟踪指标,只需使用LightningModule中的self.log方法

class LitModel(pl.LightningModule):

def training_step(self, batch, batch_idx):

value = ...

self.log("some_value", value)

要一次记录多个指标,使用self.log_dict

values = {"loss": loss, "acc": acc, "metric_n": metric_n} # add more items if needed

self.log_dict(values)

要在命令行进度条中查看指标,需将prog_bar参数设置为True。

self.log(..., prog_bar=True)

命令行视图

如果要在浏览器中查看指标,默认情况下,Lightning使用Tensorboard和一个简单的CSV日志记录器。

# 默认情况下,每个训练器已经启用了tensorboard(如果依赖项可用)

trainer = Trainer()

使用如下命令进行显示

tensorboard --logdir=lightning_logs/

如果您使用的是notebook环境,如colab或kaggle或jupyter,使用如下命令启动Tensorboard

%reload_ext tensorboard

%tensorboard --logdir=lightning_logs/

累计指标

当在training_step中调用self.log时,它会生成一个时间序列,显示指标随时间的变化情况。

然而,对于验证和测试集,我们通常对绘制每批数据的指标不感兴趣。相反,我们希望在整个数据分割中计算汇总统计(例如平均值、最小值或最大值)。

当您在validation_step和test_step中调用self.log时,Lightning会自动累积指标并在整个分割(epoch)完成后取平均值。

def validation_step(self, batch, batch_idx):

value = batch_idx + 1

self.log("average_value", value)

如果不想取平均值,也可以通过传递reduce_fx参数从{min,max,sum}中进行选择。

# default function

self.log(..., reduce_fx="mean")

对于其他reductions,我们建议记录一个torchmetrics.Metric 实例取代。文章来源:https://www.toymoban.com/news/detail-632527.html

配置保存目录

默认情况下,任何记录的内容都保存到当前工作目录中。要使用不同的目录,请在Trainer中设置default_root_dir参数。文章来源地址https://www.toymoban.com/news/detail-632527.html

Trainer(default_root_dir="/your/custom/path")

到了这里,关于PyTorch Lightning教程七:可视化的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!