嗨,爬虫程序员们!你们是否在了解爬虫发送的请求流量和接收的响应信息上有过困扰?今天,我们一起来了解一下。

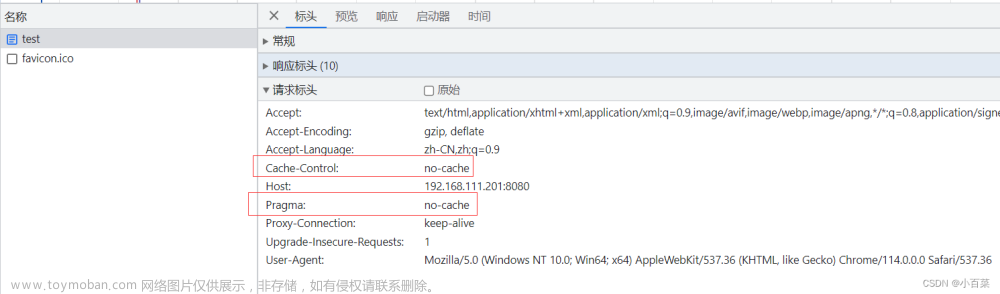

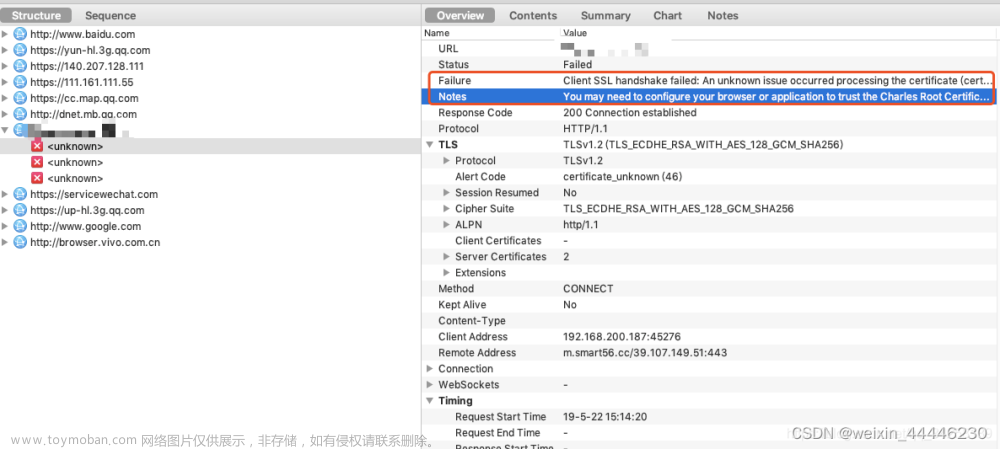

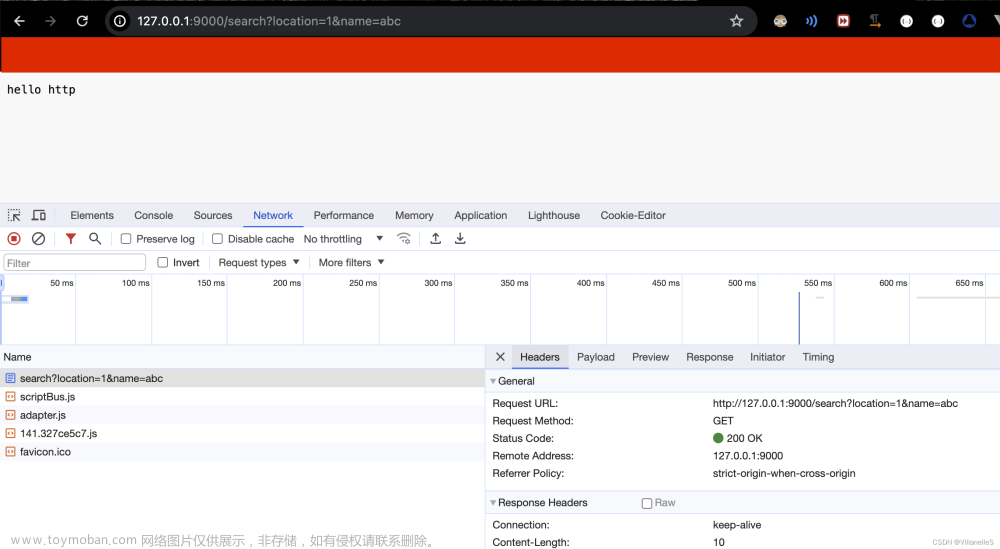

首先,我们需要理解HTTP代理日志的基本结构和内容。HTTP代理日志是对爬虫发送的请求和接收的响应进行记录的文件。在日志中,我们可以看到每一次请求的细节,比如请求的URL、请求方法、请求头部、请求时间等。同样,我们也可以看到响应的相关信息,如响应状态码、响应时间、响应头部等。通过分析这些信息,我们能够深入了解爬虫的运行情况和与目标网站的交互过程。

让我们来看一个简单的代理日志示例:

```

2022-01-01 10:30:45 - INFO: Request Sent: GET http://example.com

2022-01-01 10:30:46 - INFO: Response Received: 200 OK

2022-01-01 10:30:46 - INFO: Request Sent: POST http://example.com/login

2022-01-01 10:30:47 - INFO: Response Received: 401 Unauthorized

```

在上述示例中,我们可以看到每一次请求发送和响应接收的时间,以及请求的方法和URL。同时,我们也可以看到响应的状态码,包括200 OK和401 Unauthorized等。

那么,HTTP代理日志对我们有什么实际操作价值呢?让我们来看一些例子:

1. 排查请求异常:如果爬虫的请求没有得到预期的响应,我们可以通过代理日志来分析请求是否发送成功、是否收到响应。通过对比预期的请求和响应信息,我们可以找到问题所在,进而调试和修复代码。

2. 监控爬虫性能:通过分析请求时间、响应时间,我们可以了解爬虫的运行速度和效率。如果发现请求时间过长,我们可以考虑优化爬虫的代码,提高爬取速度。

3. 识别反爬机制:分析响应状态码和响应内容,我们可以判断目标网站是否有反爬虫机制。如果我们频繁收到401 Unauthorized等状态码,说明网站可能对我们的请求进行了限制。通过此信息,我们可以进一步调整爬虫策略,比如使用代理、调整请求频率等。

现在,让我们来看一个代码示例,帮助我们更好地理解代理日志的分析:

```python

import logging

logging.basicConfig(filename='proxy.log', level=logging.INFO, format='%(asctime)s - %(levelname)s: %(message)s')

def send_request(url):

logging.info(f"Request Sent: GET {url}")

try:

response = requests.get(url, timeout=5)

logging.info(f"Response Received: {response.status_code} {response.reason}")

if response.status_code == 200:

return response.text

except Exception as e:

logging.error(f"Request Failed: {str(e)}")

return None

url = "http://example.com"

response = send_request(url)

if response:

print(response)

else:

print("Failed to retrieve data")

```

在上面的示例中,我们使用Python的logging模块,配置了一个日志文件proxy.log。在发送请求和接收响应的关键步骤,我们使用logging.info()方法记录请求和响应的信息。通过这种方式,我们可以轻松地生成代理日志,并对其进行分析。

HTTP代理日志不仅有助于我们排查爬虫问题,还能帮助我们监控爬虫性能和识别反爬机制。记得在使用日志时,保护用户隐私和网站的合法权益,合理使用代理和处理日志数据。文章来源:https://www.toymoban.com/news/detail-633701.html

有关HTTP代理日志的更多操作和分析技巧,欢迎与我分享你的经验和想法。愿你的爬虫之路越走越远,快乐编程!文章来源地址https://www.toymoban.com/news/detail-633701.html

到了这里,关于了解HTTP代理日志:解读请求流量和响应信息的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!