大家好,我是微学AI,今天给大家介绍一下人工智能深度学习100种网络模型,这些模型可以用PyTorch深度学习框架搭建。模型按照个人学习顺序进行排序:

深度学习模型文章来源:https://www.toymoban.com/news/detail-634623.html

-

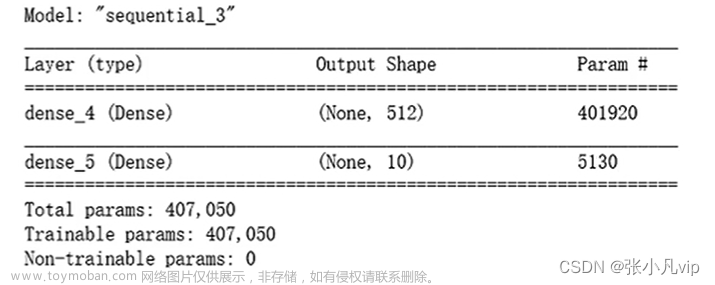

ANN (Artificial Neural Network) - 人工神经网络:基本的神经网络结构,包括输入层、隐藏层和输出层。

学习点击地址 -

CNN (Convolutional Neural Network) - 卷积神经网络:主要用于图像识别和处理的基础神经网络结构。

学习点击地址 -

RNN (Recurrent Neural Network) - 循环神经网络:用于处理序列数据的神经网络结构。

学习点击地址 -

LSTM (Long Short-Term Memory) - 长短时记忆网络:一种特殊的RNN,用于解决长序列中的梯度消失问题。

学习点击地址 -

GRU (Gated Recurrent Unit) - 门控循环单元:一种简化版的LSTM,用于处理序列数据。

学习点击地址 -

BiLSTM (Bidirectional LSTM) - 双向长短时记忆网络:同时考虑序列的正向和反向信息的LSTM。

学习点击地址 -

BiGRU (Bidirectional GRU) - 双向门控循环单元:同时考虑序列的正向和反向信息的GRU。

学习点击地址 -

Transformer - Transformer模型:一种基于自注意力机制的神经网络结构,用于处理序列数据。

学习点击地址 -

BERT (Bidirectional Encoder Representations from Transformers) - 双向Transformers编码器模型:一种基于Transformer的预训练模型,用于自然语言处理任务。

学习点击地址 -

ELMo (Embeddings from Language Models) - 语言模型嵌入:一种基于双向LSTM的预训练模型,用于自然语言处理任务。

学习点击地址 - RoBERTa (Robustly Optimized BERT Pretraining Approach) - 稳健优化的BERT预训练方法:一种改进的BERT预训练模型。

-

T5 (Text-to-Text Transfer Transformer) - 文本到文本传输变压器:一种基于Transformer的预训练模型,用于自然语言处理任务。

学习点击地址 - GPT (Generative Pre-trained Transformer) - 生成预训练Transformer:一种基于Transformer的生成式预训练模型,用于自然语言处理任务。

- GPT-2 (Generative Pre-trained Transformer 2) - 生成预训练Transformer2:一种基于Transformer的生成式预训练模型,用于自然语言处理任务。

- GPT-3 (Generative Pre-trained Transformer 3) - 生成预训练Transformer3:一种基于Transformer的生成式预训练模型,用于自然语言处理任务。

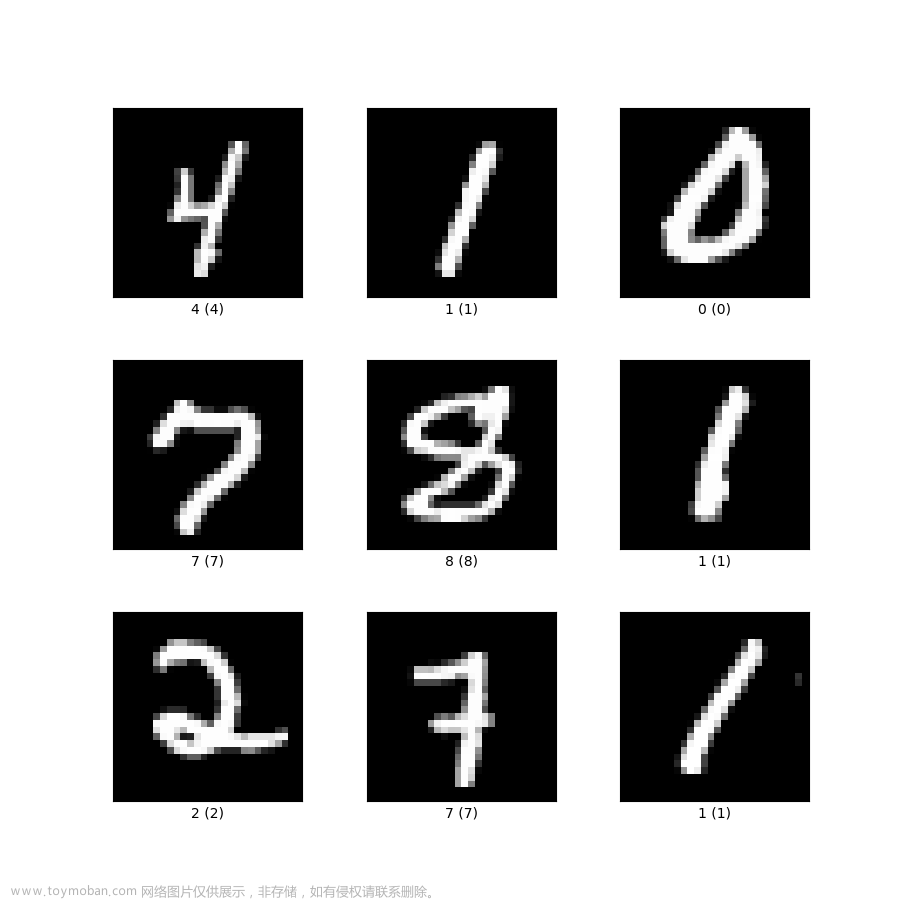

- LeNet (LeNet-5) - LeNet-5:一种早期的卷积神经网络,用于手写数字识别。

- AlexNet - AlexNet:一种深度卷积神经网络,用于图像识别,赢得了2012年的ImageNet竞赛。

-

ResNet (Residual Network) - 残差网络:一种具有残差连接的深度卷积神经网络,用于图像识别。

学习点击地址 - VGG (Visual Geometry Group) - 视觉几何组:一种深度卷积神经网络,用于图像识别。

- Inception - Inception网络:一种具有多尺度卷积的深度卷积神经网络,用于图像识别。

- MobileNet - 移动网络:一种轻量级的卷积神经网络,用于移动设备上的图像识别。

- DenseNet (Densely Connected Convolutional Network) - 密集连接卷积网络:一种具有密集连接的深度卷积神经网络,用于图像识别。

-

U-Net - U型网络:一种用于图像分割的卷积神经网络。

学习点击地址 - GAN (Generative Adversarial Network) - 生成对抗网络:一种生成式模型,由生成器和判别器组成,用于生成新的数据样本。

-

DCGAN (Deep Convolutional Generative Adversarial Network) - 深度卷积生成对抗网络:一种基于卷积神经网络的GAN。

学习点击地址 - WGAN (Wasserstein Generative Adversarial Network) - 瓦asserstein生成对抗网络:一种改进的GAN,使用Wasserstein距离作为损失函数。

- Pix2Pix - Pix2Pix网络:一种用于图像到图像转换的条件生成对抗网络。

- CycleGAN - CycleGAN网络:一种用于无监督图像到图像转换的生成对抗网络。

- StyleGAN (Style-Based Generative Adversarial Network) - 基于样式的生成对抗网络:一种用于生成高质量图像的GAN。

- CapsNet (Capsule Network) - 胶囊网络:一种用于图像识别的神经网络结构,包含胶囊层。

-

SNN (Spiking Neural Network) - 脉冲神经网络:一种模拟生物神经元动力学的神经网络结构。

学习点击地址 -

RBM (Restricted Boltzmann Machine) - 受限玻尔兹曼机:一种生成式模型,用于特征学习和降维。

学习点击地址 - DBN (Deep Belief Network) - 深度信念网络:一种基于RBM的深度生成式模型。

- Autoencoder - 自编码器:一种用于特征学习和降维的神经网络结构。

- VAE (Variational Autoencoder) - 变分自编码器:一种生成式自编码器,用于生成新的数据样本。

- Seq2Seq (Sequence-to-Sequence) - 序列到序列模型:一种用于序列到序列转换的神经网络结构,包括编码器和解码器。

- Attention - 注意力机制:一种用于加权序列中不同部分的神经网络结构。

- NMT (Neural Machine Translation) - 神经机器翻译:一种基于Seq2Seq和注意力机制的神经网络结构,用于机器翻译。

- ALBERT (A Lite BERT) - 轻量级BERT:一种轻量级的BERT预训练模型。

- XLM (Cross-lingual Language Model) - 跨语言语言模型:一种用于多语言自然语言处理任务的预训练模型。

- XLM-R (XLM-RoBERTa) - XLM-RoBERTa:一种基于RoBERTa的跨语言预训练模型。

- DeBERTa (Decoding-enhanced BERT with Disentangled Attention) - 解码增强的BERT与解耦注意力:一种改进的BERT预训练模型,具有解耦注意力机制。

- ELECTRA (Efficiently Learning an Encoder that Classifies Token Replacements Accurately) - 高效学习精确分类令牌替换的编码器:一种基于生成对抗网络的预训练模型。

- FastText - FastText:一种用于文本分类和词嵌入的神经网络模型。

- Word2Vec - Word2Vec:一种用于词嵌入的神经网络模型。

- GloVe (Global Vectors for Word Representation) - 全局词向量表示:一种用于词嵌入的神经网络模型。

-

Siamese Network - 孪生网络:一种用于度量学习和相似性比较的神经网络结构。

学习点击地址 - Triplet Network - 三元组网络:一种用于度量学习和相似性比较的神经网络结构,包括三个相互关联的子网络。

- YOLO (You Only Look Once) - 一次性查看:一种实时目标检测的神经网络模型。

- SSD (Single Shot MultiBox Detector) - 单次多框检测器:一种实时目标检测的神经网络模型。

- RetinaNet - RetinaNet:一种用于目标检测的神经网络模型,具有特征金字塔网络和锚框。

- Mask R-CNN - Mask R-CNN:一种用于实例分割的神经网络模型,基于Faster R-CNN。

- NASNet (Neural Architecture Search Network) - 神经架构搜索网络:一种通过神经架构搜索自动设计的神经网络模型。

- EfficientNet - EfficientNet:一种自动调整网络深度、宽度和分辨率的神经网络模型。

- SqueezeNet - SqueezeNet:一种轻量级的卷积神经网络,用于图像识别。

- ShuffleNet - ShuffleNet:一种轻量级的卷积神经网络,用于图像识别,具有通道混洗操作。

- MnasNet - MnasNet:一种通过神经架构搜索自动设计的轻量级卷积神经网络,用于图像识别。

- PNASNet (Progressive Neural Architecture Search) - 渐进式神经架构搜索:一种通过渐进式神经架构搜索自动设计的神经网络模型。

- RCNN (Region-based Convolutional Neural Network) - 基于区域的卷积神经网络:一种用于目标检测的神经网络模型。

- Fast R-CNN - Fast R-CNN:一种改进的R-CNN,用于目标检测,具有较快的训练和推理速度。

- Faster R-CNN - Faster R-CNN:一种改进的Fast R-CNN,用于目标检测,具有区域提议网络。

- R-FCN (Region-based Fully Convolutional Network) - 基于区域的全卷积网络:一种用于目标检测的神经网络模型,基于全卷积网络。

- FPN (Feature Pyramid Network) - 特征金字塔网络:一种用于目标检测的神经网络模型,具有多尺度特征金字塔。

- HRNet (High-Resolution Network) - 高分辨率网络:一种用于图像识别和语义分割的神经网络模型,保持高分辨率特征图。

- DeepLab - DeepLab:一种用于语义分割的神经网络模型,具有空洞卷积和条件随机场。

- PspNet (Pyramid Scene Parsing Network) - 金字塔场景解析网络:一种用于语义分割的神经网络模型,具有金字塔池化模块。

- NIN (Network in Network) - 网络中的网络:一种卷积神经网络,用于图像识别,具有多层感知机卷积层。

- SRGAN (Super-Resolution Generative Adversarial Network) - 超分辨率生成对抗网络:一种用于图像超分辨率的生成对抗网络。

- Ladder Network - 梯形网络:一种半监督学习的神经网络模型,具有多层编码器和解码器。

- CTC (Connectionist Temporal Classification) - 连接主义时序分类:一种用于序列到序列转换的神经网络损失函数,用于语音识别等任务。

- CPM (Convolutional Pose Machines) - 卷积姿态机:一种用于人体姿态估计的卷积神经网络模型。

- OpenPose - OpenPose:一种用于实时多人关键点检测的神经网络模型。

- WaveNet - WaveNet:一种用于生成原始波形音频的深度神经网络模型。

- Tacotron - Tacotron:一种用于文本到语音合成的神经网络模型,基于Seq2Seq和注意力机制。

- Transformer-XL (Transformer with extra-long context) - 变压器扩展长上下文:一种改进的Transformer,用于处理长序列数据。

- BigGAN (Big Generative Adversarial Network) - 大型生成对抗网络:一种用于生成高质量图像的大型生成对抗网络。

- ProGAN (Progressive Growing of GANs) - GAN的渐进式增长:一种通过逐渐增加生成器和判别器的分辨率来训练GAN的方法。

- SPADE (Spatially-Adaptive Normalization) - 空间自适应归一化:一种用于图像到图像转换的生成对抗网络,具有空间自适应归一化层。

- StarGAN - StarGAN:一种用于多域图像到图像转换的生成对抗网络。

- Swin Transformer - Swin Transformer:一种基于滑动窗口的Transformer,用于计算机视觉任务。

- ViT (Vision Transformer) - 视觉变压器:一种将图像分割成小块并将其视为序列的Transformer,用于图像识别。

- DeiT (Data-efficient Image Transformer) - 数据高效图像变压器:一种基于Vision Transformer的数据高效图像识别模型。

- Stable Diffusion - 稳定扩散网络模型,用于图像处理,文本生成图像的应用。

- Reformer - 改革者:一种改进的Transformer,用于处理长序列数据,具有局部敏感哈希和可逆残差层。

- Performer - 表演者:一种改进的Transformer,用于处理长序列数据,具有快速注意力机制。

- Linformer - 线性变压器:一种改进的Transformer,用于处理长序列数据,具有线性复杂度的自注意力机制。

- Longformer - 长变压器:一种改进的Transformer,用于处理长序列数据,具有稀疏自注意力机制。

- Conformer - 一致者:一种用于自动语音识别的神经网络模型,结合了Transformer和卷积神经网络。

- NeRF (Neural Radiance Fields) - 神经辐射场:一种用于三维场景重建的神经网络模型。

- DALL-E - DALL-E:一种基于Transformer的生成式模型,用于从文本描述生成图像。

- CLIP (Contrastive Language-Image Pretraining) - 对比性语言-图像预训练:一种同时学习图像和文本表示的预训练模型。

- DETR (DEtection TRansformer) - 检测变压器:一种基于Transformer的端到端目标检测神经网络模型。

- T2T-ViT (Tokens-to-Token Vision Transformer) - 令牌到令牌视觉变压器:一种基于令牌到令牌的视觉变压器,用于图像识别。

- OmniNet - OmniNet:一种用于多任务学习的神经网络模型,具有共享特征提取器和任务特定的分支。

- PointNet - PointNet:一种用于处理点云数据的神经网络模型。

- GCN (Graph Convolutional Network)- 图卷积神经网络:适用于处理图数据,尤其是基于图结构的数据分析和机器学习任务。

- SE-Net (Squeeze-and-Excitation Network) -基于通道注意力机制的卷积神经网络:通过学习每个通道间的关系来提高模型泛化能力。

- TSM (Temporal Shift Module) -时间序列模块:用于处理视频中的时间序列信息,可以在不增加计算量的情况下提高视频分类的准确率。

- STT (Speech-to-Text) -语音到文本模型:将语音信号转换成对应的文字。

- TTS (Text-to-Speech) -文本到语音模型:将文字信息转换成对应的语音信号。

以上模型涵盖了计算机视觉、自然语言处理、语音识别、生成模型等多个领域,可以根据实际需求选择合适的模型进行搭建和训练。文章来源地址https://www.toymoban.com/news/detail-634623.html

到了这里,关于人工智能深度学习100种网络模型,精心整理,全网最全,PyTorch框架逐一搭建的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!