一、生成式预训练模型(GPT: Generative Pre-trained Transformer)

当谈论ChatGPT的技术时,我们实际上在讨论OpenAI GPT模型。这是一个基于Transformer架构的大型语言模型,通过两个主要步骤进行训练:预训练和微调。

-

训练过程:预训练和微调。

首先,在预训练阶段,模型使用大量没有标签的文本数据(如维基百科、新闻、小说等),通过预测下一个单词来学习语言的规则和结构。这就像模型在自己练习写作,从中学习了语法、用词方式等。然后,在微调阶段,少量有标签的数据用于训练模型更好地完成特定任务,比如回答问题、分类文本等。模型在这里会根据任务的指导进行微调,就好像是在特定情境中应用它所学到的知识。

总之,OpenAI GPT模型的技术基础是Transformer网络,它通过预先学习语言的规则和微调以适应不同任务,从而在多种应用中表现出色。这就像是一个学写作的大脑,在不同任务中灵活运用所学,让它变得聪明而有用。

二、大语言模型(LLM: Large Language Model)

1、大语言模型、GPT、Transormer 关系

-

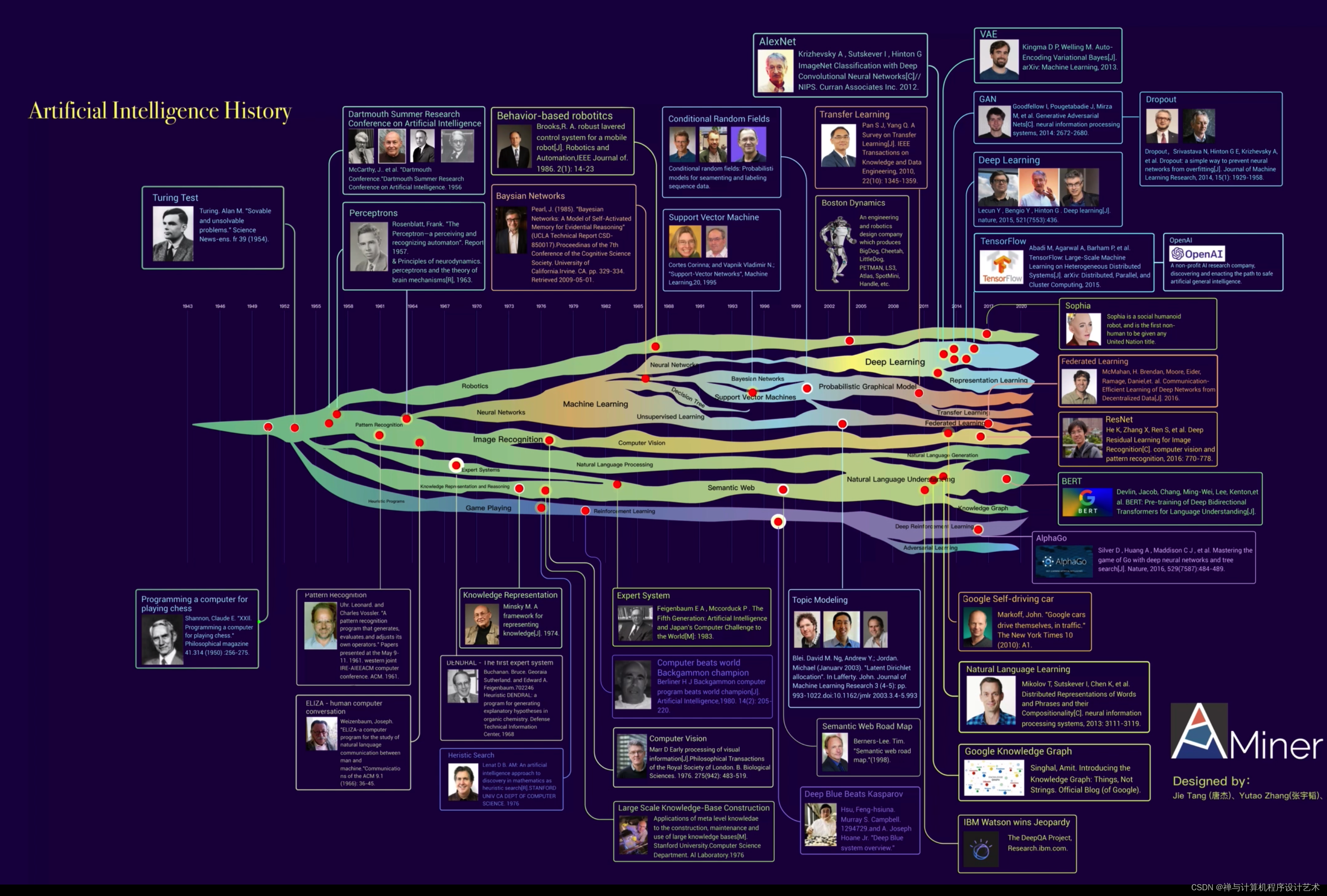

大语言模型、GPT和Transformer之间存在密切的关系,它们在自然语言处理和深度学习领域发挥重要作用。具体关系如下:

-

Transformer: Transformer是一种神经网络架构,最初设计用于机器翻译任务。它引入了注意力机制,通过编码器和解码器组件,能够有效地对序列数据进行建模。Transformer的关键创新是注意力机制,它能够处理长距离依赖关系,使得模型能够更好地捕捉上下文信息。

-

大语言模型: 大语言模型是基于Transformer架构的语言模型,旨在对自然语言进行建模和理解。这些模型通常在大规模无监督数据上进行预训练,以学习语言的结构和规律。GPT和BERT等模型都属于大语言模型的范畴,它们通过预训练的方式捕捉了丰富的语言信息。

-

GPT (Generative Pre-trained Transformer): GPT是基于Transformer架构和自监督预训练技术构建的模型。它是一种句子级别的生成模型,能够根据上下文生成连贯的文本。GPT模型通过预测下一个单词来学习语言的规则,然后在生成式任务中表现出色,比如文本生成、摘要生成和对话生成。

因此,大语言模型是在Transformer架构基础上构建的,它们通过自监督预训练来学习语言的特性。GPT是基于大语言模型的具体任务模型,使用Transformer架构和预训练技术,为生成式任务提供了强大的能力。总之,这三者共同构成了现代自然语言处理领域中的重要技术组成部分。

-

2、Transformer的多功能:从翻译到代码生成

-

虽然Transformer最初是为了机器翻译任务而设计的,但其特性使得它在编写代码方面也表现出色的原因有以下几点:

-

基于文本流的代码生成能力: 软件开发涉及大量的源代码编写,而源代码本质上是文本。GPT模型被训练用于预测下一个单词,这使其可以生成高质量的源代码。模型可以在生成代码的过程中融入软件开发标准、API接口等复杂性,有效地生成符合规范的代码。

-

上下文理解: 源代码通常需要在特定上下文中才能正确理解其含义。不同代码块之间可能存在微妙的差异,但它们功能相似。GPT模型能够根据上下文生成更具语法正确性和可读性的代码,从而更好地满足软件开发需求。

-

词向量表达: 源代码的语法结构是有规律的,它通常由特定领域的元素构成,这些元素具有明确的语义。GPT模型通过在大规模文本数据上进行预训练,学习到了丰富的词向量表示能力。这使得模型能够更好地理解代码中的语义和结构,生成更准确和高效的代码。

综上所述,基于Transformer的GPT模型在编写代码方面表现良好的原因在于其文本生成能力、上下文理解以及通过预训练获得的词向量表达能力。这些特性使GPT能够有效地生成高质量的源代码,满足开发人员在软件编写过程中的需求。

-

三、词向量检索

1,词向量检索概念

词向量检索:通过数字化的“词义”找到相似文本

-

词向量检索是一种文本查找方法,把文字变成数字,然后计算它们的相似度,找到相似的文字。

这个过程分成几步:

-

(1,整理文本: 先把原文分成词,去掉没用的词,留下有用的。

-

(2,变成向量: 用方法把每个词变成一个数字向量。这个向量有很多数,代表词的意思。

-

(3,处理查询: 把你的搜索词也变成向量,然后计算它和其他文本向量的相似度,找到最相似的。

-

(4,给结果: 把计算出来的相似度排序,呈现给你最相关的文本。

这个技术用在搜索引擎、推荐系统等地方。通过数字化的方式,更准确地衡量文本之间的相似度,让查找更准确、更快速

-

2,Embedding

-

OpenAI的Embedding是一种技术,用于将词语或句子转换成密集向量。这些向量可用于自然语言处理任务,如文本分类、情感分析和机器翻译。

在OpenAI的Embedding中,每个单词或句子都会被映射到向量空间中的一个点。与传统的one-hot编码不同,Embedding能够捕获词语之间的相似性和关系,使得机器学习算法更能理解自然语言表达的含义。

- 例如,在情感分析中,通过使用Embedding,我们可以将情感倾向相似的单词或短语映射到相似的向量空间位置。

- 这样,我们能够使用这些向量来训练机器学习模型,从而更准确地预测文本的情感。

四、Prompt

-

在AI中,Prompt是指给模型的文本指导,用于初始化和引导模型生成类似自然语言的输出。它可以是一段或多段文字,定义了模型生成的内容和风格。

为什么要用Prompt?因为它可以:文章来源:https://www.toymoban.com/news/detail-634885.html

- 1,引导生成: 帮助模型理解任务或上下文,生成更准确的输出。

- 2,定制风格: 通过Prompt,你可以让模型以特定风格、语气生成内容。

- 3,提供上下文: 当用户与AI交互时,Prompt可以传递之前的信息,生成有连贯性的回应。

未来是否会继续使用Prompt取决于技术发展。虽然可能出现新方法,但在目前,Prompt仍然是不可或缺的。在许多NLP应用中,它是引导模型生成准确输出的关键工具。文章来源地址https://www.toymoban.com/news/detail-634885.html

到了这里,关于AI_背景知识的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!