chatGLM算是个相对友好的模型,支持中英文双语的对话交流,清华出的

我的教程无需特别的网络设置,不过部分情况因为国内网络速度慢,需要反复重复

chatGLM github地址

一、硬件需求

N卡8G显存以上,最好16G以上,我用的是RTX4090做的测试,生成语言时很流畅,和正常人语速差不多,占用显卡资源不高,大概15%,没优化显存的情况下大概14G。

对内存需求不高,16G内存的设备就能运行。

二、基础环境

我才用conda的方式进行安装,需要首先安装下面的基础环境(这些环境通常已经有了)

windows和linux的安装方法基本一致。

1.conda安装

anaconda安装(win+linux)

2.cuda安装

我用的是11.8的cuda。

如果没有安装,按照我的这个教程:

cuda安装(linux)

cuda安装(windows)

3.pytorch

在下面具体的conda环境中配置

三、安装

没有具体说明的就是windows和linux通用的部分,linux如果权限不够自行提root,windows下的命令默认在cmd中运行,下面不在复述。windows下我放到C分区目录下,linux我放到/usr/local下

1.创建conda环境

conda create -n chatglm python=3.10.8

conda activate chatglm

2.安装pytorch

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

3.下载源码或者用git

如果是用git下载windows下

cd C:/

git clone https://github.com/THUDM/ChatGLM-6B.git

linux下

cd /usr/local

git clone https://github.com/THUDM/ChatGLM-6B.git

如果下载的是zip文件,记得改名,下载下来的包后面又main字样去掉,要不后面的命令都是错的

4.安装pytorch

直接下载速度会较慢,需要重复尝试,建议解决网络问题更方便。

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

5.安装源码

windows进入下面的目录,自行改名

cd C:\ChatGLM-6B

linux进入下面的目录

cd /usr/local/ChatGLM-6B

安装官方的列表内容

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

5.安装其它依赖

有些依赖官方没有写上,但是实际是需要的。

pip install streamlit -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install streamlit-chat -i https://pypi.tuna.tsinghua.edu.cn/simple

pip install chardet -i https://pypi.tuna.tsinghua.edu.cn/simple

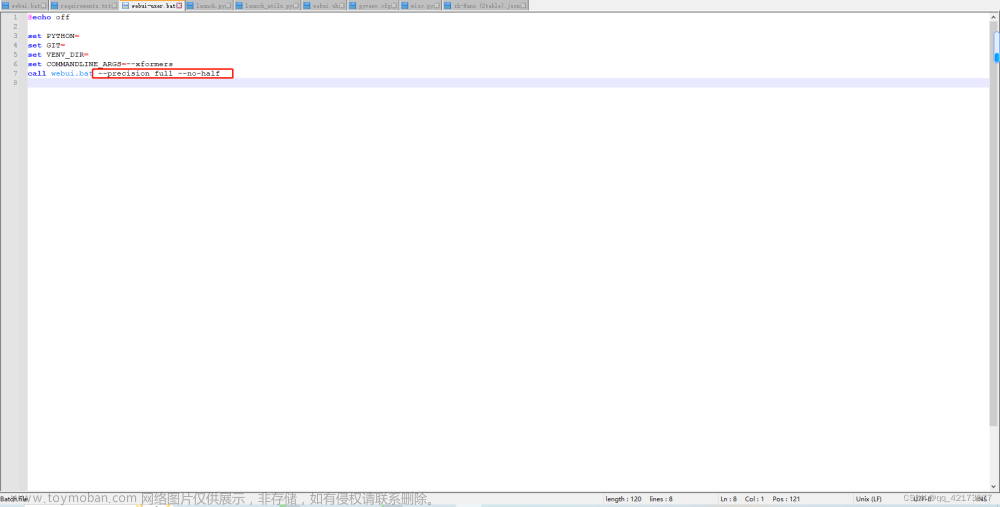

6.启动执行

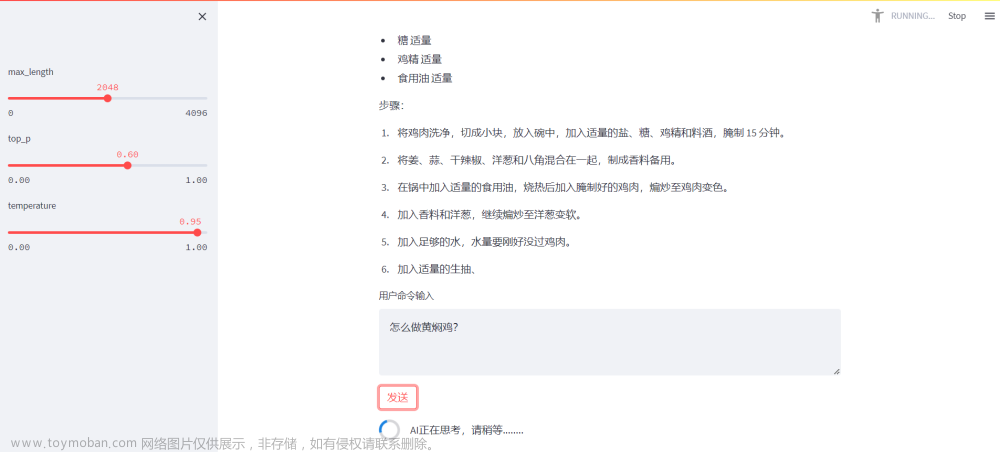

streamlit run web_demo2.py

7.进入web界面

访问ip:8501/

在对话框中输入问题

8.自动下载模型

首次提问后,先会去下载模型(可以在后台看到,耐心等待)

下载模型很快的,默认的网络速度很快,下载完成后就会回答你的问题。

四、其它

1.商用

官方写的是可以免费商用,需要申请,通过后给证书文章来源:https://www.toymoban.com/news/detail-634916.html

2.作为api

如果要用api调用,官方也有说明文章来源地址https://www.toymoban.com/news/detail-634916.html

到了这里,关于chatGLM 本地部署(windows+linux)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!