一、二进制搭建 Kubernetes v1.20

1、准备环境

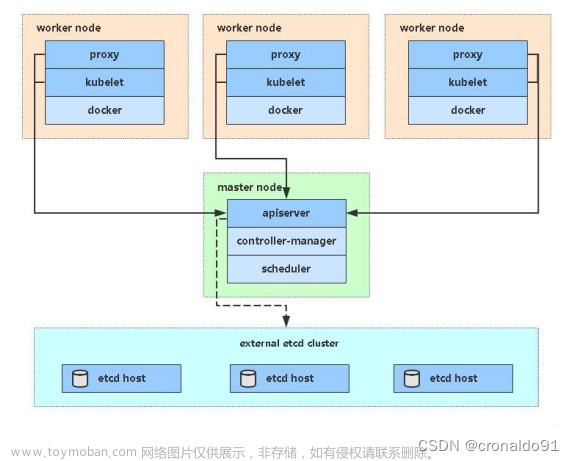

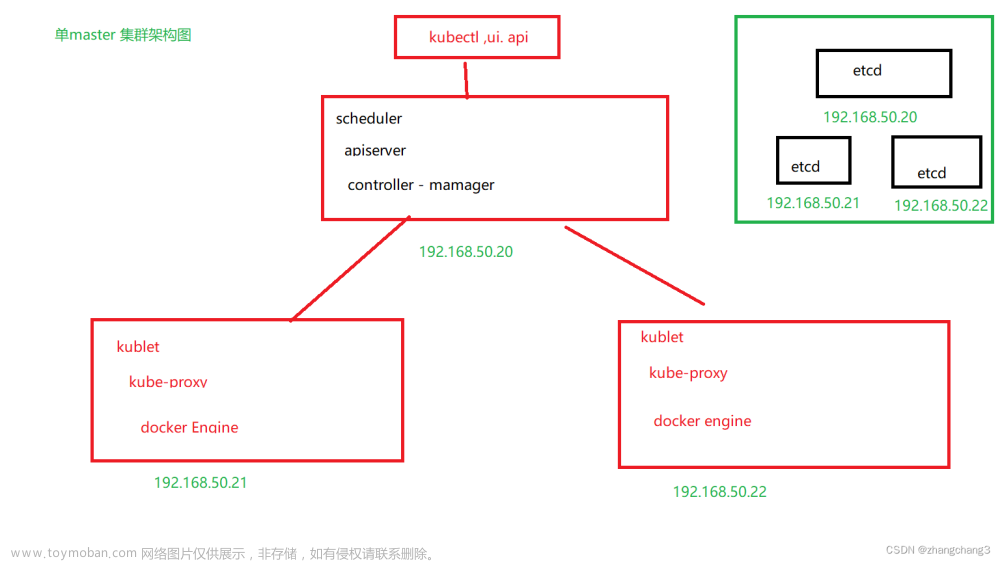

k8s集群master01:192.168.102.10 kube-apiserver kube-controller-manager kube-scheduler etcd

k8s集群master02:192.168.102.20

k8s集群node01:192.168.102.30 kubelet kube-proxy docker

k8s集群node02:192.168.102.40

etcd集群节点1:192.168.102.10 etcd

etcd集群节点2:192.168.102.30

etcd集群节点3:192.168.102.40

负载均衡nginx+keepalive01(master):192.168.102.50

负载均衡nginx+keepalive02(backup):192.168.102.60

二、操作系统初始化配置

1、关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

iptables -F && iptables -t nat -F && iptables -t mangle -F && iptables -X

2、关闭selinux

setenforce 0

sed -i 's/enforcing/disabled/' /etc/selinux/config

3、关闭swap

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

4、根据规划设置主机名

hostnamectl set-hostname master01

hostnamectl set-hostname node01

hostnamectl set-hostname node02

5、在master添加hosts

cat >> /etc/hosts << EOF

192.168.102.10 master01

192.168.102.20 node01

192.168.102.30 node02

EOF

6、调整内核参数

cat > /etc/sysctl.d/k8s.conf << EOF

#开启网桥模式,可将网桥的流量传递给iptables链

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

#关闭ipv6协议

net.ipv6.conf.all.disable_ipv6=1

net.ipv4.ip_forward=1

EOF

sysctl --system

7、给所有主机进行时间同步

yum install ntpdate -y

ntpdate ntp.aliyun.com

将时间同步命令放到每日执行文件中

三、部署 etcd 集群

etcd是CoreOS团队于2013年6月发起的开源项目,它的目标是构建一个高可用的分布式键值(key-value)数据库。etcd内部采用raft协议作为一致性算法,etcd是go语言编写的。

etcd 作为服务发现系统,有以下的特点:

简单:安装配置简单,而且提供了HTTP API进行交互,使用也很简单

安全:支持SSL证书验证

快速:单实例支持每秒2k+读操作

可靠:采用raft算法,实现分布式系统数据的可用性和一致性

etcd 目前默认使用2379端口提供HTTP API服务, 2380端口和peer通信(这两个端口已经被IANA(互联网数字分配机构)官方预留给etcd)。 即etcd默认使用2379端口对外为客户端提供通讯,使用端口2380来进行服务器间内部通讯。

etcd 在生产环境中一般推荐集群方式部署。由于etcd 的leader选举机制,要求至少为3台或以上的奇数台。

1、准备签发证书环境

CFSSL 是 CloudFlare 公司开源的一款 PKI/TLS 工具。 CFSSL 包含一个命令行工具和一个用于签名、验证和捆绑 TLS 证书的 HTTP API 服务。使用Go语言编写。

CFSSL 使用配置文件生成证书,因此自签之前,需要生成它识别的 json 格式的配置文件,CFSSL 提供了方便的命令行生成配置文件。

CFSSL 用来为 etcd 提供 TLS 证书,它支持签三种类型的证书:

1、client 证书,服务端连接客户端时携带的证书,用于客户端验证服务端身份,如 kube-apiserver 访问 etcd;

2、server 证书,客户端连接服务端时携带的证书,用于服务端验证客户端身份,如 etcd 对外提供服务;

3、peer 证书,相互之间连接时使用的证书,如 etcd 节点之间进行验证和通信。

这里全部都使用同一套证书认证。

2、在 master01 节点上操作

1、准备cfssl证书生成工具

wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64 -O /usr/local/bin/cfssl

wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64 -O /usr/local/bin/cfssljson

wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64 -O /usr/local/bin/cfssl-certinfo

chmod +x /usr/local/bin/cfssl*

cfssl:证书签发的工具命令

cfssljson:将 cfssl 生成的证书(json格式)变为文件承载式证书

cfssl-certinfo:验证证书的信息

cfssl-certinfo -cert <证书名称> #查看证书的信息

1、生成Etcd证书

mkdir /opt/k8s

cd /opt/k8s/

#上传 etcd-cert.sh 和 etcd.sh 到 /opt/k8s/ 目录中

chmod +x etcd-cert.sh etcd.sh

#创建用于生成CA证书、etcd 服务器证书以及私钥的目录

mkdir /opt/k8s/etcd-cert

mv etcd-cert.sh etcd-cert/

cd /opt/k8s/etcd-cert/

./etcd-cert.sh #生成CA证书、etcd 服务器证书以及私钥

#上传 etcd-v3.4.9-linux-amd64.tar.gz 到 /opt/k8s 目录中,启动etcd服务

cd /opt/k8s/

tar zxvf etcd-v3.4.26-linux-amd64.tar.gz

#创建用于存放 etcd 配置文件,命令文件,证书的目录

mkdir -p /opt/etcd/{cfg,bin,ssl}

cd /opt/k8s/etcd-v3.4.9-linux-amd64/

mv etcd etcdctl /opt/etcd/bin/

cp /opt/k8s/etcd-cert/*.pem /opt/etcd/ssl/

cd /opt/k8s/

./etcd.sh etcd01 192.168.102.10 etcd02=https://192.168.102.30:2380,etcd03=https://192.168.102.40:2380

#进入卡住状态等待其他节点加入,这里需要三台etcd服务同时启动,如果只启动其中一台后,服务会卡在那里,直到集群中所有etcd节点都已启动,可忽略这个情况

#可另外打开一个窗口查看etcd进程是否正常

ps -ef | grep etcd

#把etcd相关证书文件、命令文件和服务管理文件全部拷贝到另外两个etcd集群节点

scp -r /opt/etcd/ root@192.168.102.30:/opt/

scp -r /opt/etcd/ root@192.168.102.40:/opt/

scp /usr/lib/systemd/system/etcd.service root@192.168.102.30:/usr/lib/systemd/system/

scp /usr/lib/systemd/system/etcd.service root@192.168.102.40:/usr/lib/systemd/system/

3、在 node01 节点上操作

vim /opt/etcd/cfg/etcd

#启动etcd服务

systemctl start etcd

systemctl enable etcd

systemctl status etcd

4、在 node02 节点上操作

#启动etcd服务

systemctl start etcd

systemctl enable etcd

systemctl status etcd

检查etcd群集状态

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.102.10:2379,https://192.168.102.30:2379,https://192.168.102.40:2379" endpoint health --write-out=table

------------------------------------------------------------------------------------------

--cert-file:识别HTTPS端使用SSL证书文件

--key-file:使用此SSL密钥文件标识HTTPS客户端

--ca-file:使用此CA证书验证启用https的服务器的证书

--endpoints:集群中以逗号分隔的机器地址列表

cluster-health:检查etcd集群的运行状况

------------------------------------------------------------------------------------------

查看etcd集群成员列表

ETCDCTL_API=3 /opt/etcd/bin/etcdctl --cacert=/opt/etcd/ssl/ca.pem --cert=/opt/etcd/ssl/server.pem --key=/opt/etcd/ssl/server-key.pem --endpoints="https://192.168.102.10:2379,https://192.168.102.30:2379,https://192.168.102.40:2379" --write-out=table member list

四、部署 Master 组件

//在 master01 节点上操作

#上传 master.zip 和 k8s-cert.sh 到 /opt/k8s 目录中,解压 master.zip 压缩包

cd /opt/k8s/

unzip master.zip

chmod +x *.sh

#创建kubernetes工作目录

mkdir -p /opt/kubernetes/{bin,cfg,ssl,logs}

vim k8s-cert.sh

#进行修改master的ip地址

#创建用于生成CA证书、相关组件的证书和私钥的目录

mkdir /opt/k8s/k8s-cert

mv /opt/k8s/k8s-cert.sh /opt/k8s/k8s-cert

cd /opt/k8s/k8s-cert/

./k8s-cert.sh #生成CA证书、相关组件的证书和私钥

#复制CA证书、apiserver相关证书和私钥到 kubernetes工作目录的 ssl 子目录中

cp ca*pem apiserver*pem /opt/kubernetes/ssl/

#上传 kubernetes-server-linux-amd64.tar.gz 到 /opt/k8s/ 目录中,解压 kubernetes 压缩包

cd /opt/k8s/

tar zxvf kubernetes-server-linux-amd64.tar.gz

#复制master组件的关键命令文件到 kubernetes工作目录的 bin 子目录中

cd /opt/k8s/kubernetes/server/bin

cp kube-apiserver kubectl kube-controller-manager kube-scheduler /opt/kubernetes/bin/

ln -s /opt/kubernetes/bin/* /usr/local/bin/

创建 bootstrap token 认证文件,apiserver 启动时会调用,然后就相当于在集群内创建了一个这个用户,接下来就可以用 RBAC 给他授权

cd /opt/k8s/

vim token.sh

vim token.sh

#!/bin/bash

#获取随机数前16个字节内容,以十六进制格式输出,并删除其中空格

BOOTSTRAP_TOKEN=$(head -c 16 /dev/urandom | od -An -t x | tr -d ' ')

#生成 token.csv 文件,按照 Token序列号,用户名,UID,用户组 的格式生成

cat > /opt/kubernetes/cfg/token.csv <<EOF

${BOOTSTRAP_TOKEN},kubelet-bootstrap,10001,"system:kubelet-bootstrap"

EOF

chmod +x token.sh

./token.sh

cat /opt/kubernetes/cfg/token.csv

#二进制文件、token、证书都准备好后,开启 apiserver 服务

cd /opt/k8s/

./apiserver.sh 192.168.102.10 https://192.168.102.10:2379,https://192.168.102.30:2379,https://192.168.102.40:2379

#检查进程是否启动成功

ps aux | grep kube-apiserver

netstat -natp | grep 6443 #安全端口6443用于接收HTTPS请求,用于基于Token文件或客户端证书等认证

#启动 scheduler 服务

cd /opt/k8s/

./scheduler.sh

ps aux | grep kube-scheduler

#启动 controller-manager 服务

./controller-manager.sh

ps aux | grep kube-controller-manager

#生成kubectl连接集群的kubeconfig文件

./admin.sh

#绑定默认cluster-admin管理员集群角色,授权kubectl访问集群

kubectl create clusterrolebinding cluster-system-anonymous --clusterrole=cluster-admin --user=system:anonymous

#通过kubectl工具查看当前集群组件状态

kubectl get cs

查看版本信息

kubectl version

五、部署 docker引擎

//所有 node 节点部署docker引擎

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.io

cat > /etc/docker/daemon.json <<EOF

{

"registry-mirrors": ["https://6ijb8ubo.mirror.aliyuncs.com"],

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "500m", "max-file": "3"

}

}

EOF

systemctl start docker.service

systemctl enable docker.service

六、部署 Worker Node 组件

1、在所有 node 节点上操作

#创建kubernetes工作目录

mkdir -p /opt/kubernetes/{bin,cfg,ssl,logs}

#上传 node.zip 到 /opt 目录中,解压 node.zip 压缩包,获得kubelet.sh、proxy.sh

cd /opt/

unzip node.zip

chmod +x kubelet.sh proxy.sh

1、在 master01 节点上操作

#把 kubelet、kube-proxy 拷贝到 node 节点

cd /opt/k8s/kubernetes/server/bin

scp kubelet kube-proxy root@192.168.102.30:/opt/kubernetes/bin/

scp kubelet kube-proxy root@192.168.102.40:/opt/kubernetes/bin/

#上传kubeconfig.sh文件到/opt/k8s/kubeconfig目录中,生成kubelet初次加入集群引导kubeconfig文件和kube-proxy.kubeconfig文件

#kubeconfig 文件包含集群参数(CA 证书、API Server 地址),客户端参数(上面生成的证书和私钥),集群 context 上下文参数(集群名称、用户名)。Kubenetes 组件(如 kubelet、kube-proxy)通过启动时指定不同的 kubeconfig 文件可以切换到不同的集群,连接到 apiserver。

mkdir /opt/k8s/kubeconfig

cd /opt/k8s/kubeconfig

chmod +x kubeconfig.sh

./kubeconfig.sh 192.168.102.10 /opt/k8s/k8s-cert/

#把配置文件 bootstrap.kubeconfig、kube-proxy.kubeconfig 拷贝到 node 节点

scp bootstrap.kubeconfig kube-proxy.kubeconfig root@192.168.102.30:/opt/kubernetes/cfg/

scp bootstrap.kubeconfig kube-proxy.kubeconfig root@192.168.102.40:/opt/kubernetes/cfg/

#RBAC授权,使用户 kubelet-bootstrap 能够有权限发起 CSR 请求证书

kubectl create clusterrolebinding kubelet-bootstrap --clusterrole=system:node-bootstrapper --user=kubelet-bootstrap

2、在 node01 节点上操作

#启动 kubelet 服务

cd /opt/

./kubelet.sh 192.168.102.30

ps aux | grep kubelet

3、在 master01 节点上操作,通过 CSR 请求

kubectl certificate approve node-csr-duiobEzQ0R93HsULoS9NT9JaQylMmid_nBF3Ei3NtFE

kubectl get csr

#查看节点,由于网络插件还没有部署,节点会没有准备就绪 NotReady

kubectl get node

4、在 node01 节点上操作

#加载 ip_vs 模块

for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

#启动proxy服务

cd /opt/

./proxy.sh 192.168.102.30

ps aux | grep kube-proxy

5、自动批准CSR请求

kubectl create clusterrolebinding node-autoapprove-bootstrap --clusterrole=system:certificates.k8s.io:certificatesigningrequests:nodeclient --user=kubelet-bootstrap

kubectl create clusterrolebinding node-autoapprove-certificate-rotation --clusterrole=system:certificates.k8s.io:certificatesigningrequests:selfnodeclient --user=kubelet-bootstrap

使用master进行查看

在主机2也设置一下proxy服务

for i in $(ls /usr/lib/modules/$(uname -r)/kernel/net/netfilter/ipvs|grep -o "^[^.]*");do echo $i; /sbin/modinfo -F filename $i >/dev/null 2>&1 && /sbin/modprobe $i;done

七、部署 CNI 网络组件

K8S 3种网络

节点网络 Node节点网卡的IP nodeIP

Pod网络 podIP

Service网络 clusterIP

K8S 3种接口

CRI 容器运行时接口 docker containerd podman cri-0

CNI 容器网络接口 flannel calico cilium

CSI 容器存储接口 ceph nfs gfs s3

flannel 3种模式

UDP 出现最早,性能较差,基于flanneld应用程序实现数据包的封装/解封装

VXLAN 默认模式,推荐使用的模式,性能比UDP模式更好,基于内核实现数据包的封装/解封装

Host-gw 性能最好,但是配置复杂,不能跨网段

flannel UDP模式工作原理

1)应用数据包从源主机的Pod容器发出到cni0网桥接口,再由cni0转发到flannel0虚拟接口

2)flanneld服务会监听flannel0接口接收到的数据,flanneld服务会将内部数据包封装到UDP报文里

3)flanneld会根据在etcd中维护的路由表查到目标Pod所在的Node节点IP,在UDP报文外再封装Node节点IP报文、MAC报文后,通过物理网卡发送到目标Node节点

4)UDP报文通过8285号端口送到目标主机的flanneld进程进行解封装,再通过flannel0接口转发到cni0网桥,然后通过cni0网桥转发到目标Pod容器

flannel VXLAN模式工作原理

1)原始数据帧从源主机的Pod容器发出到cni0网桥接口,再由cni0转发到flannel.1虚拟接口

2)flannel.1接口接收到数据帧后添加VXLAN头部,在内核封装成UDP报文

3)flanneld会根据在etcd维护的路由表通过物理网卡发送到目标Node节点

4)UDP报文通过8472号端口送到目标主机的flannel.1接口在内核进行解封装,然后将原始报文通过cni0网桥转发到目标Pod容器

Calico IPIP模式工作原理

1)源Pod容器发出的原始数据IP包通过内核的IPIP驱动直接封装到宿主机网络的IP包中

2)根据tunl0接口的路由通过物理网卡发送到目标Node节点

3)数据包到达目标节点后再通过IPIP驱动解包得到原始数据IP包

4)然后通过路由规则发送给 veth pair 设备到达目标Pod容器

Calico BGP模式工作原理(本质就是通过路由表来维护每个 Pod 的通信)

1)源Pod容器发出的原始数据IP包会通过 veth pair 设备到达宿主机网络空间

2)然后根据原始数据IP包的目标IP和宿主机的路由规则,找到目标Node节点的IP,再通过物理网卡发送到目标Node节点

3)根据目标Node节点的路由规则,直接通过目标Pod容器的 veth pair 设备发送到目标Pod容器

flannel 和 calico 区别?

flannel: UDP VXLAN Host-gw

默认网段:10.244.0.0/16

通常使用VXLAN模式,采用的是叠加网络、IP隧道方式传输数据,对性能有一定的影响

功能简单配置方便利于管理,但是不具备复杂的网络策略规则配置能力

calico: IPIP BGP 混合模式(CrossSubnet)

默认网段:192.168.0.0/16

使用IPIP模式可以实现跨子网传输,但是传输过程中需要封包和解包,对性能有一定的影响

使用BPG模式,把Node节点看作成路由器,根据Felix、BIRD分发和维护的路由规则,可直接实现BGP路由转发,传输过程中不需要封包和解包,因此性能较好,但只能在同一个网段内使用,无法跨子网传输

具有更丰富的网络策略配置管理能力、性能更好、功能更全面,但是维护起来较为复杂

所以对于较小规模且网络要求简单的K8S集群,可以采用flannel。对于集群规模较大且要求更多的网络策略配置时,可以采用性能更好、功能全全面的calico

CoreDNS 是 K8S 的默认 DNS 实现

根据 service 资源名称 解析出 Cluster IP

根据 statefulset 控制器创建的 Pod 资源名称 解析出 Pod IP

1、在 node01 节点上操作

#上传 flannel-v0.21.5.zip 到 /opt/k8s 目录中

cd /opt/k8s

unzip flannel-v0.21.5.zip

docker load -i flannel.tar

docker load -i flannel-cni-plugin.tar

#上传 cni-plugins-linux-amd64-v1.3.0.tgz 到 /opt/k8s 目录中

mkdir /opt/cni/bin

tar zxvf cni-plugins-linux-amd64-v1.3.0.tgz -C /opt/cni/bin

2、在node2节点上进行操作

#上传 flannel-v0.21.5.zip 到 /opt/k8s 目录中

cd /opt/k8s

unzip flannel-v0.21.5.zip

docker load -i flannel.tar

docker load -i flannel-cni-plugin.tar

#上传 cni-plugins-linux-amd64-v1.3.0.tgz 到 /opt/k8s 目录中

mkdir /opt/cni/bin

tar zxvf cni-plugins-linux-amd64-v1.3.0.tgz -C /opt/cni/bin

3、在 master01 节点上操作

将生成的kube-flannel.yml 文件传入master节点上

cd /opt/k8s

kubectl apply -f kube-flannel.yml

八、部署 CoreDNS

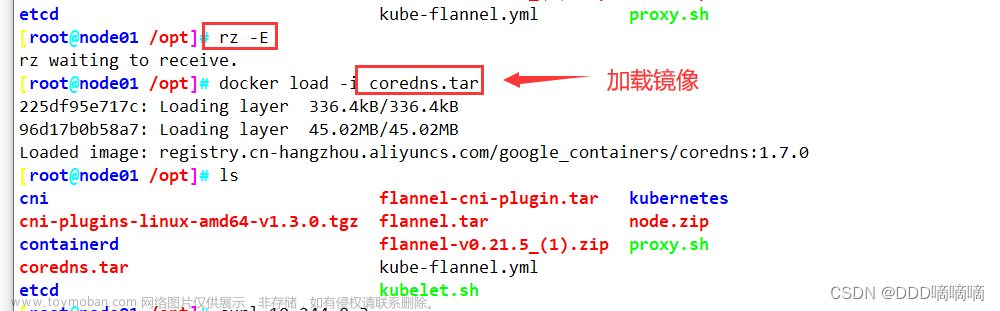

1、在所有 node 节点上操作

#上传 coredns.tar 到 /opt/k8s 目录中

cd /opt/k8s

docker load -i coredns.tar

2、在 master01 节点上操作

#上传 coredns.yaml 文件到 /opt/k8s 目录中,部署 CoreDNS

cd /opt/k8s

kubectl apply -f coredns.yaml

kubectl get pods -n kube-system

kubectl exec -it dns-test sh

3、master02 节点部署

//从 master01 节点上拷贝证书文件、各master组件的配置文件和服务管理文件到 master02 节点

scp -r /opt/etcd/ root@192.168.102.20:/opt/

scp -r /opt/kubernetes/ root@192.168.102.20:/opt

scp /usr/lib/systemd/system/{kube-apiserver,kube-controller-manager,kube-scheduler}.service root@192.168.102.20:/usr/lib/systemd/system/

//修改配置文件kube-apiserver中的IP

vim /opt/kubernetes/cfg/kube-apiserver

//在 master02 节点上启动各服务并设置开机自启

systemctl start kube-apiserver.service

systemctl enable kube-apiserver.service

systemctl start kube-controller-manager.service

systemctl enable kube-controller-manager.service

systemctl start kube-scheduler.service

systemctl enable kube-scheduler.service

//查看node节点状态

ln -s /opt/kubernetes/bin/* /usr/local/bin/

kubectl get nodes

kubectl get nodes -o wide #-o=wide:输出额外信息;对于Pod,将输出Pod所在的Node名

//此时在master02节点查到的node节点状态仅是从etcd查询到的信息,而此时node节点实际上并未与master02节点建立通信连接,因此需要使用一个VIP把node节点与master节点都关联起来

4、负载均衡部署

//配置load balancer集群双机热备负载均衡(nginx实现负载均衡,keepalived实现双机热备)

在lb01、lb02节点上操作

//配置nginx的官方在线yum源,配置本地nginx的yum源

cat > /etc/yum.repos.d/nginx.repo << 'EOF'

[nginx]

name=nginx repo

baseurl=http://nginx.org/packages/centos/7/$basearch/

gpgcheck=0

EOF

yum install nginx -y

1、修改nginx配置文件,配置四层反向代理负载均衡,指定k8s群集2台master的节点ip和6443端口

vim /etc/nginx/nginx.conf

//检查配置文件语法

nginx -t

//启动nginx服务,查看已监听6443端口

systemctl start nginx

systemctl enable nginx

netstat -natp | grep nginx

//部署keepalived服务

yum install keepalived -y

//修改keepalived配置文件

vim /etc/keepalived/keepalived.conf

! Configuration File for keepalived

global_defs {

# 接收邮件地址

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

# 邮件发送地址

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id NGINX_MASTER #lb01节点的为 NGINX_MASTER,lb02节点的为 NGINX_BACKUP

}

#添加一个周期性执行的脚本

vrrp_script check_nginx {

script "/etc/nginx/check_nginx.sh" #指定检查nginx存活的脚本路径

}

vrrp_instance VI_1 {

state MASTER #lb01节点的为 MASTER,lb02节点的为 BACKUP

interface ens33 #指定网卡名称 ens33

virtual_router_id 51 #指定vrid,两个节点要一致

priority 100 #lb01节点的为 100,lb02节点的为 90

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.102.100/24 #指定 VIP

}

track_script {

check_nginx #指定vrrp_script配置的脚本

}

}

//创建nginx状态检查脚本

vim /etc/nginx/check_nginx.sh

#!/bin/bash

#egrep -cv "grep|$$" 用于过滤掉包含grep 或者 $$ 表示的当前Shell进程ID

count=$(ps -ef | grep nginx | egrep -cv "grep|$$")

if [ "$count" -eq 0 ];then

systemctl stop keepalived

fi

chmod +x /etc/nginx/check_nginx.sh

//启动keepalived服务(一定要先启动了nginx服务,再启动keepalived服务)

systemctl start keepalived

systemctl enable keepalived

ip a #查看VIP是否生成

//修改node节点上的bootstrap.kubeconfig,kubelet.kubeconfig配置文件为VIP

cd /opt/kubernetes/cfg/

vim bootstrap.kubeconfig

server: https://192.168.102.100:6443

vim kubelet.kubeconfig

server: https://192.168.80.100:6443

vim kube-proxy.kubeconfig

server: https://192.168.80.100:6443

//重启kubelet和kube-proxy服务

systemctl restart kubelet.service

systemctl restart kube-proxy.service

2、在 master01 节点上操作

//测试创建pod

kubectl run nginx --image=nginx

//查看Pod的状态信息

kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-dbddb74b8-nf9sk 0/1 ContainerCreating 0 33s #正在创建中

kubectl get pods

NAME READY STATUS RESTARTS AGE

nginx-dbddb74b8-nf9sk 1/1 Running 0 80s #创建完成,运行中

kubectl get pods -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

nginx-dbddb74b8-26r9l 1/1 Running 0 10m 172.17.36.2 192.168.80.15 <none>

//READY为1/1,表示这个Pod中有1个容器

//在对应网段的node节点上操作,可以直接使用浏览器或者curl命令访问

curl 10.244.0.3

//这时在master01节点上查看nginx日志,发现没有权限查看

kubectl logs nginx-dbddb74b8-nf9sk

//在对应网段的node节点上操作,可以直接使用浏览器或者curl命令访问

九、部署 Dashboard

Dashboard 介绍

仪表板是基于Web的Kubernetes用户界面。您可以使用仪表板将容器化应用程序部署到Kubernetes集群,对容器化应用程序进行故障排除,并管理集群本身及其伴随资源。您可以使用仪表板来概述群集上运行的应用程序,以及创建或修改单个Kubernetes资源(例如部署,作业,守护进程等)。例如,您可以使用部署向导扩展部署,启动滚动更新,重新启动Pod或部署新应用程序。仪表板还提供有关群集中Kubernetes资源状态以及可能发生的任何错误的信息。

1、在 master01 节点上操作

#上传 recommended.yaml 文件到 /opt/k8s 目录中

cd /opt/k8s

vim recommended.yaml

#默认Dashboard只能集群内部访问,修改Service为NodePort类型,暴露到外部:

kind: Service

apiVersion: v1

metadata:

labels:

k8s-app: kubernetes-dashboard

name: kubernetes-dashboard

namespace: kubernetes-dashboard

spec:

ports:

- port: 443

targetPort: 8443

nodePort: 30001 #添加

type: NodePort #添加

selector:

k8s-app: kubernetes-dashboard

kubectl apply -f recommended.yaml

#创建service account并绑定默认cluster-admin管理员集群角色

kubectl create serviceaccount dashboard-admin -n kube-system

kubectl create clusterrolebinding dashboard-admin --clusterrole=cluster-admin --serviceaccount=kube-system:dashboard-admin

kubectl describe secrets -n kube-system $(kubectl -n kube-system get secret | awk '/dashboard-admin/{print $1}')

登录使用的token 文章来源:https://www.toymoban.com/news/detail-635371.html

文章来源:https://www.toymoban.com/news/detail-635371.html

#使用输出的token登录Dashboard

https://节点ip地址:30001

文章来源地址https://www.toymoban.com/news/detail-635371.html

文章来源地址https://www.toymoban.com/news/detail-635371.html

到了这里,关于【K8S 的二进制搭建】的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!