发生了线上故障,几千万条数据在 MQ 里积压很久。是修复 consumer 的问题,让他恢 复消费速度,然后等待几个小时消费完毕?这是个解决方案。不过有时候我们还会进行临时 紧急扩容。

一个消费者一秒是 1000 条,一秒 3 个消费者是 3000 条,一分钟是 18 万条。1000 多万 条,所以如果积压了几百万到上千万的数据,即使消费者恢复了,也需要大概 1 小时的时间 才能恢复过来。

一般这个时候,只能操作临时紧急扩容了,具体操作步骤和思路如下:

(1)先修复 consumer 的问题,确保其恢复消费速度,然后将现有 consumer 都停掉。

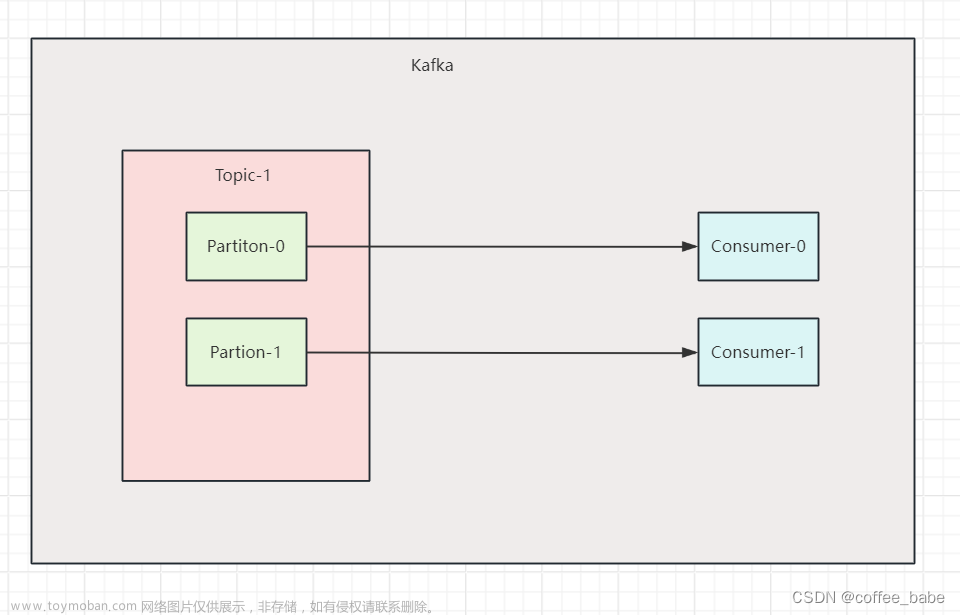

(2)新建一个 topic,partition 是原来的 10 倍,临时建立好原先 10 倍或者 20 倍的 queue 数 量。然后写一个临时的分发数据的 consumer 程序,这个程序部署上去消费积压的数据,消 费之后不做耗时的处理,直接均匀轮询写入临时建立好的 10 倍数量的 queue。

(3)接着临时征用 10 倍的机器来部署 consumer,每一批 consumer 消费一个临时 queue 的 数据。文章来源:https://www.toymoban.com/news/detail-635776.html

这种做法相当于是临时将 queue 资源和 consumer 资源扩大 10 倍,以正常的 10 倍速度 来消费数据。 等快速消费完积压数据之后,再恢复原先部署架构,重新用原先的 consumer 机器来消 费消息。文章来源地址https://www.toymoban.com/news/detail-635776.html

到了这里,关于kafka(五)大数量消息持续积压几个小时如何解决的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!