大论文双盲意见还没回来,每天度日如年,慌的一批,唯恐延毕,得找点事情干~

小论文major revision,本来打算一鼓作气把小论文完全改好的,但是搞了三个月的文字工作,好久没有吸收新知识了

所以…每天边学新东西,边改小论文~

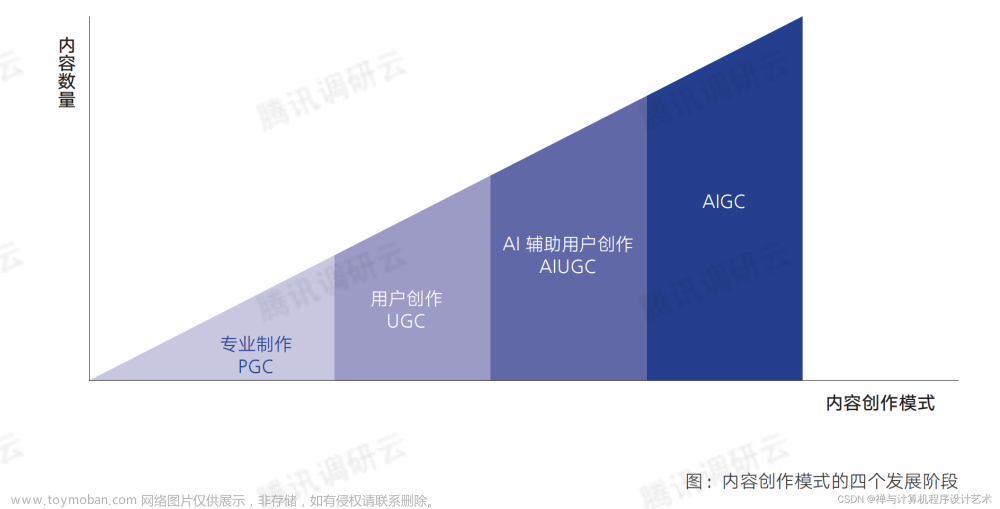

最近AIGC比较火,就从它开始吧

AIGC大致了解

AIGC大致了解:

https://zhuanlan.zhihu.com/p/607822576

AIGC白皮书(2022年)

腾讯 :https://www.aliyundrive.com/s/7qESbn8X5ZU

京东 : https://www.aliyundrive.com/s/gThYTCKfqgw

论文推荐

https://zhuanlan.zhihu.com/p/610435858

一些小工具

https://www.aigc.cn/

AIGC前置知识

Transformer

论文 : https://arxiv.org/abs/1706.03762

- Transformer模型详解(图解最完整版) https://zhuanlan.zhihu.com/p/338817680

引申 :

LayerNorm : https://zhuanlan.zhihu.com/p/54530247

Seq2Seq-- Teacher Forcing : https://zhuanlan.zhihu.com/p/57155059

Vision-Transformer

结论先行:

ViT原论文中最核心的结论是,当拥有足够多的数据进行预训练的时候,ViT的表现就会超过CNN,突破transformer缺少归纳偏置的限制,可以在下游任务中获得较好的迁移效果

知乎 : https://zhuanlan.zhihu.com/p/445122996

BERT

https://www.bilibili.com/read/cv14514000?spm_id_from=333.999.0.0&jump_opus=1

预训练 - 思路来源于CV领域的权重迁移

减少low level的训练

第一个在NLP领域做的很大的网络

GPT系列

https://zhuanlan.zhihu.com/p/125139937

https://zhuanlan.zhihu.com/p/412351920

变分自编码器

VAE https://zhuanlan.zhihu.com/p/563543020

扩散模型

DDPM https://zhuanlan.zhihu.com/p/590840909文章来源:https://www.toymoban.com/news/detail-639180.html

Diffusion https://zhuanlan.zhihu.com/p/599887666文章来源地址https://www.toymoban.com/news/detail-639180.html

到了这里,关于(一) AIGC了解+前置知识的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!