当谈到实时数据处理和流式计算,Apache Flink 是一个备受推崇的工具,它提供了丰富的功能来处理连续的数据流。其中,窗口(Window)是 Flink 中一个关键的概念,它使得我们能够在有限的数据集上执行各种计算和分析操作。本文将深入介绍 Flink 窗口的不同类型、使用方法以及适用场景。

窗口类型

Flink 提供了几种不同类型的窗口,以满足不同的实时数据处理需求:

-

时间窗口(Time Windows):时间窗口根据事件时间或处理时间对数据流进行划分。事件时间是事件实际发生的时间,而处理时间是事件进入 Flink 引擎的时间。时间窗口可以分为固定时间窗口和滑动时间窗口。固定时间窗口将数据流划分为固定长度的时间段,而滑动时间窗口允许窗口之间有重叠,从而更灵活地捕捉数据的变化。

-

计数窗口(Count Windows):计数窗口基于数据的数量对数据流进行划分。当接收到一定数量的数据时,将触发一个新的窗口。计数窗口适用于对数据流的大小进行限制,以便在数据量到达一定阈值时执行聚合操作。

-

会话窗口(Session Windows):会话窗口根据数据之间的时间间隔来划分。当数据之间的时间间隔超过预定义的阈值时,会话窗口会关闭,并将一系列相关的数据放入同一个窗口中。这对于处理间断性的事件流非常有用,如用户在应用中的活动。

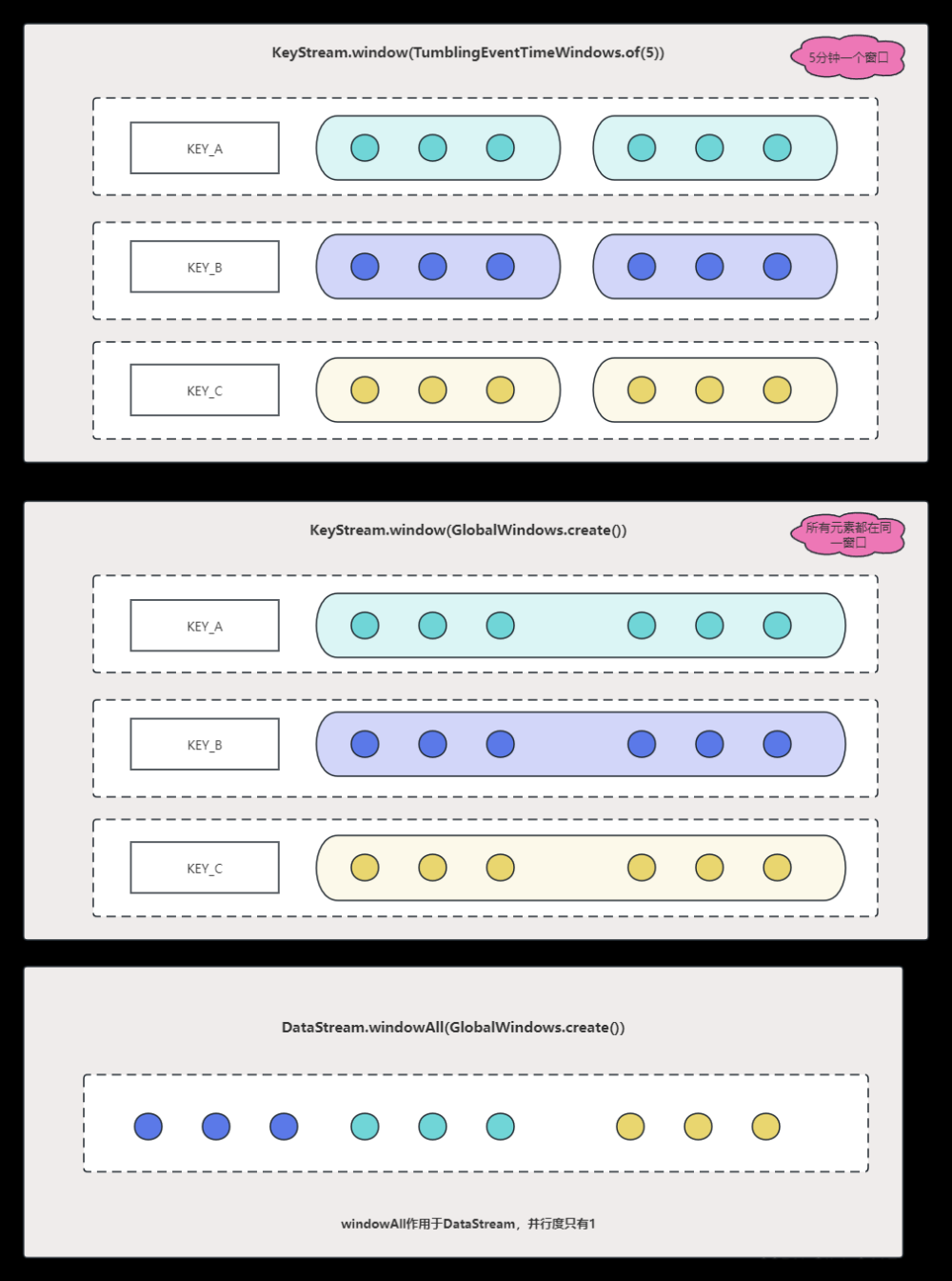

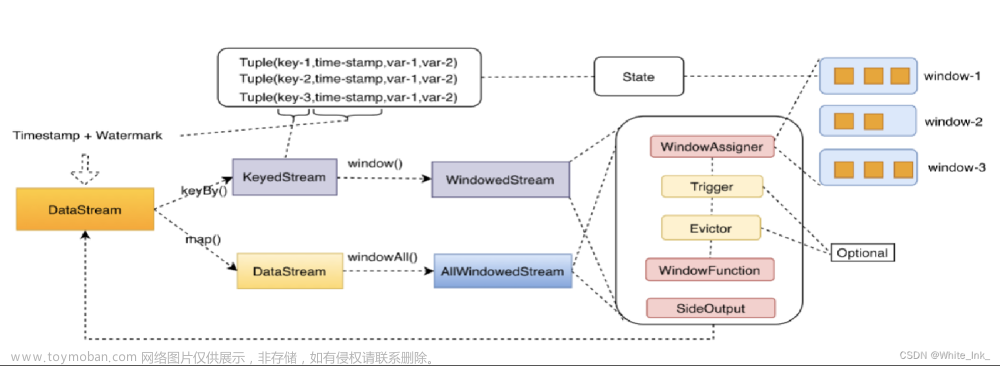

窗口操作流程

使用 Flink 窗口进行实时数据处理通常涉及以下几个步骤:

-

定义数据源:首先,您需要从适合的数据源(例如 Kafka、Kinesis、Socket 等)中读取流式数据。这些数据将成为您处理的基础。

-

应用窗口操作符:在数据流上应用窗口操作符,将数据划分为不同的窗口。窗口操作符需要指定窗口类型(时间窗口、计数窗口等)、窗口长度和滑动步长等参数。

-

定义聚合函数:为每个窗口定义一个聚合函数,该函数将在窗口上执行实际的计算操作。常见的聚合函数包括求和、计数、平均值等。您可以根据业务需求自定义聚合逻辑。

-

执行作业:将窗口操作、聚合函数等组合成 Flink 作业,并将作业提交到 Flink 集群上运行。Flink 会自动管理窗口的创建、关闭以及计算等操作。

使用场景

Flink 窗口适用于许多实时数据处理场景:

-

实时分析与监控:通过时间窗口,您可以实时地对数据流进行聚合和分析,从而实现实时监控和分析。例如,您可以在每个固定时间窗口内计算销售额的平均值,以监控业务的健康状况。

-

异常检测:使用滑动时间窗口,您可以检测数据流中的异常行为。通过计算数据的统计特征,您可以及时发现异常情况,如网络攻击或设备故障。

-

用户行为分析:会话窗口适用于分析用户在应用中的活动。您可以根据用户的活动时间间隔,将相关的活动数据放入同一个窗口中,以便分析用户的行为模式。

-

数据清洗与转换:计数窗口可以用于限制每个窗口内的数据量,从而进行数据清洗或转换操作。例如,您可以在每个计数窗口内对数据进行清洗和格式转换。文章来源:https://www.toymoban.com/news/detail-643618.html

总结

Flink 窗口是实时数据处理中的关键概念,它允许您将数据流划分为有限的数据集,然后在这些数据集上执行各种计算和分析操作。不同类型的窗口适用于不同的实时数据处理需求,包括时间窗口、计数窗口和会话窗口等。通过合理地应用窗口操作符和聚合函数,您可以轻松实现实时分析、监控、异常检测等功能,为您的业务提供有价值的见解。无论您是处理大规模实时数据还是简单的数据流,Flink 窗口都是一个强大的工具,可以助您轻松应对各种数据处理挑战。文章来源地址https://www.toymoban.com/news/detail-643618.html

到了这里,关于Flink-Window详细讲解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!