在数字化时代,数据成为了企业决策的关键支持。然而,随着数据不断增长,有效地管理和利用这些数据变得至关重要。数据仓库和ETL工具作为数据管理和分析的核心,将帮助企业从庞杂的数据中提取有价值信息。

一、ETL是什么?

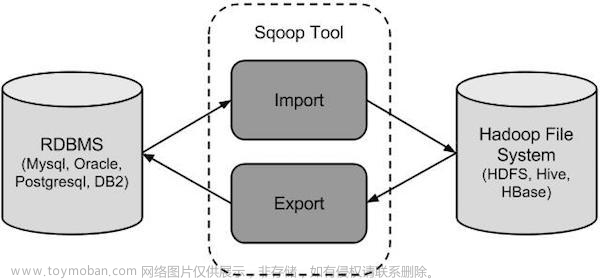

ETL代表“Extract, Transform, Load”,是一种用于数据集成和转换的过程。它在数据管理和分析中扮演着重要的角色。下面我们将分解每个步骤:

Extract(抽取): 这一步骤涉及从多个不同的数据源中提取数据,这些源可以是数据库、文件、API、日志文件等等。数据通常以原始的、未经处理的形式抽取出来。

Transform(转换): 在这一阶段,数据被清洗、转换和重新格式化,以使其适合目标数据仓库的结构和需求。这可能包括数据清理、重命名列、数据类型转换、去重、合并数据等操作。

Load(加载): 在此步骤中,经过转换后的数据被加载到目标数据仓库中。这可以是关系型数据库、数据湖、数据仓库或其他存储位置。加载过程应该经过有效的优化,以确保数据的一致性和可查询性。

二、数据仓库为什么需要ETL?

数据仓库是一个集成、存储和管理企业数据的中央存储库。数仓提供了一个统一的数据视图,有助于企业更好地理解业务情况,做出更明智的决策。然而,企业中的数据通常分布在不同的系统中,这就需要ETL来进行集成和转换,以便将数据整合到数据仓库中。

数据清洗与一致性

从不同源抽取的数据可能存在格式不一致、数据类型不匹配、缺失值等问题。ETL可以进行数据清洗和转换,确保数据一致性,以便在数据仓库中进行准确的分析。

数据整合与分析

企业可能有来自多个部门或业务领域的数据,这些数据通常存在不同的格式和结构。ETL可以将这些异构的数据整合到一个一致的模型中,为分析和报告提供统一的基础。

性能优化与查询效率

数据仓库需要经过优化的数据模型,以支持快速和高效的查询。ETL可以对数据进行预聚合、索引建立、分区等操作,提高数据仓库的查询性能。

历史数据与变化追踪

ETL可以支持历史数据的加载和追踪变化。这对于分析趋势、历史变化和预测等任务非常重要。

数据安全与合规性

在数据仓库中,敏感数据可能需要进行掩码、加密等处理,以保护隐私和确保合规性。ETL可以在数据加载前进行这些处理。

三、ETL未来发展方向

自动化和智能化:未来,ETL的未来发展方向将更加注重自动化和智能化。随着人工智能和机器学习的不断进步,ETL工具和平台将具备更强大的自动化能力,能够自动发现数据源、提取数据,并根据规则和模式进行数据转换和加载。这将大大减少人工干预的需求,提高数据处理的效率和准确性。

实时数据处理:随着业务需求的不断增长,对实时数据的需求也越来越迫切。未来的ETL将更加注重实时数据处理能力,能够对流式数据进行实时抽取、转换和加载,使得企业和个人能够及时获得最新的数据洞察,并做出实时决策。

数据安全与隐私保护:随着数据泄露和隐私问题的日益严重,未来的ETL将更加关注数据安全和隐私保护。ETL工具和平台将加强数据加密、访问控制和匿名化等技术手段,确保数据在抽取、转换和加载的过程中得到充分的保护,同时遵守相关的法规和隐私规范。

云原生和分布式处理:随着云计算和大数据技术的发展,未来的ETL将更多地采用云原生架构和分布式处理模式。通过利用云平台的弹性扩展和分布式计算的能力,ETL可以更好地应对大规模数据处理的挑战,并提供高可用性和高性能的数据处理服务。

四、常见ETL有那些工具可以免费使用?

Apache NiFi:Apache NiFi是一个开源的数据集成工具,提供了可视化的界面和强大的数据流处理功能。它支持实时数据流和批量数据处理,并具有丰富的数据转换和加载能力。

Pentaho Data Integration(Kettle):Pentaho Data Integration,也被称为Kettle,是一个开源的ETL工具。它提供了可视化的开发环境和大量的数据集成和转换组件,支持多种数据源和目标系统。

Talend Open Studio:Talend Open Studio是Talend公司提供的免费开源的ETL工具。它提供了可视化的开发环境和广泛的数据集成和转换功能,适用于各种数据集成项目。

ETLCloud:ETLCloud是一款国产免费的ETL工具,提供了全WEB可视化的开发环境和灵活的数据处理功能,它支持离线和实时数据集成,并具备超过200+的数据处理组件,支持各种主流数据源以及SaaS应用数据的抽取。

DataX: DataX是一个强大且灵活的开源数据集成工具,由阿里巴巴集团开发。它专注于数据抽取,能够高效地从各种数据源中提取数据并加载到目标系统。DataX的插件机制使其适用于多种数据源和目标,具备很强的适应性。

五、ETL主要是通过可视化流程来描述数据清洗和转换过程

文章来源:https://www.toymoban.com/news/detail-643880.html

文章来源:https://www.toymoban.com/news/detail-643880.html

(以上是ETLCloud的数据清洗和转换流程图示例)文章来源地址https://www.toymoban.com/news/detail-643880.html

到了这里,关于大数据扫盲(1): 数据仓库与ETL的关系及ETL工具推荐的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!