4月官宣创业,6月15日发布第一款7B开源模型,7月11日发布第二款13B、130亿参数开源模型。

平均保持2个月一个版本发布速度,8月8日,百川智能发布了创业以来的首个530亿参数闭源大模型——Baichuan-53B(以下简称“53B”)。

光锥智能获悉,53B支持中英双语,在知识性上表现优异,譬如能给孩子取名字和解读其背后的寓意,擅长知识问答、文本创作等领域,相对此前两款模型有了更好的表现。

目前53B已在官网开放内测申请,并将在下个月开放API。

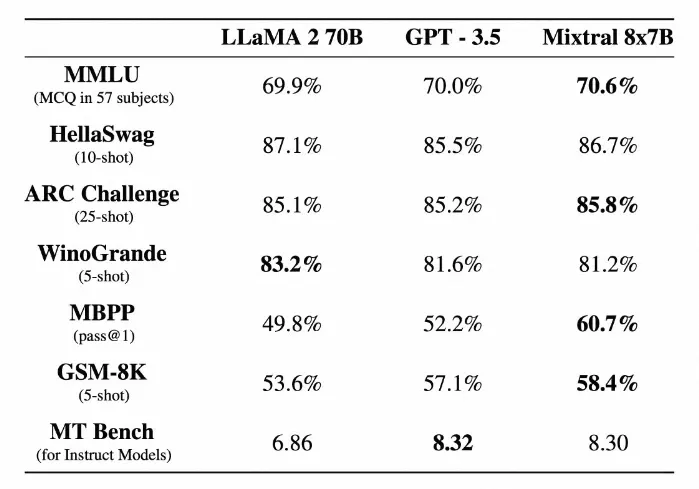

按照计划,今年四季度,百川智能将发布千亿参数的大模型,预计将追上GPT-3.5的水平,其开源模型也将在今年内发布升级版本。

百川智能已经发布的开源大模型在各个榜单收获了不错的评分,并且能被企业真正用起来,据百川智能统计,已经有150家以上的公司申请使用他们的开源模型。

谈起这回发布闭源大模型的原因,王小川表示因为模型变大后,部署起来成本比较高,所以才更多走闭源让大家网上调用的方式。

王小川认为闭源可以提供更简单的接口,做调用后指令的精准度方面会更好,也能解决一些更复杂的问题。

“开源和闭源并不矛盾,不管是 7B 还是 13B,还是 53B,都是为ToB行业服务做准备。我们更关心的是2C怎么做,2B怎么做,而不是把问题停留在开源闭源里面。”王小川道。

此次发布的53B可谓是集大成之作,百川智能强调53B的三个技术优势分别为预训练数据、搜索增强和对齐能力,其中前两者与百川团队中丰富的搜索引擎经验有较强相关性。

预训练数据方面,王小川表示,此前团队做搜索引擎的经验,让百川智能能够又快又好地完成前期数据积累,这也是百川智能此前两款开源模型能够迅速推出的原因之一。

百川智能联合创始人、大语言模型技术负责人陈炜鹏表示:“团队背景做了很多年的搜索,所以整个中文互联网里哪里有好的数据,我们团队是最清楚的,同时怎么把这些数据收集回来,质量做好,识别出来,我们以前有也很强的积累和方法论。”

预训练数据是大语言模型信息和知识的来源,丰富多样、高质量、有层次的数据对模型的最终效果起到关键作用。其中,数据质量是预训练模型的关键。为此,百川智能已经建立了一套系统的数据质量体系,包括低质、优质、类别等,这一体系将确保其在整个预训练过程中维持高标准的数据质量,确保数据能为最终模型训练的目标服务。

百川智能表示,未来的目标是构建一个全面的世界知识体系,使其能够覆盖各个领域和学科的知识。通过整合各类信息源,确保在文化、科学、技术等方面有广泛的知识涵盖,打造一个不断学习、扩展和更新的知识库,确保所有信息的准确性和时效性,以满足不同用户的多样化需求。

王小川认为,过去20年搜索技术的积累是百川在大模型领域的优势。

在具体技术实现路径上,百川智能的搜索增强系统融合了多个模块,包括指令意图理解、智能搜索和结果增强等关键组件。这一综合体系通过深入理解用户指令,精确驱动查询词的搜索,并结合大语言模型技术来优化模型结果生成的可靠性。通过这一系列协同作用,实现了更精确、更智能的模型结果回答,减少了模型的幻觉。

“搜索增强是非常重要的事情,通过它可以使得知识面更加扩大,幻觉问题、时效性的问题也能得到更好的弥补,因此以后搜索引擎会成为我们的亮点和特色,要把搜索的模型完美融合成一件事情。”王小川道。

除了预训练,大模型还需要通过对齐调整(Alignment Tuning)让模型同人类价值观对齐,从而生成“更令人满意”的回复内容。

为了提升安全性和帮助性效果,53B采用了多RM融合,这是一种全面的策略,它着眼于不同目标间的相互支持和平衡,确保在实现一个目标的同时,不会牺牲其他重要目标。这意味着,即使用户同时有多项复杂需求时,模型也不会忽略安全等最基本诉求。

王小川认为大模型的事业才刚刚到了爬坡阶段,对于模型而言,有三点很重要:一是大模型本身的能力,尤其指的是预训练的能力;二是搜索的能力;三是强化的能力,三者共同推动大模型的进步。

展望大模型发展的未来,王小川认为既能做500亿参数,也要有自身差异化,才是百川智能接下来要走的路。文章来源:https://www.toymoban.com/news/detail-644256.html

“要做到中国最好的对标GPT模型,预训练模型的追求没法停下来,未来还会继续去做更大的模型。但这也同时意味着,百川智能对于搜索和强化技术也会有自己的高度。”王小川道。文章来源地址https://www.toymoban.com/news/detail-644256.html

到了这里,关于百川智能发布首个530亿参数闭源大模型,今年追上GPT-3.5的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!