更新:2023-08-13 15:30

想要获取网站的数据?使用Python爬虫是一个绝佳的选择。Python爬虫是通过自动化程序来提取互联网上的信息。本文章将会详细介绍Python爬虫的相关技术。

一、网络协议和请求

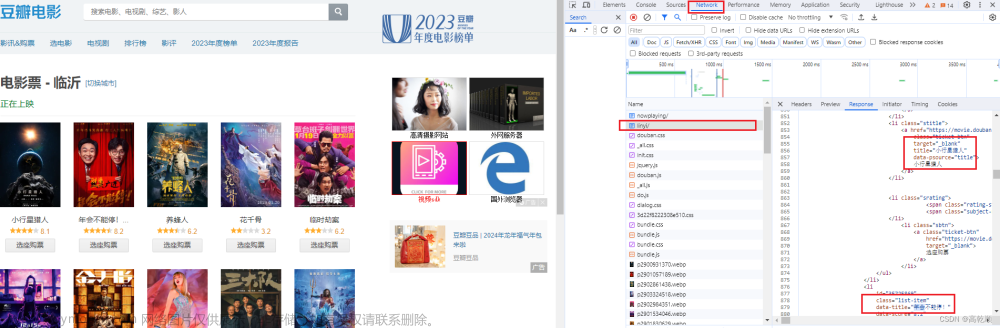

在使用Python爬虫之前,我们需要理解网络协议和请求。HTTP是网络传输的重要协议,它是在Web浏览器和Web服务器之间传递Web页面或数据的协议。Python提供了许多HTTP请求库,其中最流行的是requests。

使用requests库发送HTTP请求,可以获取HTTP响应的状态码、响应头和响应正文。

import requests

url = 'https://www.baidu.com'

response = requests.get(url)

print(response.status_code)

print(response.headers)

print(response.content)二、解析HTML

使用Python爬虫,我们需要从网页中获取所需的数据。HTML是网页的标记语言,我们可以使用BeautifulSoup库来解析HTML。

from bs4 import BeautifulSoup

import requests

url = 'https://www.baidu.com'

response = requests.get(url)

soup = BeautifulSoup(response.content, 'html.parser')

print(soup.title.string)三、解析JSON

大多数API返回的是JSON格式,我们需要了解如何使用Python解析它。Python提供了内置模块json来处理JSON格式数据。

import requests

import json

url = 'https://api.github.com/users/octocat'

response = requests.get(url)

json_data = json.loads(response.text)

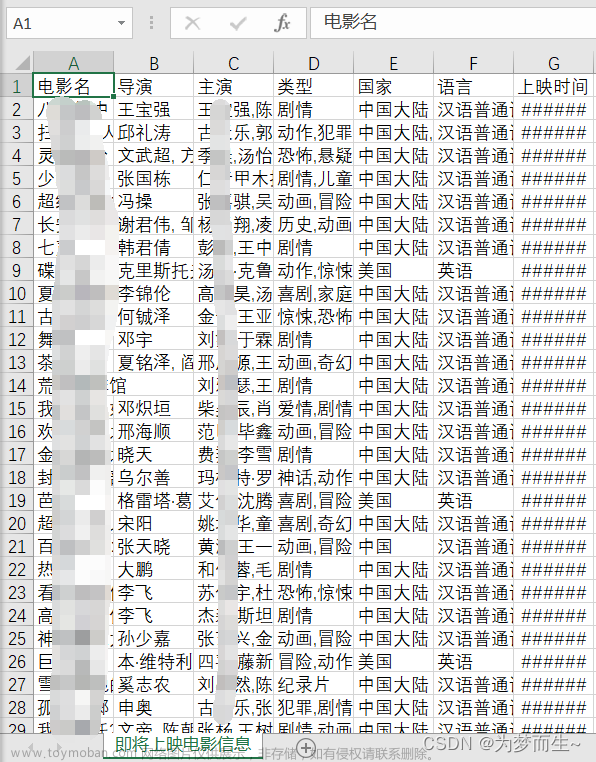

print(json_data['name'])四、获取数据并保存到文件

我们可以通过使用Python爬虫自动获取数据并将其保存到本地文件中。Python中提供了内置模块os和shutil,可以在本地文件系统中执行文件和文件夹的操作。以下是将获取的HTML保存为文件的示例:

import os

import shutil

import requests

url = 'https://www.baidu.com'

response = requests.get(url)

with open('baidu.html', 'wb') as f:

f.write(response.content)

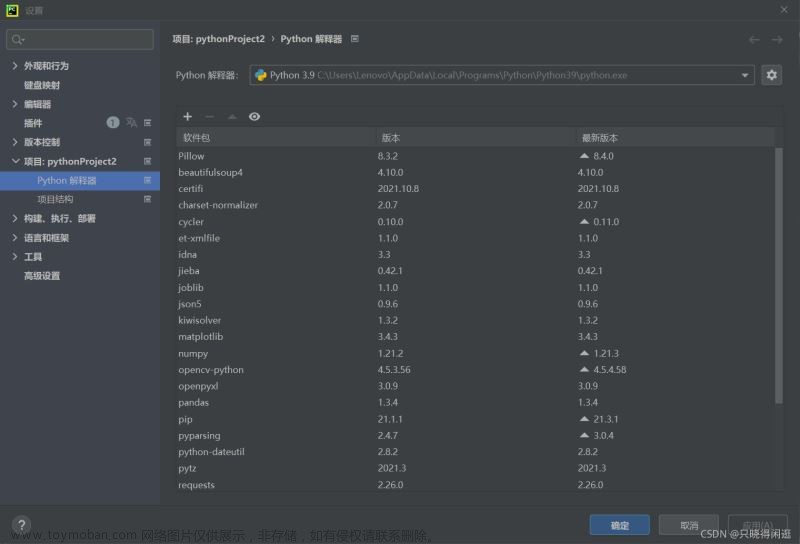

shutil.move('baidu.html', os.getcwd() + '/data')五、使用代理

在使用Python爬虫时,有时会需要使用代理。这是由于某些网站会对频繁访问的IP地址进行限制。可以使用Python中的requests库来设置代理。

import requests

proxy = {

"http": "http://127.0.0.1:8888",

"https": "https://127.0.0.1:8888"

}

url = 'https://www.baidu.com'

response = requests.get(url, proxies=proxy)六、使用Selenium

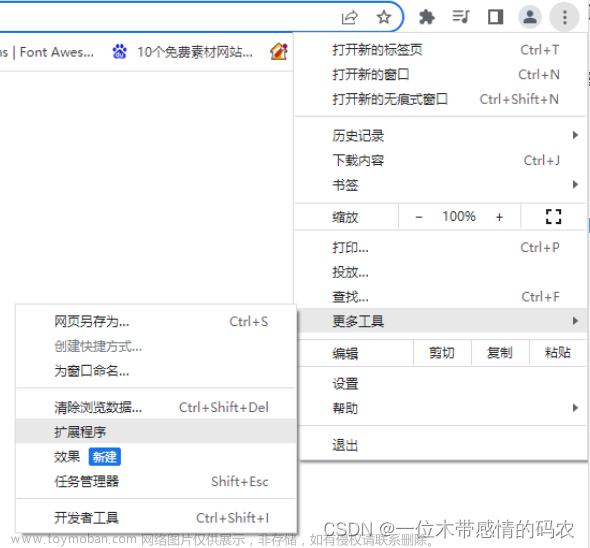

在一些需要模拟人类操作的情况下,使用Selenium是一个不错的选择。它可以自动化网页上的操作,例如填写表单、点击按钮等。文章来源:https://www.toymoban.com/news/detail-645641.html

from selenium import webdriver

driver = webdriver.Firefox()

driver.get('https://www.baidu.com')

search_box = driver.find_element_by_name('wd')

search_box.send_keys('Python')

search_box.submit()文章来源地址https://www.toymoban.com/news/detail-645641.html

到了这里,关于Python爬虫:如何使用Python爬取网站数据的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!