什么是计算图?

计算图是一种数据结构,用于表示计算过程。具体来说,计算图是一组节点和边组成的图,其中节点表示计算单元(如矩阵乘法、加法等),边表示数据流动(即数据在计算单元之间的传递)。

在深度学习中,计算图用于表示神经网络的计算过程,可以帮助我们更好地理解和调试网络。在 TensorFlow、PyTorch 等深度学习框架中都使用了计算图,可以通过它来构建、训练和评估神经网络。

使用计算图的优势在于,它可以在运行时动态地构建和修改计算过程,并且可以利用硬件加速(如 GPU)来提高计算效率。

总结:计算图是一种数据结构,用于表示计算过程,在深度学习中被广泛使用,帮助我们更好地理解和调试网络。

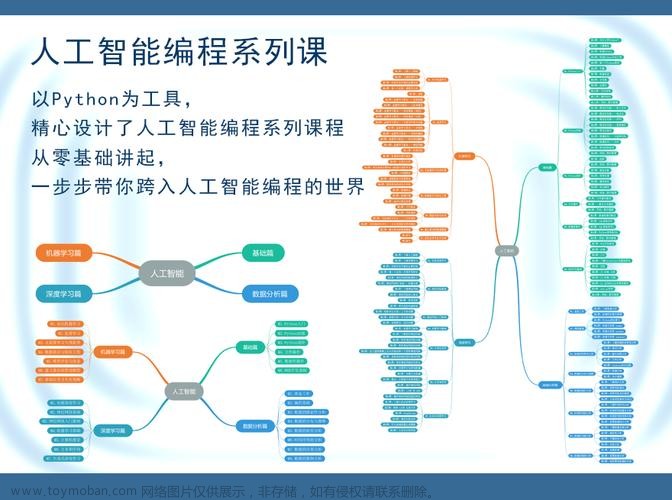

如何学习计算图?

学习计算图可以通过以下几个步骤来实现:

- 了解基本概念: 学习计算图的基本概念, 如节点、边、图、拓扑结构等.

- 使用深度学习框架: 学习使用 TensorFlow、PyTorch 等深度学习框架来构建和使用计算图.

- 学习计算图的基本操作: 学习如何在计算图中添加节点、边和操作,以及如何运行计算图.

- 练习和实践: 通过练习和实践来加深对计算图的理解和掌握.

- 阅读相关文献: 阅读关于计算图的相关文献, 了解其最新发展和应用.

有很多的资源可以帮助你学习计算图, 包括在线教程、书籍、论文和项目。使用深度学习框架(如TensorFlow、Pytorch等)时,还可以使用官方文档来学习相关知识。

计算图的基本概念介绍

计算图是一种用来表示计算过程的数据结构。它通常由节点和边组成。

- 节点(Node): 表示计算单元,如矩阵乘法、加法等。

- 边(Edge): 表示数据流动,即数据在计算单元之间的传递。

- 图(Graph): 表示整个计算过程,由节点和边组成。

- 拓扑结构(Topological Structure):计算图中节点之间的结构关系。

计算图中的节点可以分为两类:

- 输入节点(Input Node): 表示输入数据,如训练集中的图像.

- 输出节点(Output Node): 表示输出结果,如识别后的文字.

计算图具有动态性,可以在运行时动态地构建和修改计算过程。在深度学习中,计算图被广泛用于表示神经网络的计算过程,帮助我们更好地理解和调试网络。

计算图的简单实例

下面是一个使用 TensorFlow 构建计算图的简单实例:

import tensorflow as tf

# Create a constant node with value 2

a = tf.constant(2, name='a')

# Create a constant node with value 3

b = tf.constant(3, name='b')

# Create a new node to perform the addition operation

c = tf.add(a, b, name='c')

# Create a session to run the graph

with tf.Session() as sess:

result = sess.run(c)

print("Result:", result)

这个示例中,我们创建了两个常量节点 a 和 b,分别表示 2 和 3。然后使用这两个常量节点创建了一个新节点 c,表示 a+b的值,最后通过Session.run()函数来运行计算

计算图的复杂实例

下面是一个使用 TensorFlow 构建更复杂的计算图的示例,它实现了一个简单的卷积神经网络模型:

import tensorflow as tf

# Create placeholders for the input and output data

x = tf.placeholder(tf.float32, shape=(None, 28, 28, 1), name='x')

y = tf.placeholder(tf.float32, shape=(None, 10), name='y')

# Create a convolutional layer with 32 filters and a kernel size of 3x3

conv1 = tf.layers.conv2d(x, 32, 3, activation=tf.nn.relu, name='conv1')

# Create a max pooling layer with a pool size of 2x2

pool1 = tf.layers.max_pooling2d(conv1, 2, 2, name='pool1')

# Create a convolutional layer with 64 filters and a kernel size of 3x3

conv2 = tf.layers.conv2d(pool1, 64, 3, activation=tf.nn.relu, name='conv2')

# Create a max pooling layer with a pool size of 2x2

pool2 = tf.layers.max_pooling2d(conv2, 2, 2, name='pool2')

# Flatten the feature maps

flatten = tf.layers.flatten(pool2, name='flatten')

# Create a fully connected layer with 128 units and ReLU activation

fc1 = tf.layers.dense(flatten, 128, activation=tf.nn.relu, name='fc1')

# Create a dropout layer with a dropout rate of 0.5

dropout = tf.layers.dropout(fc1, rate=0.5, name='dropout')

# Create a fully connected layer with 10 units and softmax activation

logits = tf.layers.dense(dropout, 10, activation=tf.nn.softmax, name='logits')

# Define the loss function and the optimizer

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits_v2(logits=logits, labels=y))

optimizer = tf.train.AdamOptimizer().minimize(loss)

这个示例中,我们使用了卷积层、最大池化层、全连接层、Dropout层等组成了一个简单的卷积神经网络模型,并使用了Adam优化器来优化损失函数。文章来源:https://www.toymoban.com/news/detail-645950.html

简单介绍如下:文章来源地址https://www.toymoban.com/news/detail-645950.html

- 首先,我们使用 TensorFlow 的 placeholder 函数创建了两个占位符节点 x 和 y,用于存储输入和输出数据。

- 接下来,我们使用了 tf.layers.conv2d 函数创建了两个卷积层 conv1 和 conv2。这两个卷积层分别使用了 32 个滤波器和 64 个滤波器,滤波器大小都是 3x3。

- 接着,我们使用了 tf.layers.max_pooling2d 函数创建了两个最大池化层 pool1 和 pool2。这两个最大池化层分别使用了池化大小为 2x2。

- 接下来,我们使用了 tf.layers.flatten 函数把特征映射展平。

- 然后,我们使用了tf.layers.dense 函数创建了一个全连接层 fc1。

- 接着,我们使用了tf.layers.dropout 函数创建了一个Dropout层。

- 最后,我们使用了tf.layers.dense 函数创建了一个全连接层 logits,并使用softmax激活函数。

- 然后我们使用了tf.reduce_mean函数定义了损失函数,并使用Adam优化器来优化损失函数。

到了这里,关于计算图简单介绍的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!