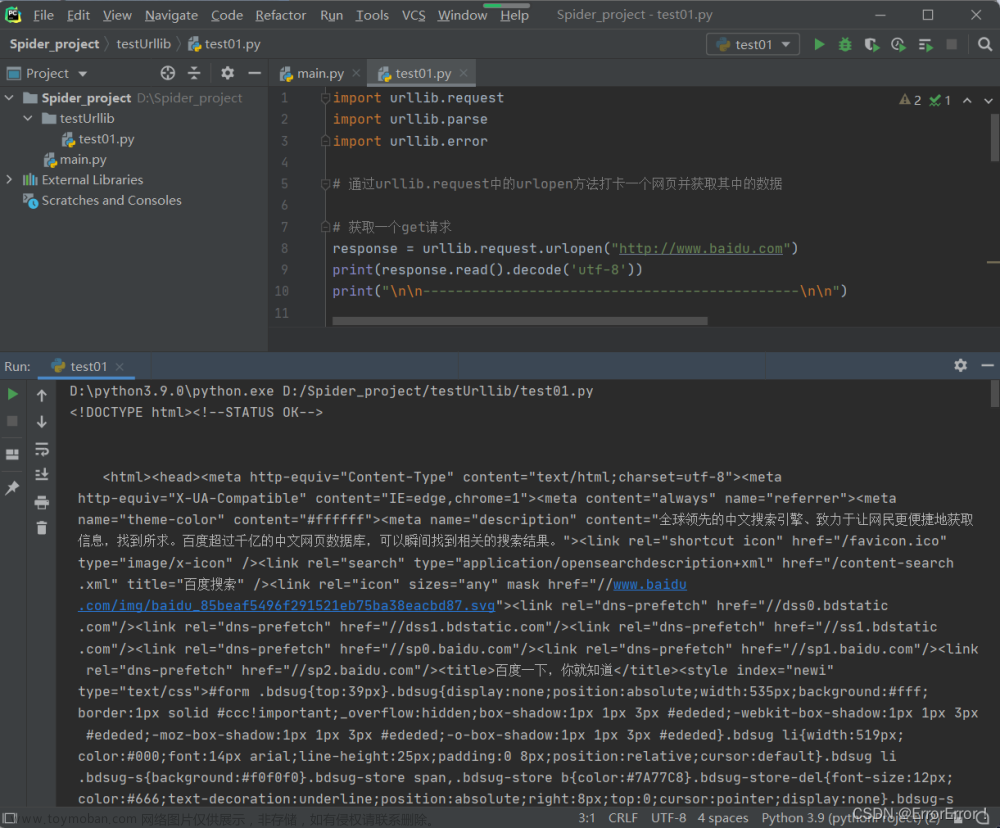

import requests

# ?可加可不加

url = 'http://www.baidu.com/s?'

headers = {

'Cookie': '',

'User-Agent': '',

}

data = {

'wd': '北京'

}

# params 参数

response = requests.get(url=url, params=data, headers=headers)

content = response.text

print(content)

总结:文章来源地址https://www.toymoban.com/news/detail-646236.html

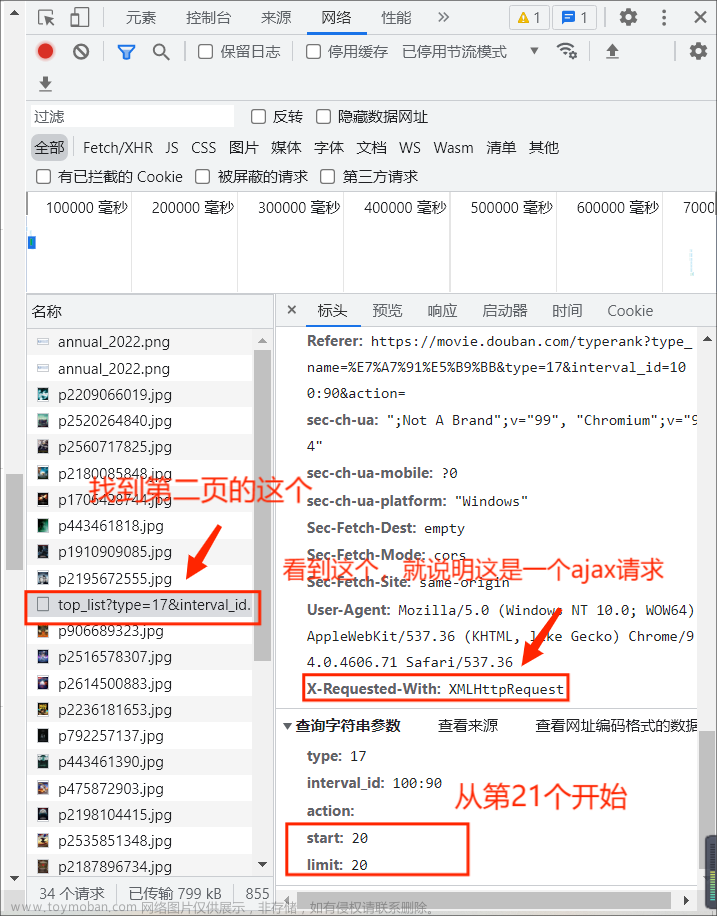

- 参数使用params传递

- 参数无需重新编码

- 不需要请求对象定制

- 请求资源路径中的?可加也可不加

文章来源:https://www.toymoban.com/news/detail-646236.html

到了这里,关于Python爬虫——requests_get请求的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!