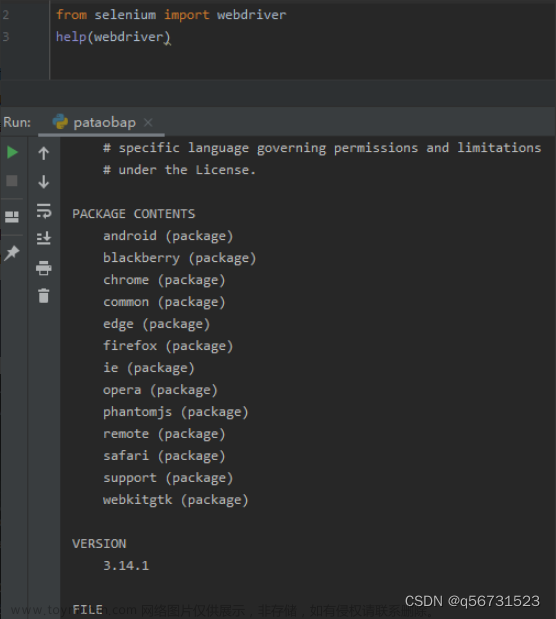

from selenium import webdriver

# 创建浏览器对象

path = 'files/chromedriver.exe'

browser = webdriver.Chrome(path)

# 访问地址

url = 'https://www.baidu.com'

browser.get(url)

input = browser.find_element_by_id('su')

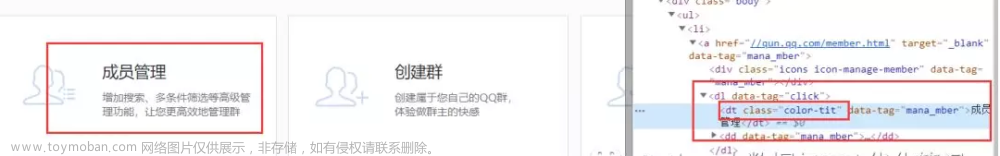

- 获取元素属性

.get_attribute('class')

print(input.get_attribute('class'))

- 获取标签名

.tag_name

print(input.tag_name)

- 获取元素文本

.text

a = browser.find_element_by_link_text('hao123')

print(a.text)

文章来源地址https://www.toymoban.com/news/detail-646767.html

文章来源:https://www.toymoban.com/news/detail-646767.html

到了这里,关于Python爬虫——selenium_访问元素信息的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!