前言

在讲解cuda和cuDNN之前,我们首先来了解一下英伟达(NVIDA)公司。

NVIDIA是一家全球领先的计算机技术公司,专注于图形处理器(GPU)和人工智能(AI)计算。公司成立于1993年,总部位于美国加利福尼亚州的圣塔克拉拉。NVIDIA的产品和技术广泛应用于各个领域,包括游戏、虚拟现实、自动驾驶、数据中心、边缘计算等。

作为全球最为知名的GPU制造商之一,NVIDIA的图形处理器技术推动了计算机图形学和游戏行业的发展。同时,由于其并行计算能力优势,NVIDIA的GPU也被广泛应用于科学计算、深度学习和人工智能领域。其旗舰级GPU产品线包括GeForce用于游戏玩家、Quadro用于专业工作站和数据科学家、Tesla用于高性能计算等。

NVIDIA还推出了一系列的软件开发工具和库,为开发者提供了丰富的工具和支持,加速了人工智能应用的开发和部署过程。其中最著名的是CUDA平台,它为开发者提供了在GPU上进行高性能计算的编程模型和工具。

通过持续的创新和技术领导地位,NVIDIA在计算机行业取得了巨大成功,并为人工智能和高性能计算等领域的发展做出了重要贡献。

一、CUDA

官网地址:https://developer.nvidia.com/cuda-toolkit

CUDA(Compute Unified Device Architecture)是由NVIDIA开发的并行计算平台和编程模型,用于利用NVIDIA GPU(Graphics Processing Unit)进行通用目的计算(GPGPU)。它是一种为GPU编程提供高性能和易用性的软件环境。

CUDA的主要目标是将GPU作为计算加速设备,用于执行并行计算任务,特别是科学计算和深度学习等领域。它通过提供一套编程接口(API)和工具集,使开发者能够利用GPU的大规模并行计算能力,以加速计算密集型任务。

使用CUDA,开发者可以使用编程语言如C/C++、Python等来编写GPU加速的程序。CUDA提供了一系列库和工具,如CUDA Runtime库、CUDA Tools(如nvcc编译器)和NVIDIA Nsight开发环境,用于编译、调试和优化CUDA程序。

CUDA的优势在于其紧密结合了NVIDIA GPU的体系结构特点,可对任务进行细粒度的并行处理,并利用GPU上的数百到数千个核心同时执行计算任务。这使得CUDA成为目前广泛应用于科学计算、数值模拟、深度学习等领域的GPU编程平台。

值得注意的是,对于使用CUDA进行开发的程序,其执行的硬件需求需要是支持CUDA的NVIDIA GPU,并且需要安装相应的CUDA驱动程序和运行时库。

二、cuDNN

官网地址:https://developer.nvidia.com/cudnn

cuDNN(CUDA Deep Neural Network)是由NVIDIA开发的深度神经网络(DNN)加速库,专门用于在CUDA平台上进行深度学习任务的加速。

cuDNN提供了高度优化的DNN(深度神经网络)基础操作和算法实现,如卷积、池化、归一化、激活函数等,以及自动求导和张量操作等。它利用了NVIDIA GPU的并行计算能力和高度可编程的架构,提供了高性能的DNN计算和训练加速。

通过使用cuDNN,深度学习框架(如TensorFlow、PyTorch等)可以利用其提供的GPU加速功能,加快训练和推理的速度。cuDNN库实现了高效的卷积计算和其他操作,优化了计算过程和内存使用,以最大化GPU的利用率和性能。

cuDNN还提供了一些高级功能,如自动调整算法的性能和内存使用、混合精度计算等,以进一步提高深度学习任务的效率和性能。

一句话说明,cuDNN是NVIDIA为深度学习开发者提供的一个重要工具,它通过高度优化的DNN操作和算法实现,使得深度学习框架能够更有效地利用CUDA和NVIDIA GPU的性能,加速深度学习任务的执行。

它的主要特性如下:

- 为各种常用卷积实现了 Tensor Core 加速,包括 2D 卷积、3D 卷积、分组卷积、深度可分离卷积以及包含 NHWC 和 NCHW 输入及输出的扩张卷积

- 为诸多计算机视觉和语音模型优化了内核,包括 ResNet、ResNext、EfficientNet、EfficientDet、SSD、MaskRCNN、Unet、VNet、BERT、GPT-2、Tacotron2 和 WaveGlow

- 支持 FP32、FP16、BF16 和 TF32 浮点格式以及 INT8 和 UINT8 整数格式

- 4D 张量的任意维排序、跨步和子区域意味着可轻松集成到任意神经网络实现中

- 能为各种 CNN 体系架构上的融合运算提速

注意:在数据中心和移动 GPU 中采用 Ampere、Turing、Volta、Pascal、Maxwell 和 Kepler GPU 体系架构的 Windows 和 Linux 系统均支持 cuDNN。

三、Pytorch

官网地址:https://pytorch.org/

PyTorch是一个基于Python的开源机器学习框架,专注于深度学习任务。它由Facebook的人工智能研究团队开发并维护,提供了丰富的工具和接口,使得在Python环境下进行深度学习任务的开发和实验变得更加简单和灵活。

PyTorch以其动态计算图的特点而闻名,这意味着开发者可以以类似于标准Python编程的方式定义和调整计算图,而不需要事先编写静态图。这使得PyTorch具有灵活性和直观性,方便调试和迭代模型设计。

PyTorch提供了丰富的功能和组件,包括:

-

强大的张量操作:PyTorch提供了类似于NumPy的张量操作接口,并且在GPU上具备加速功能。

-

自动求导:PyTorch的自动求导功能使得开发者可以方便地计算张量操作的梯度,并用于反向传播和模型优化。

-

高效的神经网络模块:PyTorch提供了用于构建神经网络模型的模块,如各种层、损失函数等。

-

多种优化器:PyTorch支持各种优化算法的实现,如随机梯度下降(SGD)、Adam等。

-

训练和模型保存:PyTorch提供了方便的训练和验证接口,并支持将训练好的模型保存和加载。

PyTorch的生态系统非常活跃,有大量的社区贡献,提供了丰富的预训练模型和扩展库,方便开发者进行各种深度学习任务。同时,由于其易用性和灵活性,PyTorch在学术界和工业界都得到了广泛的应用和采用。文章来源:https://www.toymoban.com/news/detail-648540.html

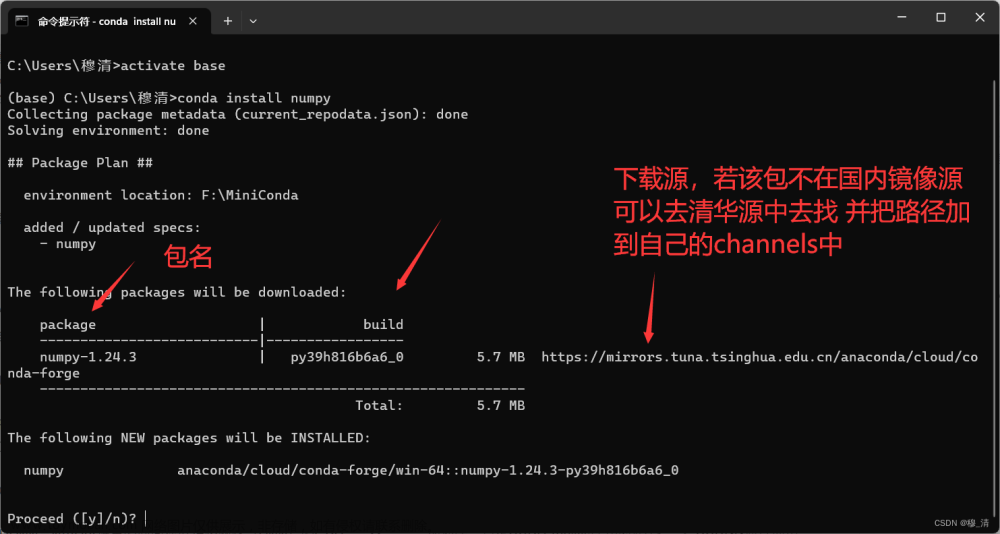

⭐️ 想要进行深度学习的小伙伴,可以参考下面这篇教程进行相应环境的配置。

⭐️最新版本的Anaconda环境配置、Cuda、cuDNN以及pytorch环境一键式配置流程文章来源地址https://www.toymoban.com/news/detail-648540.html

到了这里,关于CUDA、cuDNN以及Pytorch介绍的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!