相关概念

CUDA 有两种API,分别是驱动API和 运行时 API 。

nvidia-smi:如果能正常使用,则说明Driver API 已经安装,nvidia-smi显示的是支持的最高的cuda版本,是向下兼容的

nvcc -V :是指实际安装的cuda toolkit 必须小于等于driver API支持的最高版本。

cuda卸载

非常感谢这篇博客,没有它我一天都卸载不了

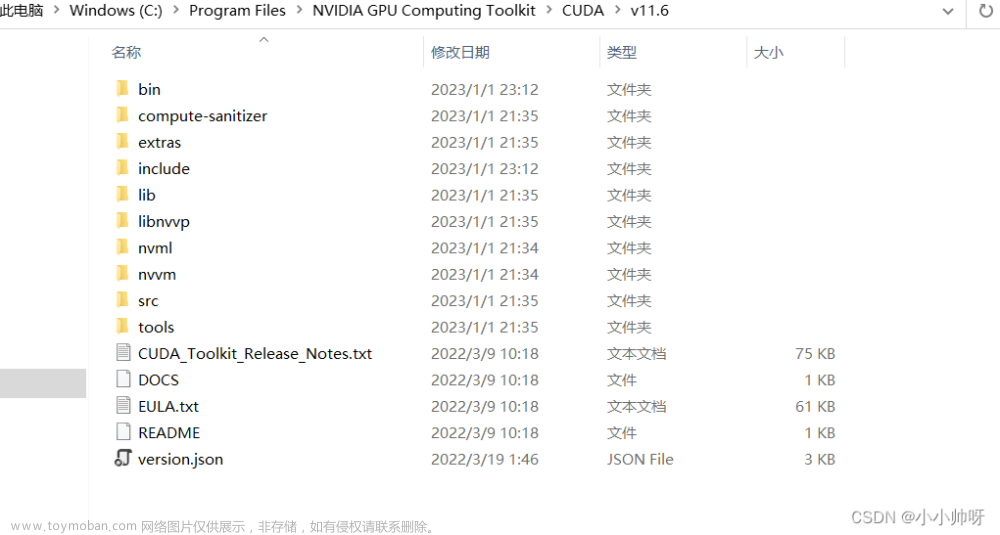

cuda安装

cuda安装教程1

cuda安装教程2

cuda 官网

安装pytorch

https://pytorch.org/get-started/previous-versions

我遇到的问题

我的服务器镜像已经安装了GPU驱动和cuda10.2(cuda toolkit) ,但是RTX 3090 的算力是sm_86,cuda10.x是不支持这个算力的,因此需要安装cuda11.x才可以。文章来源:https://www.toymoban.com/news/detail-651600.html

RTX3090算力对应关系文章来源地址https://www.toymoban.com/news/detail-651600.html

到了这里,关于运行nvidia-smi 和nvcc -V 出现的版本不一致问题详解的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!