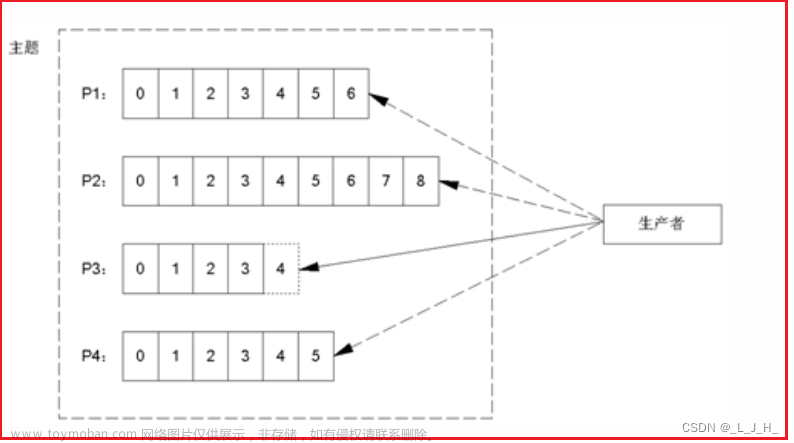

发送消息

流程如下:

- Producer 端直接将消息发送到 Broker 中的 Leader 分区中

- Broker 对应的 Leader 分区收到消息会先写入 Page Cache,定时刷盘进行持久化(顺序写入磁盘)

- Follower 分区拉取 Leader 分区的消息,并保持与 Leader 分区数据一致,待消息拉取完毕后需要给 Leader 分区回复 ACK 确认消息

- Leader 分区与 Follower 分区同步完数据,并收到所有 ISR 中的 Replica 副本的 ACK 后,Leader 分区会给 Producer 回复 ACK 确认消息

消费消息

流程如下:

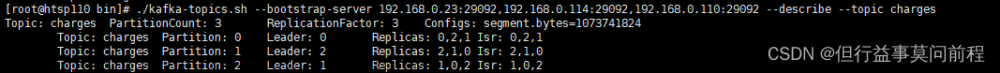

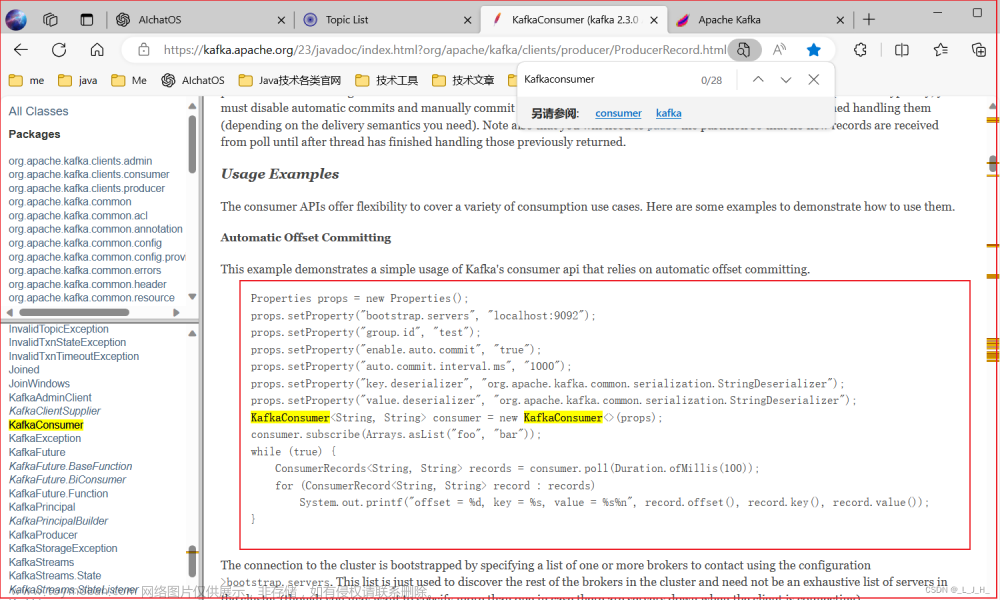

- Consumer 需要通过订阅关系获取到集群元数据, 找到相关 Topic 对应的 Leader 分区的数据,然后通过 Pull 模式主动的去 Kafka 集群中拉取消息

- 拉取到消息后进行业务逻辑处理,待处理完成后,会进行 ACK 确认,即提交 Offset 消费位移进度记录。

- 最后 Offset 会被保存到 Kafka Broker 集群中的 consumer_offsets 这个 Topic 中,且每个 Consumer 保存自己的 Offset 进度

注意:在这个过程中,有个消费者组的概念,多个 Consumer 可以组成一个消费者组即 Consumer Group,每个消费者组都有一个 GroupId。同一个 Consumer Group 中的 Consumer 可以消费同一个 Topic 下不同分区的数据,但是不会出现多个 Consumer 去消费同一个分区的数据。文章来源:https://www.toymoban.com/news/detail-653285.html

总结

综上所述,可以得出 Kafka 有三次消息传递的过程:文章来源地址https://www.toymoban.com/news/detail-653285.html

- Producer 端发送消息给 Broker 端

- Broker 将消息进行并持久化数据

- Consumer 端从 Broker 将消息拉取并进行消费

到了这里,关于Kafka 消息发送和消费流程的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!