前言

Meta发布的一代LLaMA已经掀起了一股开源大模型热潮,也有很多相关工作不断涌现。最近Meta全新发布了Llama-2,效果更上一层楼。而且最重要的是模型可以相对随意分发了,不像一代一样,meta不让开发者发布基于llama模型训练出来的权重(原版当然更不可以)。

既然有了Llama-2,国内开发者应该也会很快做出适配的吧。

我大概搜索了一下github,以chinese llama 2为关键字搜索,能看到已经有一些项目了。不过感觉其中有几个是挺像YX号的,为什么这么说呢,进去之后有卖课的PR(手动狗头)。

所以这次还是选择之前一直评测的Chinese LLaMA&Alpaca项目的二代项目。

项目地址:https://github.com/ymcui/Chinese-LLaMA-Alpaca-2

这个项目的特点

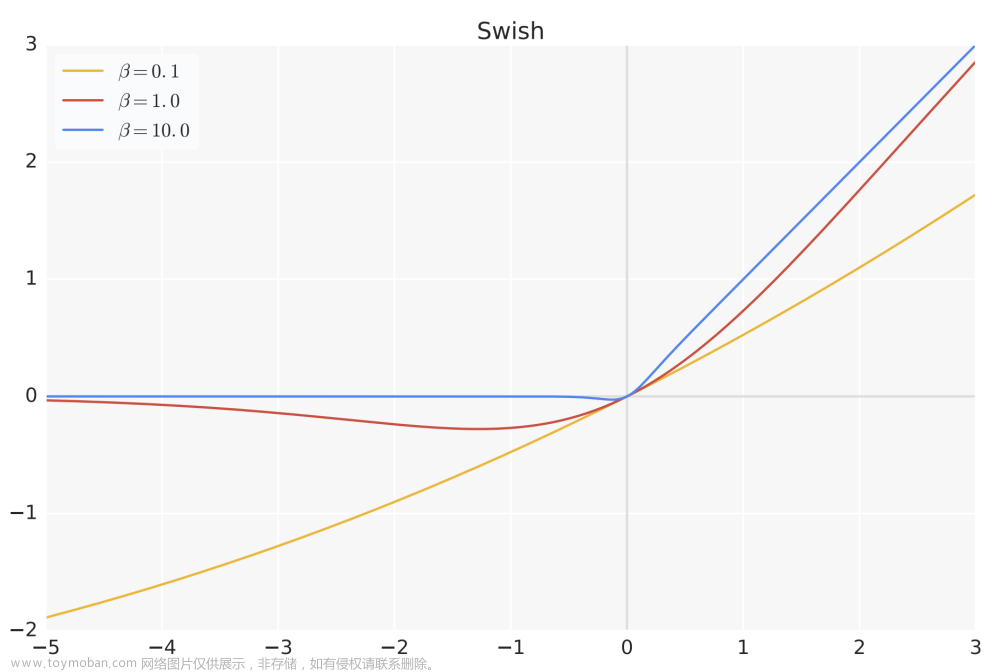

熟悉Llama-2的伙伴应该知道,7B和13B模型和一代的结构完全一样,所以原则上一代的相关代码都可以在这上用。但如果只是用一代的代码在Llama-2上调一下就拿出来可能也没有什么意思。好在这个项目确实也紧跟了学术界最新的一些技术,比如

- FlashAttention-2:这个技术可以让注意力机制计算的更快,好像是在CUDA底层方面做了一些改进,需要一些新架构的GPU(比如A100等)才能支持。有了这个可以让训练和推理变得更快

- 超长上下文:这个在前一阵子聊的也比较火,主要是因为有一些技术可以在不继续训练模型的情况下让模型支持的上下文长度有显著提升。这个项目设计了一个新的方法,可以让模型最长支持到18K+上下文(其实大多数人可能用不到)

- 当然还有一些其他优势,比如词表扩展(这一代用了经过优化的新的中文词表),提示语优化等等。

详细细节建议去看一下项目的模型简介。

模型下载

下载这个就不用细说了吧,前面已经讲到可以直接下载完整模型了。

链接:GitHub - ymcui/Chinese-LLaMA-Alpaca-2: 中文LLaMA-2 & Alpaca-2大语言模型 (Chinese LLaMA-2 & Alpaca-2 LLMs)

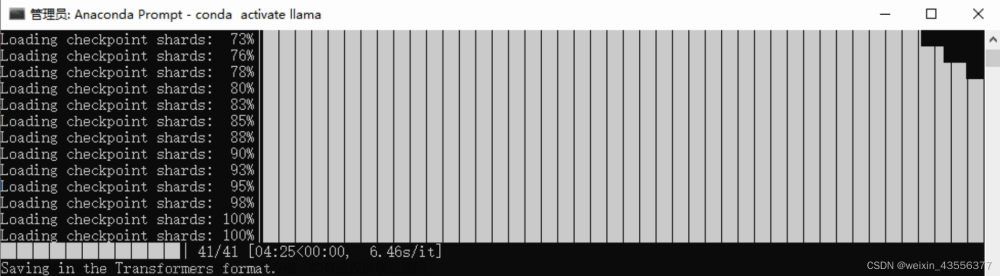

当然,因为完整模型比较大,如果想轻量下载的也可以下载LoRA然后自己手动合并。

对战平台

官方还弄了一个对战平台,里面是他们发布的所有对话模型。可以看到模型之间的对战结果和排名。这个系统不是实时的,是提前把多个模型在固定的集合上进行多次解码来模拟随机性,然后随机挑选两个系统对战。

这个是对战界面:

选完之后可以看到输出对应的模型名。

这个是排行榜界面,下面还有一个动态的两两对战胜率可视化图。

可以看到Alpaca-2-7B按胜率看排在中间,按Elo评分是排名第二。右下角可以看到对战次数,总的次数还并不多,所以排名仅供参考吧。

模型到底如何,接下来进入到我最喜欢的实战环节。

效果评测

老样子,我还是用llama.cpp来测试量化后的模型(苹果M系列芯片推理速度太香了)。按照官方推荐的Q6_K量化方法对模型进行量化。因为对话模型Alpaca-2-7B需要套用新的指令模板,官方还提供一个运行脚本,我也按照官方推荐的方式进行运行。

提示:有很多小伙伴用LLaMA(或者类似Baichuan模型)去进行对话,实际这类基座模型不具备对话能力,所以还是提醒各位小伙伴用的时候要注意在对的场景下使用对的模型,否则可能会白忙活。

接下来的截图中[INST]开头的是我输入的,[/INST]是系统开始回复的。这个是Llama-2的默认模板,感兴趣的可以看看Llama-2的论文。

多轮聊天

这个已经基本达到预期效果了,指令理解准确,且对上下文内容有一定的融合理解能力。

数学问答

这个结果相比一代的7B/13B已经好一些了,但数学能力仍然是小参数量模型的一个通病,大多数只是依靠“记忆”来回答模型,并没有太强的逻辑性。这一点之前我在评测中文Alpaca-33B的时候也有提到,大参数量的模型在数值计算方面具有显著优势。

知识问答

这次应该是比之前的一代Alpaca-7b/13b/33b都好一些,没有奇怪的佐料了。

写作

很好地完成了写作和后面的改写需求,内容相比一代模型有显著提升。

代码方面

这个是GPT-4的打分:

总结

总的来说,基于Llama-2开发的中文Alpaca-2相比其一代具有更好的效果,如果你之前在使用他们的一代项目的话建议升级到二代的模型。同时也可以看到,模型仍然存在数学、代码能力短板,也是小模型存在的普遍问题。期待后续有更大版本的模型出现。文章来源:https://www.toymoban.com/news/detail-654094.html

目前这些模型可以和一代的llama生态进行衔接,不过要注意不要用错指令模板,否则模型输出的内容会比较奇怪。文章来源地址https://www.toymoban.com/news/detail-654094.html

到了这里,关于【类ChatGPT】中文LLaMA-2、Alpaca-2 二代羊驼大模型体验的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!