在上一篇文章:《在Hive/Spark上运行执行TPC-DS基准测试 (ORC和TEXT格式)》中,我们介绍了如何使用 hive-testbench 在Hive/Spark上执行TPC-DS基准测试,同时也指出了该项目不支持parquet格式。

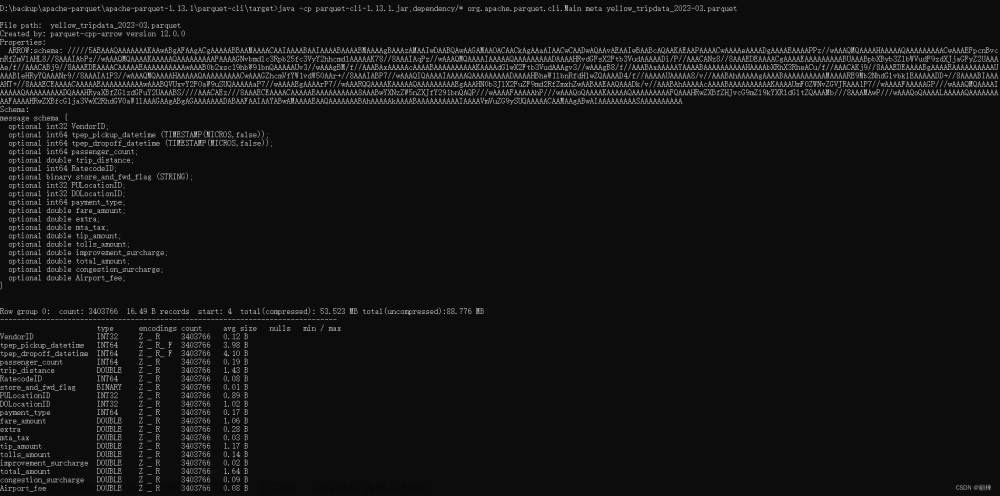

如果我们想要生成parquet格式的测试数据,就需要使用其他工具了。本文选择使用另外一个开源项目:https://github.com/kcheeeung/hive-benchmark,它和 hive-testbench 项目非常接近,操作方法也很类似,如果你熟悉 hive-testbench, 应该会必要容易掌握这个工具。

备注:本文使用的Hive/Spark环境为AWS EMR,版本:6.11,未启用Glue Data Catalog。本文操作须在EMR Master节点上执行!因为脚本中会使用到hdfs、beeline等命令行工具,此外,经测试发现:如果EMR集群使用的是Glue Data Catalog,脚本执行过程中将会报错:文章来源:https://www.toymoban.com/news/detail-657710.html

文章来源地址https://www.toymoban.com/news/detail-657710.html

文章来源地址https://www.toymoban.com/news/detail-657710.html

到了这里,关于在Hive/Spark上执行TPC-DS基准测试 (PARQUET格式)的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!