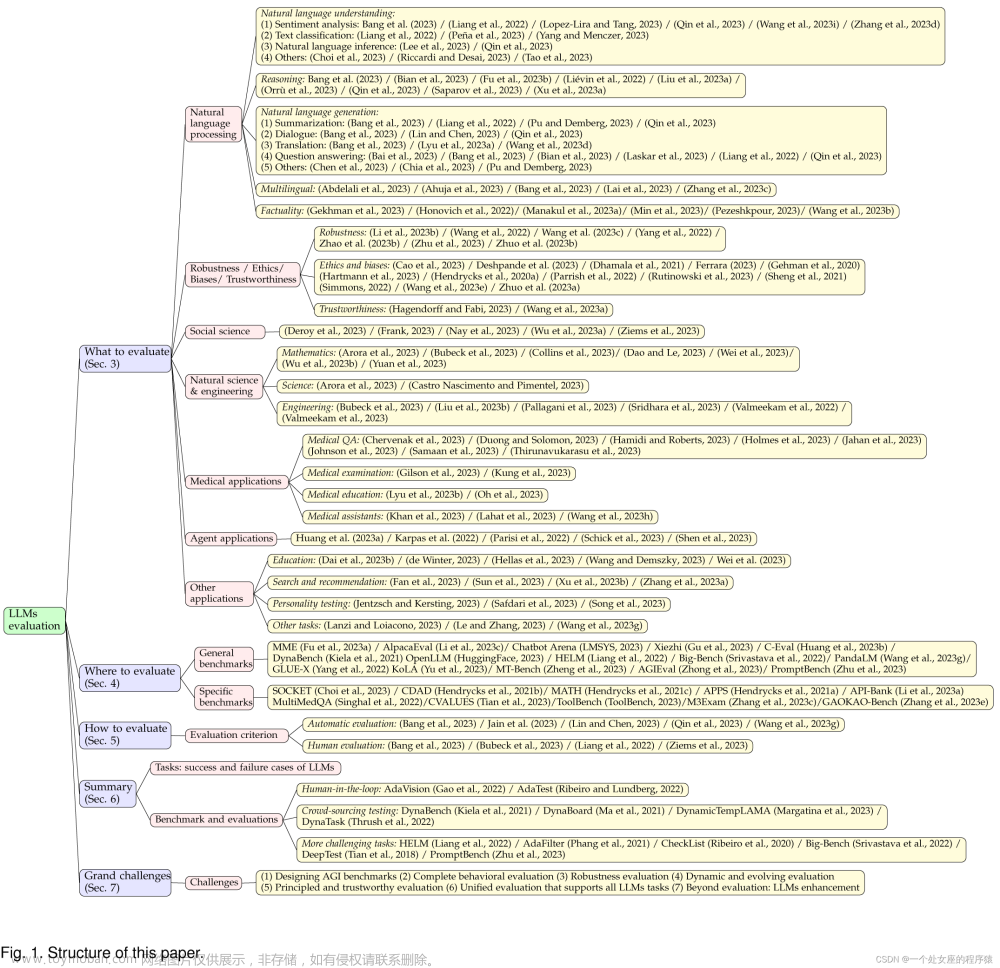

本文也是LLM系列相关文章,针对《MME: A Comprehensive Evaluation Benchmark for Multimodal Large Language Models》的翻译。

摘要

多模态大语言模型(MLLM)依靠强大的LLM来执行多模态任务,在最近的研究中显示出惊人的涌现能力,例如基于图像写诗。然而,这些案例研究很难完全反映MLLM的表现,缺乏全面的评估。在本文中,我们填补了这一空白,提出了第一个MLLM评估基准MME。它测量了总共14个子任务的感知和认知能力。为了避免直接使用公共数据集进行评估可能导致的数据泄露,指令-答案对的注释都是手动设计的。简洁的指令设计使我们能够公平地比较MLLM,而不是在提示工程中苦苦挣扎。此外,有了这样的指示,我们也可以很容易地进行定量统计。在我们的MME上,共对12种先进的MLLM进行了全面评估,这不仅表明现有的MLLM仍有很大的改进空间,而且揭示了后续模型优化的潜在方向。

1 引言

2 MME评估套件

3 实验

4 分析

我们总结了四个在很大程度上影响MLLMs性能的常见问题。第一个问题是没有遵循指令。尽管我们采用了非常简洁的指令设计,但也有MLLM可以自由回答,而不是遵循指令。例如,如图4的第一行所示,指令声称“请回答是或否”,但MLLM只做了一个声明性表达式。如果在生成的语言的开头没有出现“是”或“否”,则判断模型做出了错误的回答。我们认为,一个好的MLLM(尤其是在指令调整之后)应该能够遵循这样一个简单的指令,这在日常生活中也很常见。

第二个问题是缺乏认识。如图4的第二行所示,MLLM错误识别了第一张图像中香蕉的数量,并误读了第二张图像中的字符,导致了错误的答案。我们注意到,感知的表现容易受到指令的细微差别的影响,因为同一图像的两个指令只在一个词上不同,但会导致完全不同甚至矛盾的感知结果。

第三个问题是缺乏推理。在图4的第三行中,我们可以从红色文本中看到,MLLM已经知道第一个图像不是办公场所,但仍然给出了“是”的错误答案。类似地,在第二张图像中,MLLM计算出了正确的算术结果,但最终给出了错误的答案。这些现象表明,在MLLM的推理过程中,逻辑链是断裂的。添加CoT提示,例如“让我们一步一步思考” ,可能会产生更好的结果。我们期待着进一步深入的研究。

第四个问题是遵循指令的对象幻觉,如图4第四行所示。当指令包含未出现在图像中的对象的描述时,MLLM将假设该对象存在,并最终给出“是”的答案。如表1、表2和表3所示,这种不断回答“是”的情况导致大约50%的准确度和大约0的准确度。这表明迫切需要抑制幻觉,社区应该考虑生成答案的可靠性。文章来源:https://www.toymoban.com/news/detail-657741.html

5 结论

本文提出了第一个MLLM评估基准MME,它在任务类型、数据源、指令设计和定量统计方面具有四个不同的特点。我们在MME上评估了12种先进的MLLMs,实验结果表明仍有很大的改进空间。我们还总结了实验结果中提出的常见问题,为MLLM的发展提供了有价值的指导。文章来源地址https://www.toymoban.com/news/detail-657741.html

到了这里,关于MME: A Comprehensive Evaluation Benchmark for Multimodal Large Language Models的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!