当讨论CUDA、cuDNN、深度学习框架、pytorch、tensorflow、keras这些概念的时候,我们讨论的是与GPU加速深度学习相关的技术和工具。

-

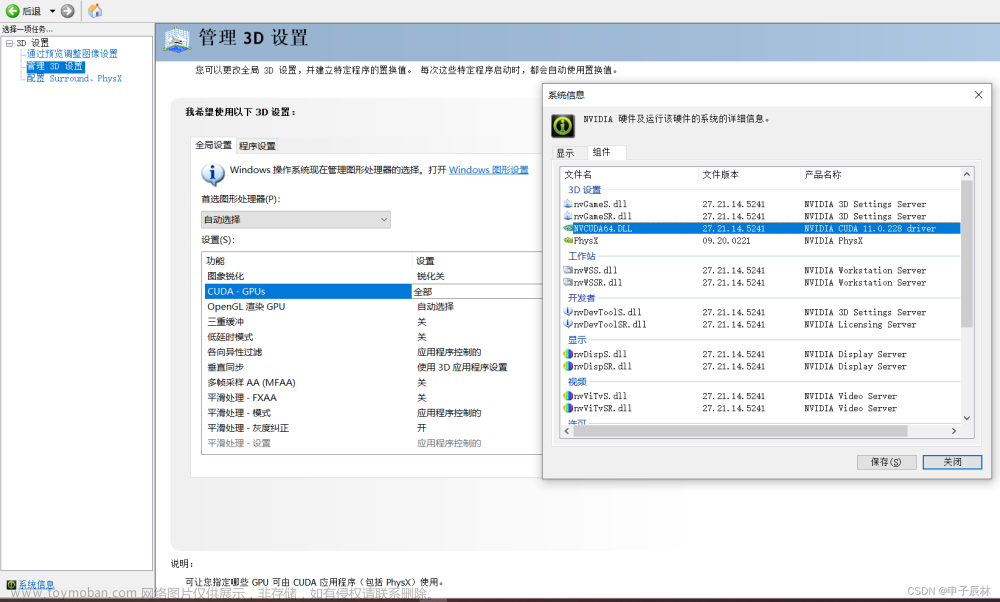

CUDA(Compute Unified Device Architecture): CUDA是由NVIDIA开发的一种并行计算平台和编程模型,旨在利用GPU(图形处理单元)进行通用目的的高性能计算。它允许开发人员利用GPU的大规模并行计算能力来加速各种计算任务,包括深度学习。CUDA提供了一组编程接口,允许开发人员在C、C++、Python等编程语言中编写并行代码,并通过GPU加速执行。

-

cuDNN(CUDA Deep Neural Network library): cuDNN是NVIDIA提供的深度学习加速库,专门为深度神经网络设计。它包含了一系列高效的GPU加速的深度学习基本操作,如卷积、池化、归一化等。cuDNN旨在优化深度学习模型的训练和推断过程,通过利用GPU的计算能力来提高性能。cuDNN的主要接口是用C语言编写的,因此最常见的方式是通过C/C++来调用cuDNN库。不过,cuDNN也提供了一些绑定(bindings)或接口,使得其他编程语言也能够调用它。

-

深度学习框架: 深度学习框架是一种软件工具,用于简化和加速深度学习模型的开发、训练和部署过程。这些框架提供了高级API和工具,使开发人员能够更轻松地构建和训练神经网络模型。一些常见的深度学习框架包括TensorFlow、PyTorch、Keras、Caffe等。这些框架通常会与CUDA和cuDNN等GPU加速技术集成,以便在GPU上高效地运行深度学习任务。

-

PyTorch: PyTorch是一个基于Python的深度学习框架,由Facebook的研究团队开发。它的设计哲学强调动态计算图,使得模型的构建和调试更加直观灵活。PyTorch具有广泛的社区支持和丰富的功能,可以用于构建各种深度学习模型,包括卷积神经网络、循环神经网络等。PyTorch与CUDA和cuDNN紧密集成,允许用户在GPU上高效地训练和执行深度学习模型。

-

Keras:Keras是一个高级的神经网络API,最初由François Chollet开发,用于快速构建、训练和部署神经网络模型。它的设计目标是简洁、易用,适合快速原型开发和初学者。Keras最初是独立的,并且支持多个深度学习后端,包括Theano、CNTK和TensorFlow。从TensorFlow 2.0版本开始,Keras成为TensorFlow的默认高级API。这意味着你可以在TensorFlow中直接使用Keras的API来构建和训练神经网络模型,无需额外的安装和配置。

-

Tensorflow:TensorFlow是由Google Brain团队于2015年开源发布的深度学习框架,它适用于高效利用分布式计算资源的机器学习框架,以支持大规模的训练和推断任务。

如何想要设计新的深度学习框架,在着手构建新框架之前需要咨询研究现有的深度学习框架,如TensorFlow、PyTorch、Keras等。了解它们的架构、设计思想和功能,这可以为你提供宝贵的启发,帮助你避免重复造轮子。

tensorflow与pytorch的一些重点差异

动态计算图 vs 静态计算图:

- TensorFlow:TensorFlow 1.x使用静态计算图,需要在构建阶段先定义计算图的结构,然后再进行计算。TensorFlow 2.x引入了更具动态性的特性,使其更接近动态计算图的风格。

- PyTorch:PyTorch使用动态计算图,计算图在运行时动态生成,允许更灵活地处理动态结构和条件。

调试和可读性:文章来源:https://www.toymoban.com/news/detail-658422.html

- TensorFlow:在TensorFlow 1.x中,由于静态计算图的设计,调试过程可能相对复杂。TensorFlow 2.x和Keras在调试和可读性方面有所改进。

- PyTorch:动态计算图使得在PyTorch中调试模型和查看中间结果更加容易。

分布式计算:文章来源地址https://www.toymoban.com/news/detail-658422.html

- TensorFlow:TensorFlow在分布式计算方面具有丰富的功能,可以有效地利用多台机器进行大规模训练。

- PyTorch:PyTorch也支持分布式计算,但在一些方面可能没有TensorFlow那么全面。

到了这里,关于cuda、cuDNN、深度学习框架、pytorch、tentsorflow、keras这些概念之间的关系的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!