1.项目说明

- 最近需要用到一些mediapipe中的模型功能,于是尝试对mediapipe中的一些模型进行转换,并使用MNN进行推理;

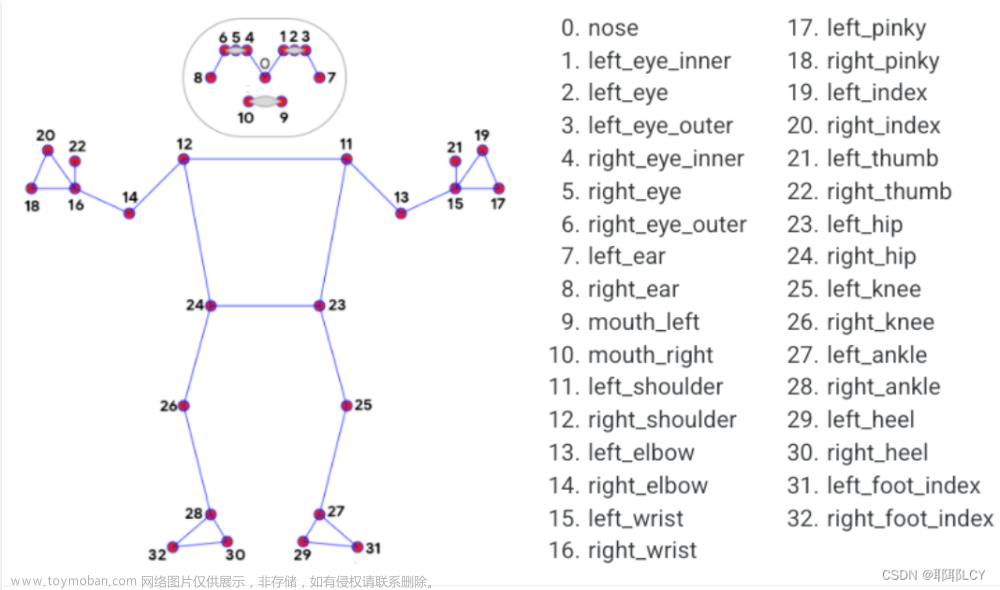

- 主要模型包括:图像分类、人脸检测及人脸关键点mesh、手掌检测及手势关键点、人体检测及人体关键点、图像嵌入特征向量、图像特征点检测及匹配模型;

2.一些效果:

文章来源:https://www.toymoban.com/news/detail-661504.html

文章来源:https://www.toymoban.com/news/detail-661504.html

3.项目开源地址

Mediapipe-MNN

欢迎大家体验并点star~文章来源地址https://www.toymoban.com/news/detail-661504.html

到了这里,关于MNN学习笔记(八):使用MNN推理Mediapipe模型的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!