要看几个方面

1 算力:

2 支持何种模型:

3 是否支持可视化的窗口系统:

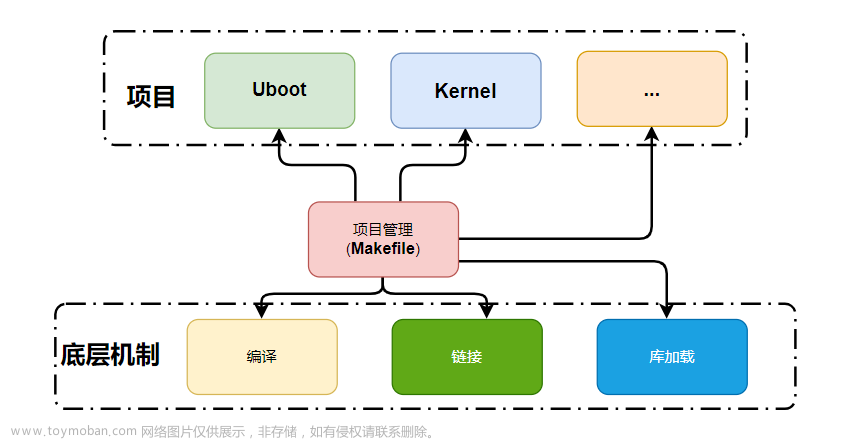

一般而言各个平台均采用linux操作系统,官方提供对应SDK,安装好后可使用硬件加速资源。

而且如果要使用其硬件加速,一般都要完成模型转换,将模型转为该平台所特有的格式。平台的SDK会提供转换工具。

深度学习加速单元NPU

平台一般为异构,即CPU(一般为arm结构)和加速单元。

NPU 是什么

NPU(神经处理单元)是一种专门设计用于加速人工神经网络(ANN)和深度学习任务的硬件组件。它是一种特定于AI(人工智能)和机器学习工作负载的处理单元,通常用于执行神经网络的前向传播和推断操作。NPU的设计旨在高效地执行矩阵乘法、卷积运算和其他深度学习操作,以加快模型训练和推理的速度。

NPU通常与中央处理单元(CPU)和图形处理单元(GPU)协同工作,以提供更高的性能和能效,特别是在需要大规模深度学习模型的应用中,如计算机视觉、自然语言处理和语音识别等领域。各种芯片制造商和硬件供应商都推出了自己的NPU解决方案,以满足不同应用场景的需求。

总之,NPU是专门设计用于加速深度学习任务的硬件单元,旨在提高模型训练和推理的速度和效率。它在人工智能和机器学习领域具有重要的应用前景。

NPU(神经处理单元)通常被用作一个统称,而不是一个特定的硬件架构。它描述了一种专门设计用于加速神经网络和深度学习任务的硬件处理单元的概念。

加速单元如下:

CPU、GPU、TPU、NPU等到底是什么?

官网能查询到参数,但一般都是处理器或者核心板的参数,开发板的外围接口信息要问具体商家。

算力可以去硕士论文里找找看,一般以某个网络为基准,比如看看yolov3在该平台耗时多久

1.GPU

-

厂家:NVIDIA link

-

Jetson AGX Orin 系列

-

Jetson Orin NX 系列

-

Jetson Orin Nano 系列

-

Jetson AGX Xavier 系列

-

Jetson Xavier NX 系列

-

Jetson TX2 系列

-

Jetson Nano

-

IGX 平台

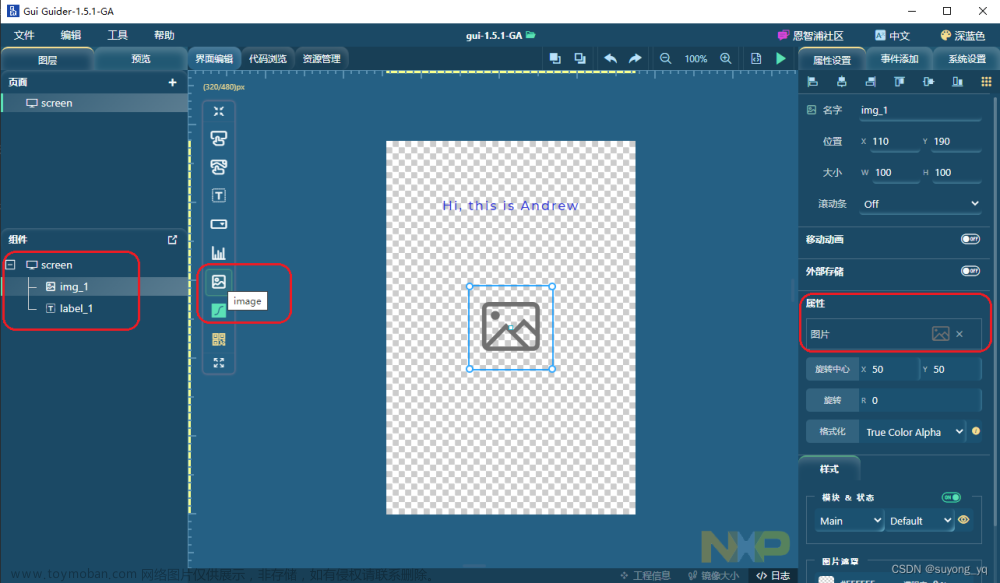

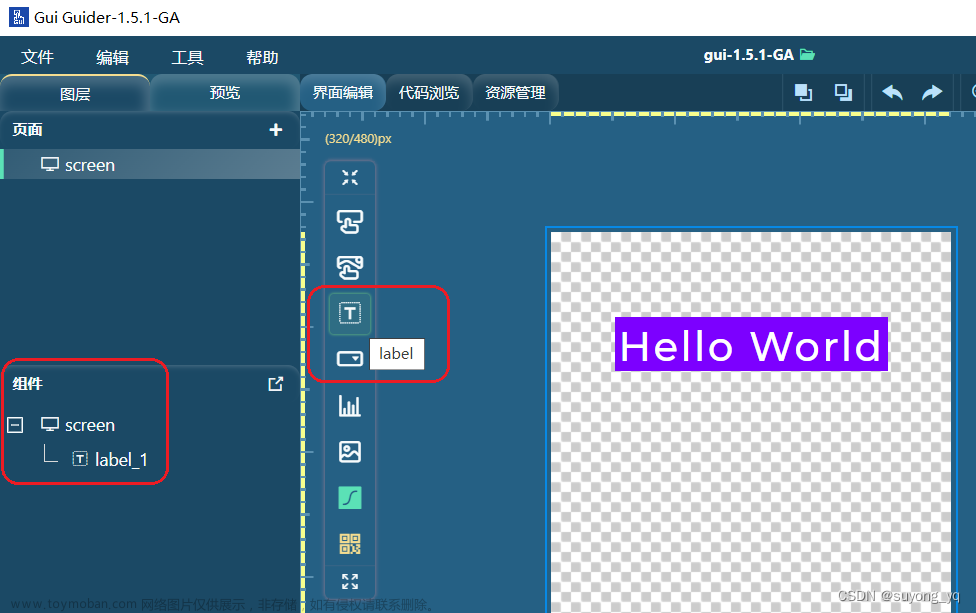

开发工具

平台特有模型为TensorRT,可将ONNX模型转为TensorRT。无论是pytorch还是tensorflow还是caffe都能转为ONNX。

开发板一般支持可视化的操作系统

2.FPGA

FPGA 是一种硬件可重构的体系结构。它的英文全称是Field Programmable Gate Array,中文名是现场可编程门阵列。这个东西算力很强,但是价格贵。

-

厂家:xilinx

-

Versa AI Edge 系列 link

-

Versa AI Core link

-

UltraScale 系列link link

型号很多,命名很奇怪,名字一般不带系列名,而是A** V** K**

开发工具

Vitis AI(以前称为DNNDK):Vitis AI是Xilinx的一个工具套件,支持将深度学习模型部署到Xilinx的FPGA和ACAP硬件平台上。它可以用于部署ONNX、PyTorch、TensorFlow和Caffe等框架训练的模型。Vitis AI提供了模型优化、量化、编译和部署的工具,以实现高性能的硬件加速。

Vitis:Vitis是Xilinx的软件开发环境,它包括针对FPGA的高级综合(High-Level Synthesis,HLS)工具。开发人员可以使用Vitis来实现自定义的硬件加速器,以支持各种深度学习框架。

PetaLinux:PetaLinux是Xilinx的嵌入式Linux解决方案,它可以与深度学习库和工具集成,以支持将深度学习模型部署到Xilinx的嵌入式硬件平台上

开发板一般不支持可视化的操作系统,但我记得那么几款是支持的,但是很贵。文章来源:https://www.toymoban.com/news/detail-665348.html

改天补充,今天先到这里了,要查的资料挺多的

3.VPU

4.TPU

5.BPU

6.DPU IPU NNIE

其他厂商

寒武纪、百度、瑞芯微、海思晟腾、firefly文章来源地址https://www.toymoban.com/news/detail-665348.html

到了这里,关于AI嵌入式全景:各厂商、系列和开发工具的综合概览的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!