本系列教程适用于没有任何pytorch的同学(简单的python语法还是要的),从代码的表层出发挖掘代码的深层含义,理解具体的意思和内涵。pytorch的很多函数看着非常简单,但是其中包含了很多内容,不了解其中的意思就只能【看懂代码】,无法【理解代码】。

官方定义

Dropout是一种常用的正则化方法,通过随机将部分神经元的输出置为0来减少过拟合。

Dropout在训练时随机讲某些张量的值设为0,从而减少模型对训练数据的依赖程序,提高泛化能力;同时在测试时需要关闭Dropout,具体来说,如果处于model.eval模式时,并不会使用Dropout。

官方的文档如下,torch.nn.Dropout:

demo

下面是一个官方文档给出的例子:

import torch

import torch.nn as nn

m = nn.Dropout(p=0.2)

input = torch.randn(20, 16)

output = m(input)

print(input[0])

print(output[0])

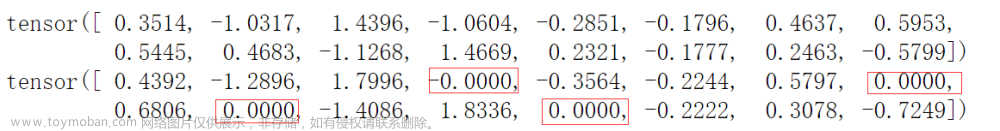

输出的结果:

我们会发现:

- 有一部分的值变为了0,这些值大约占据总数的0.2。

- 其它非0参数都除以0.8,使得值变大了。比如:

0.3514 / 0.8 = 0.4392,-1.0317 / 0.8 = -1.2896。

Dropout的位置

一般来说,我们在实现的神级网络中这么定义:

self.dropout = nn.Dropout(0.3)

但是具体在哪里使用是个问题。

一般来说,Dropout使用位置是在隐藏层之间的节点上,具体来说,就是在全连接层之间放置Dropout来避免过拟合:文章来源:https://www.toymoban.com/news/detail-666510.html

import torch

import torch.nn as nn

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.fc1 = nn.Linear(in_features, hidden_size)

self.dropout = nn.Dropout(dropout_prob)

self.fc2 = nn.Linear(hidden_size, out_features)

def forward(self, x):

x = self.fc1(x)

x = self.dropout(x)

x = torch.relu(x)

x = self.fc2(x)

return x

比如上面得这个例子,dropout被放置在fc1和fc2之间。文章来源地址https://www.toymoban.com/news/detail-666510.html

到了这里,关于无脑入门pytorch系列(五)—— nn.Dropout的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!