目录

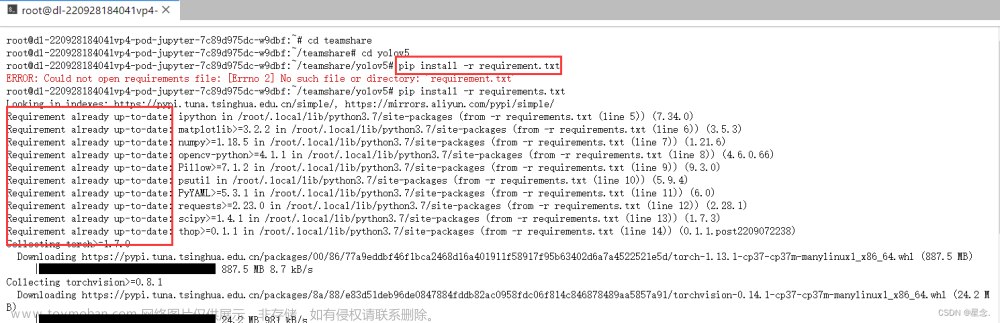

第一步:下载YOLOv5代码,并配置环境,测试一下是否有无环境问题

第二步:数据集格式的转换与划分

第三步:修改配置文件,准备训练

第一步:下载YOLOv5代码,并配置环境,测试一下是否有无环境问题

yolov5_5.0源代码开源地址:

1.源代码下载后右击选择PyCharm打开,等待一会,会弹出一个要你配置环境的对话框,关掉它,我们自己配置环境。

配置环境: 点击【文件】->【设置】->【Python解释器】,选择相应的环境【我的是:pytorch】

配置要有个一两分钟,等待一下

2.找到【detect.py】,右击运行,报错如下:

原因:没有放权重文件进去,下载地址:权重地址

解决方法:下载后放到项目文件中去。

3.再次运行【detect.py】结果:在D:\DeepLearning\projectone\yolov5-5.0\runs\detect\exp2中生成了预测的结果图片,但是没有预测框?????

解决方法1:在53行添加如下代码:

cudnn.benchmark = True添加后就是这样的:

然后再运行【detect.py】,结果如下,有了预测框,但是出现的问题就是检测速度变慢了,具体也不知道为啥,有懂得小伙伴可以留言呐!!

解决方法2:在【detect.py】,定位到32行,注释掉原来的代码,更改为

half = False

结果:预测框就出现了!!!!

经过以上测试,说明我们得环境是没有问题的,可以进行下一步啦。

---------------------------------------------------手动分割线---------------------------------------------------------------

第二步:数据集格式的转换与划分

参考博客:

(70条消息) 使用Yolov5训练自己制作的数据集,快速上手_佐咖的博客-CSDN博客_yolov5数据集格式

我使用的是Make Sense在线标注,还是挺方便的,不过要注意一次不要导入太多图片,因为是在线网页上的操作,要是误关了网页,就要重来了。。。使用很简单,这里不赘述。

标注完后得到一份压缩包:

解压后得到xml文件:

下面开始对标注的格式进行转换,并划分数据集,这里是VOC格式

1.首先创建VOC格式数据集文件格式:先对格式做个说明:这里是划分前的文件夹形式,自己按照如下格式创建好文件夹:(说明:dataset是我D盘下的一个文件夹,这里自己定,我没有把VOCdevkit数据集文件夹放到yolo项目根目录中)

在创建好文件夹后,将图片放入JPEGImages,将makesense导出的xml文件放入Annotations。

2.转换脚本:主要修改一下路径

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

import random

from shutil import copyfile

classes = ["cat","dog","fox"] ## 这里要写好标签对应的类

TRAIN_RATIO = 80 # 表示将数据集划分为训练集和验证集,按照2:8比例来的

def clear_hidden_files(path):

dir_list = os.listdir(path)

for i in dir_list:

abspath = os.path.join(os.path.abspath(path), i)

if os.path.isfile(abspath):

if i.startswith("._"):

os.remove(abspath)

else:

clear_hidden_files(abspath)

def convert(size, box):

dw = 1. / size[0]

dh = 1. / size[1]

x = (box[0] + box[1]) / 2.0

y = (box[2] + box[3]) / 2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(image_id):

in_file = open('D:/DeepLearning/dataset/VOCdevkit/VOC2022/Annotations/%s.xml' % image_id)

out_file = open('D:/DeepLearning/dataset/VOCdevkit/VOC2022/YOLOLabels/%s.txt' % image_id, 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

in_file.close()

out_file.close()

wd = os.getcwd()

wd = os.getcwd()

data_base_dir = os.path.join(wd, "D:/DeepLearning/dataset/VOCdevkit/")

if not os.path.isdir(data_base_dir):

os.mkdir(data_base_dir)

work_sapce_dir = os.path.join(data_base_dir, "D:/DeepLearning/dataset/VOCdevkit/VOC2022/")

if not os.path.isdir(work_sapce_dir):

os.mkdir(work_sapce_dir)

annotation_dir = os.path.join(work_sapce_dir, "D:/DeepLearning/dataset/VOCdevkit/VOC2022/Annotations/")

if not os.path.isdir(annotation_dir):

os.mkdir(annotation_dir)

clear_hidden_files(annotation_dir)

image_dir = os.path.join(work_sapce_dir, "D:/DeepLearning/dataset/VOCdevkit/VOC2022/JPEGImages/")

if not os.path.isdir(image_dir):

os.mkdir(image_dir)

clear_hidden_files(image_dir)

yolo_labels_dir = os.path.join(work_sapce_dir, "D:/DeepLearning/dataset/VOCdevkit/VOC2022/YOLOLabels/")

if not os.path.isdir(yolo_labels_dir):

os.mkdir(yolo_labels_dir)

clear_hidden_files(yolo_labels_dir)

yolov5_images_dir = os.path.join(data_base_dir, "images/")

if not os.path.isdir(yolov5_images_dir):

os.mkdir(yolov5_images_dir)

clear_hidden_files(yolov5_images_dir)

yolov5_labels_dir = os.path.join(data_base_dir, "labels/")

if not os.path.isdir(yolov5_labels_dir):

os.mkdir(yolov5_labels_dir)

clear_hidden_files(yolov5_labels_dir)

yolov5_images_train_dir = os.path.join(yolov5_images_dir, "train/")

if not os.path.isdir(yolov5_images_train_dir):

os.mkdir(yolov5_images_train_dir)

clear_hidden_files(yolov5_images_train_dir)

yolov5_images_test_dir = os.path.join(yolov5_images_dir, "val/")

if not os.path.isdir(yolov5_images_test_dir):

os.mkdir(yolov5_images_test_dir)

clear_hidden_files(yolov5_images_test_dir)

yolov5_labels_train_dir = os.path.join(yolov5_labels_dir, "train/")

if not os.path.isdir(yolov5_labels_train_dir):

os.mkdir(yolov5_labels_train_dir)

clear_hidden_files(yolov5_labels_train_dir)

yolov5_labels_test_dir = os.path.join(yolov5_labels_dir, "val/")

if not os.path.isdir(yolov5_labels_test_dir):

os.mkdir(yolov5_labels_test_dir)

clear_hidden_files(yolov5_labels_test_dir)

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'w')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'w')

train_file.close()

test_file.close()

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'a')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'a')

list_imgs = os.listdir(image_dir) # list image files

prob = random.randint(1, 100)

print("Probability: %d" % prob)

for i in range(0, len(list_imgs)):

path = os.path.join(image_dir, list_imgs[i])

if os.path.isfile(path):

image_path = image_dir + list_imgs[i]

voc_path = list_imgs[i]

(nameWithoutExtention, extention) = os.path.splitext(os.path.basename(image_path))

(voc_nameWithoutExtention, voc_extention) = os.path.splitext(os.path.basename(voc_path))

annotation_name = nameWithoutExtention + '.xml'

annotation_path = os.path.join(annotation_dir, annotation_name)

label_name = nameWithoutExtention + '.txt'

label_path = os.path.join(yolo_labels_dir, label_name)

prob = random.randint(1, 100)

print("Probability: %d" % prob)

if (prob < TRAIN_RATIO): # train dataset

if os.path.exists(annotation_path):

train_file.write(image_path + '\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_train_dir + voc_path)

copyfile(label_path, yolov5_labels_train_dir + label_name)

else: # test dataset

if os.path.exists(annotation_path):

test_file.write(image_path + '\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_test_dir + voc_path)

copyfile(label_path, yolov5_labels_test_dir + label_name)

train_file.close()

test_file.close()

转换后结果:

1)在YOLOLabels中生成了txt格式的标注文件,完成了xml到txt格式的转换;

2)在VOCdevkit下生成了两个文件夹Images和labels,分别存放图片和txt格式的标注文件

Images下存放训练集和验证集图片,比例8:2,labels下存放训练集和验证集的标注文件,比例8:2,完成了训练集与验证集的划分。

具体格式如下:

第三步:修改配置文件,准备训练

1.在【data】中,复制coco.yaml,直接ctrl+c,然后ctrl+v,重命名为【my_obstacle.yaml】,名字可任意,然后保存在【data】下

修改【my_obstacle.yaml】文件内容,我这里的训练集验证集路径不在yolo根目录下,所以都是写的绝对路径。

2.在【models】文件夹下复制yolov5s.yaml,重命名为【yolov5s_obstacle.yaml】,名字可任意,然后保存在【models】下

修改类别为3

3.修改【train.py】

1)weights----模型权重在yolo项目根目录下

2)cfg----在pycharm左边目录栏,右击【yolov5s_obstacle.yaml】,复制路径,来自内容根的路径,粘贴即可

3)data----在pycharm左边目录栏,右击【my_obstacle.yaml】,复制路径,来自内容根的路径,粘贴即可

4)epochs----训练轮数,我这里是100轮

5)batch_size----根据电脑性能修改,我这里只能是1才能跑起来(我的显卡GTX1650)

6)workers----我一直用的是1,这里我不确定,可以自己尝试一下

然后开始运行【train.py】

训练过程中输出的参数:刚好在训练时写这篇博客,贴个图吧

每次训练都要网上找个博客看步骤,这次索性自己写一个,记录一下

如有错误请指正!

2022.11.28补充:

今天在改网络结构,开始训练的时候会报错:

RuntimeError: result type Float can‘t be cast to the desired output type long int

解决方法参考:文章来源:https://www.toymoban.com/news/detail-666796.html

(75条消息) 一步真实解决RuntimeError: result type Float can‘t be cast to the desired output type long int_蓝胖胖▸的博客-CSDN博客文章来源地址https://www.toymoban.com/news/detail-666796.html

到了这里,关于YOLOv5_5.0训练自己的数据集 RuntimeError: result type Float can‘t be cast to the desired output type long int的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!