OpenCV中的随机森林是一种强大的机器学习算法,旨在解决分类和回归问题。随机森林使用多个决策树来进行预测,每个决策树都是由随机选择的样本和特征组成的。在分类问题中,随机森林通过投票来确定最终的类别;在回归问题中,随机森林通过平均所有决策树的预测结果来获得最终预测值。

随机森林的基本思想

随机森林是一种监督学习算法,它构建的“森林”是决策树的集合,通常使用Bagging算法进行集成。随机森林首先使用训练出来的分类器集合对新样本进行分类,然后用多数投票或者对输出求均值的方法统计所有决策树的结果。由于森林中的每一棵决策树都具有独立性,可以理解为是某一方面的研究“专家”,因而可以通过投票和求平均值的方法获得比单棵决策树更好的性能。

决策树的构建及其不足

决策树的构建是一个递归的过程,理想情况下所有的记录都能被精确分类,即生成决策树叶节点都有确定的类型,但现实这种条件往往很难满足,这使得决策树的构建时可能很难停止。即使构建完成,也常常会使得最终的节点数据过多,从而导致过度拟合(overfitting),因此在实际应用中需要设定停止条件,当达到停止条件时,直接停止决策树的构建。但这仍然不能完全解决过度拟合问题,过度拟合的典型表现是决策树对训练数据错误率很低,而对测试数据其错误率却非常高。

过度拟合常见原因有:

(1)训练数据中存在噪声;

(2)数据不具有代表性。过度拟合的典型表现是决策树的节点过多,因此实际中常常需要对构建好的决策树进行枝叶裁剪(Pumne Tree ),但它不能解决根本问题。

随机森林算法的出现能够较好地解决过度拟合问题。

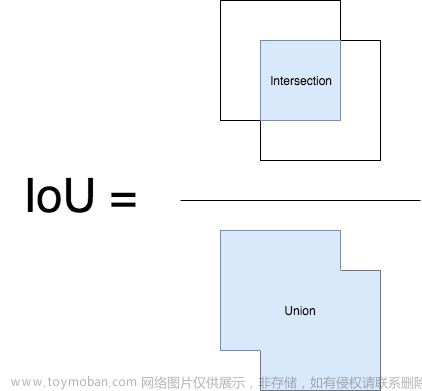

下图给出了随机森林算法分类原理,从图中可以看到,随机森林是一个组合模型,内部仍然是基于决策树,同单一的决策树分类不同的是,随机森林通过多个决策树投票结果进行分类,算法不容易出现过度拟合问题。

Bagging算法

由于随机森林通常采用Bagging算法对决策树进行集成,因此有必要了解Bagging算法的工作流程与原理。某些分类器的分类准确率有时只稍好于随机猜测,这样的分类器称为弱分类器。为了提高分类器的性能,通常使用集成学习(Ensemble Learning)的方法将若干弱分类器组合之后生成一个强分类器。

Bagging算法和Boosting算法是集成学习领域的基本算法。

Bagging算法的流程如下所示

可以看出,Bagging算法的流程分为训练和测试两个阶段。

训练阶段:从原始训练集中使用Bootstrapping抽样方法先随机抽取N个训练样本,之后把这N个训练样本放回原训练集,共进行k轮抽取,得到k个训练子集。使用这k个训练子集,训练k个基础模型(基础模型可以是决策树或神经网络等)。

测试阶段:对于每个测试样本,都使用所有训练好的基础模型进行预测;之后结合所有k个基础模型的结果进行预测。如果是回归问题,则采用k个基础模型的预测平均值作为最终预测结果;如果是分类问题,则对k个基础模型的分类结果进行投票表决,得票最多的类别为最终分类结果。

应用场景

随机森林算法是一种集成学习方法,主要用于解决分类和回归问题。应用场景包括:

- 商品推荐系统:可以根据用户历史行为,购买记录等数据,预测用户可能喜欢的商品,从而进行精准推荐。

- 医学诊断:可以根据病人的基本信息,症状等数据,预测病人是否患有某种疾病,并给出诊断及治疗方案。

- 金融风险评估:通过分析客户的个人信用记录,收入情况等数据,预测客户的违约概率,帮助银行制定个性化的信贷方案。

- 股票预测:通过分析历史股价,财务数据等信息,预测未来股价的走势。

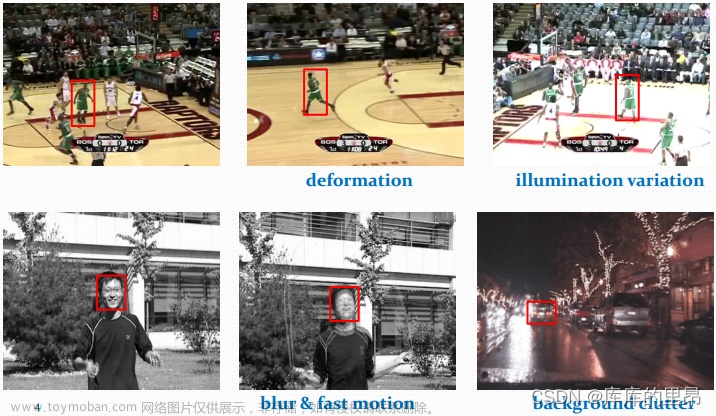

- 图像识别:可以对图像进行分类,例如将动物图像进行分类,检测图像中是否有猫,狗等动物。

- 自然语言处理:可以进行文本分类,例如对新闻进行分类,判断某篇文章是属于国际新闻,体育新闻等。

下面是一个用OpenCV实现随机森林分类器的例子,具体步骤如下:

- 导入必要的库

import numpy as np

import cv2

- 准备训练数据和标签

features = np.array([[0, 0], [0, 1], [1, 0], [1, 1]], np.float32)

labels = np.array([0, 1, 1, 0], np.float32)

- 初始化随机森林分类器

rf = cv2.ml.RTrees_create()

- 设置训练参数

params = cv2.ml.RTrees_Params()

params.max_depth = 2

params.min_sample_count = 1

params.calc_var_importance = True

- 训练随机森林

rf.train(cv2.ml.TrainData_create(features, cv2.ml.ROW_SAMPLE, labels), cv2.ml.ROW_SAMPLE, params=params)

- 预测

pred = rf.predict(np.array([[0, 0]], np.float32))

print(pred)

这将输出预测的标签。

全部代码:文章来源:https://www.toymoban.com/news/detail-668916.html

import numpy as np

import cv2

# 生成示例数据

data = np.random.randint(0, 100, (100, 2)).astype(np.float32)

responses = (data[:, 0] + data[:, 1] > 100).astype(np.float32)

# 创建并训练随机森林分类器

rf = cv2.ml.RTrees_create()

# 设置终止条件(最大迭代次数,最大迭代次数,最小变化值)

rf.setTermCriteria((cv2.TERM_CRITERIA_MAX_ITER, 100, 0.01))

# 设置随机森林的最大深度

rf.setMaxDepth(10)

# 设置每个叶子节点的最小样本数量

rf.setMinSampleCount(2)

# 设置回归精度(对分类问题不适用)

rf.setRegressionAccuracy(0)

# 设置是否使用代理(对分类问题不适用)

rf.setUseSurrogates(False)

# 设置是否计算变量重要性

rf.setCalculateVarImportance(True)

# 训练随机森林分类器

rf.train(data, cv2.ml.ROW_SAMPLE, responses)

# 测试分类器

test_data = np.array([[30, 70], [70, 30]], dtype=np.float32)

_, results = rf.predict(test_data)

print("Predictions:", results.ravel())

官方文档地址

,点击跳转

https://docs.opencv.org/2.4/modules/ml/doc/decision_trees.html#cvdtreeparams文章来源地址https://www.toymoban.com/news/detail-668916.html

到了这里,关于opencv 进阶20-随机森林示例的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!