前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。点击跳转到网站:https://www.captainai.net/dongkelun

前言

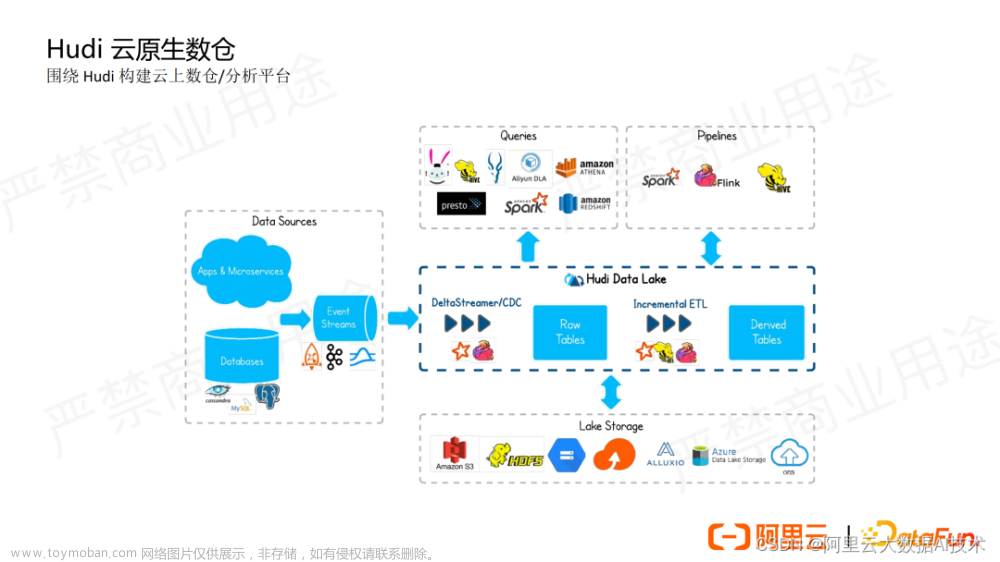

如题,记录几个Hudi Flink使用问题,学习和使用Hudi Flink有一段时间,虽然目前用的还不够深入,但是目前也遇到了几个问题,现在将遇到的这几个问题以及解决方式记录一下

版本

- Flink 1.15.4

- Hudi 0.13.0

流写

流写Hudi,必须要开启Checkpoint,这个我在之前的文章:Flink SQL Checkpoint 学习总结提到过。

如果不设置Checkpoint,不会生成commit,感觉像是卡住一样,具体表现为只生成.commit.requested和.inflight,然后不写文件、不生成.commit也不报错,对于新手来说很费劲,很难找到解决方法。

索引

hudi-flink 仅支持两种索引:FLINK_STATE和BUCKET,默认FLINK_STATE。文章来源:https://www.toymoban.com/news/detail-669363.html

最开始使用hudi是用的spark,hudi-spark支持

BL文章来源地址https://www.toymoban.com/news/detail-669363.html

到了这里,关于记录几个Hudi Flink使用问题及解决方法的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!