🥇🥇【大数据学习记录篇】-持续更新中~🥇🥇

篇一:Linux系统下配置java环境

篇二:hadoop伪分布式搭建(超详细)

篇三:hadoop完全分布式集群搭建(超详细)-大数据集群搭建

篇四:Spark Local环境搭建及测试

1.Spark Standalone环境搭建介绍

Apache Spark是目前最流行的大数据处理框架之一,可用于分布式数据处理和分析。在Standalone模式下搭建Spark集群是学习和开发Spark应用程序的良好起点。

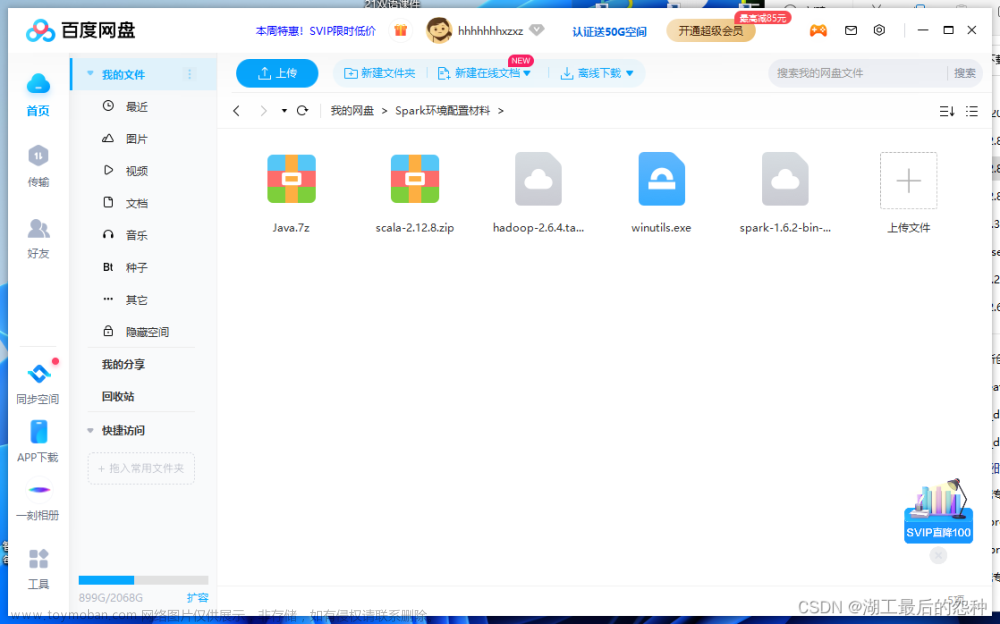

2.搭建环境准备:

本次用到的环境有:

Java 1.8.0_191

Spark-2.2.0-bin-hadoop2.7

Hadoop 2.7.4

Oracle Linux 7.4

3.搭建步骤:

1.解压Spark压缩文件至/opt目录下

tar -zxvf ~/experiment/file/spark-2.2.0-bin-hadoop2.7.tgz -C /opt

2.修改解压后为文件名为spark

mv /opt/spark-2.2.0-bin-hadoop2.7 /opt/spark

3.复制spark配置文件,首先在主节点(Master)上,进入Spark安装目录下的配置文件目录{ $SPARK_HOME/conf },并复制spark-env.sh配置文件:

cd /opt/spark/conf

cp spark-env.sh.template spark-env.sh

4.Vim编辑器打开spark配置文件

vim spark-env.sh

5.按键Shift+g键定位到最后一行,按键 i 切换到输入模式下,添加如下代码,注意:“=”附近无空格:

export JAVA_HOME=/usr/lib/java-1.8

export SPARK_MASTER_HOST=master

export SPARK_MASTER_PORT=7077

按键Esc,输入:wq保存退出

6.复制一份spark的slaves配置文件

cp slaves.template slaves

7.修改spark的slaves配置文件

vim slaves

8.每一行添加工作节点(Worker)名称,按键Shift+g键定位到最后一行,按键 i 切换到输入模式下,添加如下代码

slave1

slave2

按键Esc,输入:wq保存退出

9.复制一份spark-defaults.conf

cp spark-defaults.conf.template spark-defaults.conf

10.通过远程scp指令将Master主节点的Spark安装包分发至各个从节点,即slave1和slave2节点

scp -r /opt/spark/ root@slave1:/opt/

scp -r /opt/spark/ root@slave2:/opt/

11.配置环境变量:分别在slave1和slave2节点上配置环境变量,修改【/etc/profile】,在文件尾部追加以下内容

vim /etc/profile

按键Shift+g键定位到最后一行,按键 i 切换到输入模式下,添加如下代码

#spark install

export SPARK_HOME=/opt/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

主节点(master)上执行截图,如下:

从节点1(Slave1)上执行截图,如下:

从节点2(Slave2)上执行截图,如下:

12.按键Esc,按键:wq保存退出

13.分别在Slave1和Slave2上,刷新配置文件

source /etc/profile

14.开启standalone集群守护进程,分别开启Standalone集群的守护进程:Master和Worker。注意:需要在主节点执行该操作!

start-master.sh

start-slaves.sh

15.Spark独立集群搭建成功后,查看后台守护线程,如图所示,即Standalone模式搭建成功!!

jps

16.查看WebUI监控,独立集群管理器开启后,可以通过WebUI监控界面查看集群管理器的相关信息,地址为:http://master:8080 如图所示

17.开启spark-shell会话,向独立集群管理器提交应用,需要把spark://masternode:7070作为主节点参数传–master。指令如下

spark-shell --master spark://master:7077

文章来源:https://www.toymoban.com/news/detail-671070.html

文章来源:https://www.toymoban.com/news/detail-671070.html

所有配置完成,如果本篇文章对你有帮助,记得点赞关注+收藏哦~文章来源地址https://www.toymoban.com/news/detail-671070.html

到了这里,关于Spark Standalone环境搭建及测试的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!