llama模型

LLAMA来源与Meta的开源大模型,截止到20230720,已经有第二个版本面世,第二个版本已经支持免费商业化,所以学习llama模型无论是自我提升,还是创业都有很大的基础保障。

一些个人的观点:笔者一度觉得Meta在元宇宙领域决策的失误,可能带来一系列的灾难后果,但当前从大模型来看,Meta可能又要站在了AI的头部。你不得不去佩服扎克伯格对于未来的精准把控。

基础知识讲解

这个有很长的路要走,当前先不讲了,后面开一个专题讲讲。文章来源:https://www.toymoban.com/news/detail-674292.html

环境部署

首先在conda里面构建自己的工作环境

生成一个新的kernel环境

conda create -n py3 python=3 # 创建一个python3的环境,名为py3

source activate py3 # 激活py3环境 有可能报错,执行source activate 后再执行 conda init activate

conda install ipykernel # 安装ipykernel模块

python -m ipykernel install --user --name py3 --display-name "py3" # 进行配置

jupyter notebook # 启动jupyter notebook,然后在"新建"中就会有py3这个kernel了

在bash中切换到这个环境

# 查看conda中有哪些环境

conda env list

# 如果说activate不存在,则执行source activate 后再执行 conda init activate,再执行如下命令

conda activate py3

Llama部署

克隆项目

git clone https://github.com/pengwei-iie/llama_bugs.git

安装相关包

cd llama_bugs

pip3 install -r requirements.txt

安装相关依赖包

pip3 install -e .

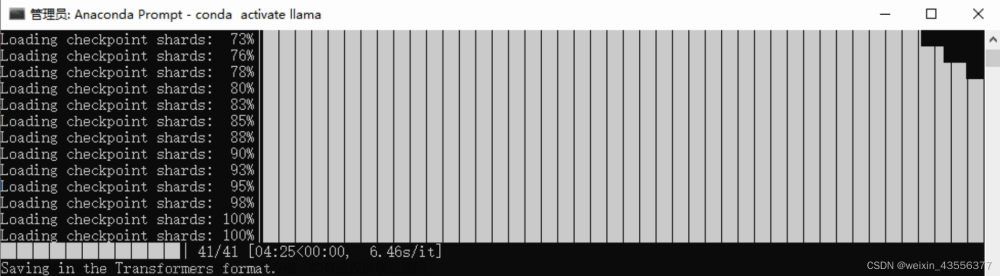

下载llama模型包

git lfs install

git clone https://huggingface.co/nyanko7/LLaMA-7B

命令行执行

torchrun --nproc_per_node 1 example.py --ckpt_dir ./LLaMA-7B --tokenizer_path ./LLaMA-7B/tokenizer.model

其中文章来源地址https://www.toymoban.com/news/detail-674292.html

- ckpt_dir 是指模型文件存放的文件夹名称

- tokenizer_path 是指分词器所存放的文件夹位置

- nproc_per_node:nproc_per_node=4:表示每个node上节点有4个process,llama-7B每个节点上只有一个process

到了这里,关于LLAMA模型部署与一些关键定义的文章就介绍完了。如果您还想了解更多内容,请在右上角搜索TOY模板网以前的文章或继续浏览下面的相关文章,希望大家以后多多支持TOY模板网!